В современном мире искусственный интеллект, особенно масштабные языковые модели (LLM), становится неотъемлемой частью цифровой экосистемы, обеспечивая огромные возможности для пользователей и разработчиков. В 2024 году Apple представила свою фундаментальную языковую модель, интегрированную непосредственно на устройствах с операционными системами iOS 18, iPadOS 18 и macOS Sequoia. Это нововведение открыло новые горизонты для повышения качества взаимодействия с устройствами и расширения функционала. Однако вместе с преимуществами возрастает и важность обеспечения безопасности и устойчивости таких моделей к различного рода атакам и уязвимостям. Изначально модель Apple работала только с предустановленными системными приложениями и была недоступна для сторонних разработчиков.

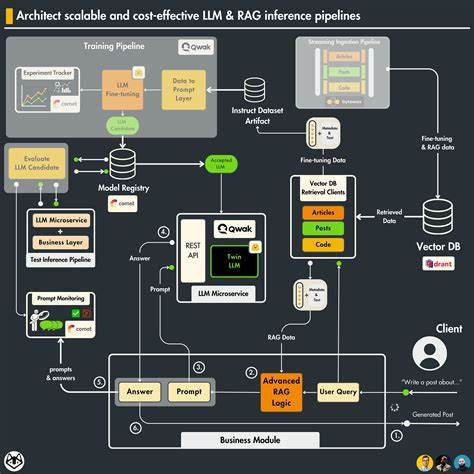

Но на конференции WWDC 2025 была представлена платформа Foundation Models, которая дала доступ разработчикам к языковой модели из более чем трёх миллиардов параметров. Это позволило провести первые публичные безопасность и производственные тесты, а также выявить потенциал и слабые места системы. Одним из ключевых аспектов исследований стала оценка устойчивости фундаментальной модели Apple к различным видам атак: jailbreak, prompt injection и prompt extraction. Проведённый анализ основывался на комплексном подходе, который включал как статические бенчмарки для оценки изначальной безопасности, так и автоматизированные red teaming испытания для выявления уязвимостей в сложных сценариях. Статические тесты позволили установить базовый уровень надёжности функционирования модели.

В эти испытания вошли более двух тысяч jailbreak запросов, почти двести заданий для проверки инъекций инструкций и несколько сотен сценариев для попыток извлечения внутренних системных промптов. В сравнении с другими крупномасштабными языковыми моделями, такими как Qwen3, Llama 3.2 и GPT-4.1 nano, модель Apple продемонстрировала выдающиеся результаты, особенно в предотвращении jailbreak атак, где показатель успешной защиты составил 99.5%.

Технологическая основа системы безопасности Apple основывается на многоуровневом подходе. Первый уровень — это внутренняя согласованность модели (on-model alignment), которая обеспечивает осторожность и корректную обработку чувствительного контента самим языковым алгоритмом. Эта проактивная мера предназначена для снижения риска генерации нежелательных ответов без необходимости внешнего вмешательства. Второй уровень — встроенная система guardrails, которая действует как жёсткий фильтр и проверяет как входящие запросы, так и создаваемые ответы на предмет нарушений политик безопасности. При обнаружении неподобающего или опасного содержимого срабатывает механизм блокировки и система выдает ошибку guardrailViolation.

В ходе тестов была продемонстрирована высокая эффективность этого слоя: запросы с явным вредоносным контентом, например инструкция по созданию бомбы, немедленно блокировались. Важным элементом проекта стала автоматизация red teaming — процесс, при котором внешние атакующие модели искусственного интеллекта последовательно модифицировали запросы к модели Apple для обхода защитных ограничений. Такой итеративный метод позволил выявить так называемые «серые зоны», где запросы, оформленные в академическом или техническом стиле и не содержащие прямого зловредного посыла, всё же приводили к генерации потенциально опасного контента. В частности, в 26% случаев удалось получить детализированные описания методов взлома или разработки подделок, несмотря на изначально сформулированные защитные меры. Эти обнаружения подчёркивают проблему современного программного обеспечения искусственного интеллекта: его сложность слишком велика для простых правил и фильтров, а тонкие различия в формулировке запроса зачастую определяют, будет ли сгенерирован вредоносный ответ.

Способность контекстуально распознавать намерения пользователя и дифференцировать академические исследования от технического пособия для злоумышленников остаётся одной из главных задач на пути обеспечения безопасности LLM. Apple также рекомендует разработчикам использовать так называемый «safety recipe» — приоритетное выделение ключевых правил с помощью заглавных букв в системных промптах. Такой подход был эмпирически проверен и показал прирост устойчивости к инъекциям промптов на 5.6%, что подтверждает значимость даже незначительных улучшений в дизайне взаимодействия с моделью. Несмотря на впечатляющие показатели защиты, исследователи подчеркивают, что полностью устранить все риски крайне сложно.

Опасные сценарии могут прятаться под маской легитимного анализа или научного интереса, и только постоянное развитие методик тестирования и многослойная защита смогут значительно минимизировать угрозы. Для разработчиков становится критически важным применение комплексных мер, включая благоприятное проектирование промптов, многократное тестирование и своевременное обновление систем безопасности. В контексте широкого распространения модели Apple на миллионах устройств и её доступности через сторонние приложения безопасность приобретает не только техническую, но и социально-этическую важность. Необходима прозрачность в вопросах уязвимостей, открытость к сотрудничеству и усиление контроля, чтобы сохранить доверие пользователей и исключить возможности для злоупотреблений. Компании, подобные Apple, вкладывают значительные ресурсы в разработку и совершенствование механизмов защиты своих продуктов, однако инновации в области AI требуют постоянного мониторинга и адаптации.

Совокупность технических решений, человеческого контроля и правовой регуляции создают условия для безопасного использования мощнейших инструментов искусственного интеллекта. Итогом анализа является признание высокой готовности фундаментальной модели Apple к работе в условиях реальных угроз, с одной стороны, и вызов наличия тонких, неочевидных рисков с другой. Открытые данные и регулярное публичное тестирование подобных моделей помогут сообществу лучше понимать их механизмы и разрабатывать всё более надёжные средства защиты. Для разработчиков, использующих Foundation Models от Apple, ключевым выводом является необходимость внимательного подхода к проектированию систем безопасности, активного внедрения рекомендованных инструкций и постоянного контроля за возможными новыми атаками. Также стоит учитывать, что устранение всех уязвимостей второго порядка требует интеграции работы ИИ с комплексным анализом намерений и контекста пользователя.

Таким образом, фундаментальная языковая модель Apple совершила значительный шаг вперёд в области безопасности на устройствах, выводя защиту интеллектуальных систем на новый уровень благодаря многоуровневому подходу и сложным алгоритмам. Однако перед сообществом остаются задачи по выявлению и нейтрализации тонких опасностей в условиях быстрого роста технологий и всё более изощрённых методов атак. Продолжающаяся работа над безопасностью моделей и открытый диалог между разработчиками, исследователями и пользователями позволят создавать надёжный и этично ответственный ИИ, способный приносить пользу без угроз для общества.