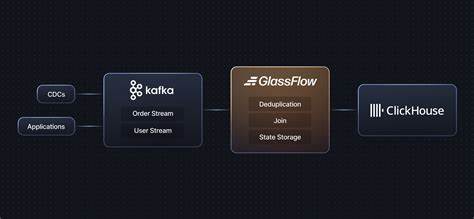

В условиях стремительно растущих объемов данных и необходимости мгновенного получения аналитики, качественная организация процесса передачи и обработки информации становится краеугольным камнем успеха многих бизнесов. Одной из популярных платформ для аналитики является ClickHouse — высокопроизводительная колоночная СУБД, способная обрабатывать огромные массивы данных с минимальной задержкой. Однако при организации потоковой обработки данных из систем сообщений, таких как Kafka, возникают серьезные сложности, связанные с дублированием событий, порядком поступления данных и обеспечением корректности итоговой информации. В ответ на эти вызовы был разработан GlassFlow — специализированный ETL-сервис для стриминг-аналитики, оптимизированный под работу с ClickHouse. Сегодня мы рассмотрим результаты нагрузочного тестирования GlassFlow в условиях реальной нагрузки и масштаба, а также оценим его влияние на эффективность построения аналитических пайплайнов.

Особенности GlassFlow и его роль в экосистеме ClickHouse GlassFlow представляет собой open-source решение, ориентированное на создание и управление потоковыми конвейерами данных между Kafka и ClickHouse. Его архитектура построена с упором на высокую производительность и надежность. Ключевыми функциональными элементами GlassFlow являются реализация дедупликации данных в реальном времени на основе уникальных идентификаторов событий, поддержка точно-однократной доставки (exactly-once semantics), а также эффективный batching и буферизация данных перед их записью в ClickHouse. В отличие от стандартных методов интеграции Kafka и ClickHouse, GlassFlow берет на себя сложные задачи по управлению состоянием, порядком обработки и повторными попытками, что позволяет обеспечивать высокую корректность данных и минимальные задержки. При этом масштабируемая архитектура позволяет гибко наращивать ресурсы для обслуживания растущих потоков данных.

Настройка нагрузочного тестирования GlassFlow Для объективной оценки возможностей GlassFlow была развернута тестовая среда с содействием Docker-контейнеров, включающая в себя Kafka для потоковой передачи событий, ClickHouse в качестве системы хранения и собственно GlassFlow в роли промежуточного обработчика. Такой локальный стенд позволил контролировать параметры окружения и добиться воспроизводимости результатов. Для моделирования реального сценария использовались синтетические данные, имитирующие пользовательскую активность в приложении. Каждый событие содержало уникальный идентификатор события и пользователя, а также временную метку и дополнительную полезную нагрузку, что отражает типичные аналитические запросы. Тестирование велось на современном MacBook Pro с процессором Apple M2 Max и 32 ГБ оперативной памяти.

Для реализации нагрузочного теста применялась конфигурация с несколькими параллельными процессами, разными объемами общего числа обрабатываемых событий (от 5 до 20 миллионов) и параметрами, контролирующими частоту публикации и дублирование сообщений. Как GlassFlow справляется с высокими нагрузками Одним из центральных вопросов было определение максимальной пропускной способности, которую GlassFlow способен выдержать без потери стабильности и увеличения задержек. В ходе экспериментов система демонстрировала стабильную обработку свыше 9 000 событий в секунду при общем входном потоке, достигающем 55 000 записей в секунду. При этом задержки обработки оставались в диапазоне менее 0.12 миллисекунд.

Интересно отметить, что GlassFlow успешно справлялся с задачей realtime дедупликации с 10% уровнем повторяющихся событий, эффективно устраняя их в пределах конфигурируемого временного окна в 8 часов. Благодаря этому достигается высокая точность аналитических данных, что критично для бизнес-приложений, где даже незначительные погрешности недопустимы. Стабильность работы системы сохранялась даже при увеличении объема данных и количестве параллельных издателей в Kafka до 12. Благодаря автоматическому управлению состоянием, очередями и ретраями GlassFlow предотвращал потерю сообщений и нарушения порядка, что подтверждается отсутствием сбоев и ошибок на протяжении всей серии нагрузочных тестов. Анализ показателей задержек и отставания Как и в любой потоковой системе, если скорость поступления сообщений в Kafka превышает пропускную способность GlassFlow, начинает нарастать лаг — задержка между появлением события в исходном потоке и его появлением в ClickHouse.

В данной реализации лаг варьировался в зависимости от нагрузки и общего объема данных, что является характерным поведением и указывает на необходимость масштабирования оборудования при увеличении потока данных. Тем не менее, благодаря грамотной архитектуре и возможности горизонтального масштабирования, GlassFlow позволяет эффективно справляться с возросшими нагрузками путем добавления дополнительных ресурсов, что делает его гибким решением для различных сценариев эксплуатации. Практические аспекты использования GlassFlow Реализация pipeline Kafka → GlassFlow → ClickHouse позволяет максимально использовать преимущества каждой компоненты стековой архитектуры. Kafka обеспечивает надежный транспорт данных с масштабируемостью и отказоустойчивостью, GlassFlow отвечает за предобработку и очистку потоков в режиме реального времени, а ClickHouse выступает мощной аналитической базой. Важным преимуществом GlassFlow является полная автоматизация создания необходимых топиков и таблиц, а также очистка окружения после тестов или выполнения задач, что избавляет от нагрузки ручного администрирования и снижает риск ошибок.

Для бизнеса такой подход открывает новые горизонты: возможность анализа событий с минимальными задержками, высокая точность данных без дубликатов и простота интеграции существующих Kafka-систем с ClickHouse с минимальными техническими усилиями. Перспективы развития и внедрения Несмотря на впечатляющие результаты, тесты GlassFlow подчеркивают важность грамотного планирования инфраструктуры. В локальном окружении максимальная производительность достигалась ограниченными ресурсами, однако переход на облачные или распределенные вычислительные среды способен существенно поднять границы производительности и снизить лаги. Планируя внедрение GlassFlow в бизнес-процессы, стоит обратить внимание на архитектуру масштабирования, настройку параметров дедупликации и мониторинг загруженности компонентов. Наличие готовых Grafana-дэшбордов и инструментов мониторинга облегчает оперативное отслеживание состояния системы и принятие своевременных решений.

Заключение GlassFlow зарекомендовал себя как надежное решение для обработки потоков данных с высокими требованиями к корректности и скорости поступления. Его успешная интеграция с ClickHouse и Kafka позволяет создавать устойчивые, масштабируемые и высокопроизводительные пайплайны, способные обрабатывать миллионы событий в реальном времени, выдерживая высокие нагрузки без потерь и с минимальными задержками. Использование GlassFlow особенно актуально для задач аналитики с критичными требованиями к качеству данных, например, в e-commerce, финансовом секторе и ИТ-мониторинге. Открытый исходный код и возможность быстрого разворачивания в различных средах делают GlassFlow привлекательной платформой как для стартапов, так и для крупных предприятий. Для желающих оценить возможности GlassFlow и построить собственные тесты доступен открытый репозиторий с полным набором скриптов и руководств.

Ознакомление с ним поможет быстрее интегрировать эту технологию в свою инфраструктуру и повысить эффективность обработки потоков данных. В мире, где миллионы событий генерируются каждую секунду, своевременная и точная аналитика становится ключевым конкурентным преимуществом. GlassFlow доказывает, что современный стриминг-ETL способен удовлетворить эти требования, позволяя бизнесу быстро реагировать на изменения и принимать обоснованные решения на основе достоверных данных.