PyTorch — это мощная и гибкая библиотека глубокого обучения, разработанная на Python, которая стремительно завоевала популярность среди исследователей и специалистов в области искусственного интеллекта. Благодаря своей простоте и при этом высокой производительности, PyTorch стал одним из основных инструментов для разработки и обучения сложных моделей, в том числе больших языковых моделей (LLM). Благодаря удобному интерфейсу и встроенному функционалу PyTorch позволяет быстро приступить к реализации нейронных сетей, не углубляясь в низкоуровневые детали вычислительных процессов. Основой PyTorch являются тензоры — многомерные массивы, которые играют ключевую роль в математических вычислениях и трансформациях данных, лежащих в основе глубокого обучения. Тензоры позволяют удобно представлять данные различных размеров и форм, будь то отдельные числа, векторы, матрицы или многомерные массивы.

В PyTorch тензоры имеют схожий синтаксис с массивами библиотеки NumPy, но при этом обладают важным преимуществом — поддержкой вычислений на GPU, что значительно ускоряет обработку больших объемов данных и обучение моделей. Работа с тензорами начинается с их создания и базовых операций над ними. В библиотеке предусмотрены различные типы данных, включая 64-битные целочисленные и 32-битные с плавающей точкой. Для оптимизации производительности и эффективности в обучении нейросетей, по умолчанию используется формат с 32-битной точностью, так как он обеспечивает баланс между достаточной точностью и экономным потреблением памяти. Более того, PyTorch позволяет легко преобразовывать типы данных тензоров для достижения нужного уровня точности или совместимости с аппаратным обеспечением.

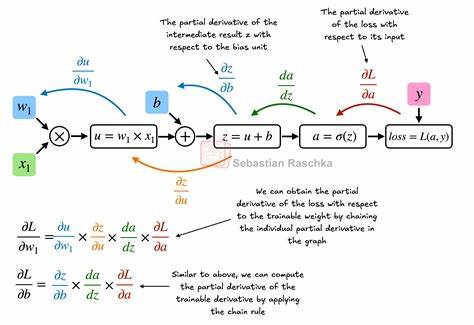

Следующий важный компонент PyTorch — автоматическое дифференцирование с помощью механизма autograd. Благодаря нему, пользователи не нуждаются в ручных вычислениях градиентов для оптимизации нейронных сетей. PyTorch самостоятельно строит динамический граф вычислений, отслеживает операции над тензорами и автоматически вычисляет необходимые производные. Это освобождает разработчиков от сложных математических расчетов, позволяя сосредоточиться на архитектуре модели и процессах обучения. Для построения моделей глубокого обучения PyTorch предоставляет удобный класс torch.

nn.Module, позволяющий создавать сложные многослойные нейронные сети. Благодаря модульной структуре, разработчики могут описывать любые архитектуры, описывая слои в специальном методе и определяя вычислительный процесс в функции прямого прохода. Для упрощения кодирования часто используется контейнер Sequential, который последовательно объединяет несколько слоев и функций активации. Процесс тренировки модели в PyTorch тесно связан с моделью, оптимизатором и функцией потерь.

Основная идея заключается в подаче данных батчами из датасета, вычислении предсказаний модели, определении ошибки и корректировке весов через обратное распространение ошибки с помощью метода backward. Оптимизаторы, например SGD, автоматизируют обновление параметров на основе величин градиентов и учат модель лучше обобщать данные. В PyTorch предусмотрены инструменты для эффективной организации процесса обучения, включая очистку градиентов после каждого шага, что предотвращает нежелательное накопление и искажение результатов. Организация эффективной загрузки данных в процессе обучения играет не менее важную роль, чем сама модель. В PyTorch для этой цели используются классы Dataset и DataLoader.

Dataset определяет логику доступа к данным, а DataLoader отвечает за формирование батчей, случайную перестановку данных и параллельную загрузку с использованием нескольких потоков. Это позволяет быстро и удобно работать с большими объемами данных, обеспечивая непрерывность подачи данных в модель без простоев. Современный тренд в обучении нейронных сетей — использование графических процессоров (GPU), которые способны значительно ускорить вычисления благодаря многопоточности и параллельной обработке. PyTorch изначально предоставляет простые механизмы для переноса моделей и данных на GPU с помощью метода .to().

При этом важно, чтобы все операции и тензоры находились на одном устройстве, иначе возникнет ошибка вычисления. Позволяет легко переключаться между CPU и GPU, что особенно полезно для разработки и тестирования моделей. Обучение на одном GPU уже является большим шагом к ускорению, но еще более эффективным становится распределенное обучение на нескольких GPU. В PyTorch реализован механизм DistributedDataParallel (DDP), который автоматически распределяет модель и данные по нескольким устройствам. Каждое устройство выполняет свой процесс, получая непересекающиеся части данных, вычисляет градиенты независимо, а затем происходит синхронизация параметров между копиями модели.

Это значительно уменьшает время обучения больших моделей. Для корректного функционирования DDP необходимо инициализировать группу процессов, распределить данные с помощью специального samplera и обеспечить синхронизацию. PyTorch предлагает удобный API и утилиту torchrun, которая автоматизирует запуск множества процессов, каждый из которых будет контролировать свою GPU. Разработка такого решения требует некоторого опыта работы с многопроцессорностью и распределёнными вычислениями, но взамен дает существенный прирост производительности. Важно помнить, что использование DDP не всегда подходит для интерактивных сред, таких как Jupyter Notebook, из-за особенностей их работы с процессами.

Для обучения на нескольких GPU рекомендуется запускать скрипты из командной строки, особенно в продакшн-окружениях. Кроме того, PyTorch поддерживает работу с графическими процессорами Apple Silicon, предоставляя инструменты для использования встроенных GPU Apple, что расширяет возможности для пользователей Mac. Поддержка и совместимость с различными аппаратными платформами постоянно улучшается, что делает PyTorch универсальной библиотекой для широкого круга задач. Заключительный этап работы с моделями — сохранение и загрузка параметров. PyTorch использует формат state_dict, представляющий собой словарь с весами и значениями смещений всех слоев модели.

Его можно сохранить на диск и при необходимости восстановить, загружая на новую инстанцию модели, что облегчает перенос и повторное использование обученных моделей. Подробное знакомство с основами PyTorch — от тензоров до сложных моделей и работы с несколькими GPU — позволяет новичкам быстро освоить инструментарий и приступить к созданию реальных приложений. Такая базовая уверенность — ключ к эффективному использованию машинного обучения и развитию собственных проектов в области искусственного интеллекта. При этом PyTorch предлагает баланс удобства и возможностей, позволяя легко начать и в дальнейшем масштабироваться до самых амбициозных задач. Для желающих углубить знания существуют обширные ресурсы и курсы, а также активное сообщество разработчиков, поддерживающих библиотеку.

PyTorch продолжает активно развиваться, интегрируя новые методы, алгоритмы и подходы, что гарантирует современную и конкурентоспособную платформу для искусственного интеллекта. Использование GPU и распределенного обучения открывает новые горизонты в скорости и эффективности, позволяя решать проблемы, ранее считавшиеся слишком сложными или ресурсоемкими. Таким образом, освоив базовые концепции PyTorch, вы откроете себе путь к современным технологиям машинного обучения и глубинного обучения, которые находят применение в самых разных областях, от прогнозирования и анализа данных до создания умных помощников и генеративных моделей. Этот путь начинается с понимания тензоров, простых операций и основ построения сети, переходя к эффективному обучению и масштабированию вычислений.