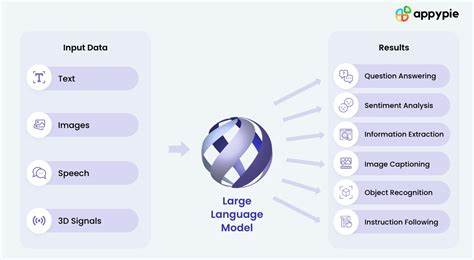

В последние годы большие языковые модели (БЯМ) стали основой многих прорывных технологий в сфере искусственного интеллекта. Их предварительная подготовка на обширных наборах данных позволяет достигать высоких результатов при генерации текста и понимании человеческой речи. Однако наличие универсальных знаний зачастую недостаточно для решения конкретных задач, требующих специализированных навыков и глубокого понимания предметной области. Именно здесь встает вопрос тонкой настройки моделей — дообучения с целью повышения их эффективности в определенных направлениях работы. Проблема тонкой настройки современных больших языковых моделей заключается в их исключительно масштабных размерах и вычислительной нагрузке, необходимой для обучения.

Полная переобученность модели является ресурсоемкой, что зачастую недоступно для многих исследовательских и коммерческих организаций. До недавнего времени самым популярным решением этой задачи была методика LoRA (Low-Rank Adaptation), появившаяся в 2022 году. Она позволила находить небольшой набор ключевых параметров, которые можно настроить без изменения всей модели, что существенно снижает затраты ресурсов. Тем не менее за прошедшие годы попытки улучшить LoRA столкнулись с серьезными трудностями. Новые методы либо требовали значительно больших вычислительных мощностей, либо не обеспечивали заметного прироста производительности при тех же ресурсах.

В этих условиях группа исследователей из Северо-Каролинского государственного университета предложила инновационную методику WeGeFT (Weight-Generative Fine-Tuning), способную эффективно оптимизировать производительность модели без возрастания расходов на вычисления. Уникальность WeGeFT заключается в том, что эта методика не просто выбирает параметры для настройки, но еще и анализирует, какие из них модель уже «знает», а какие придется «изучать». Таким образом, вес придается более значимым, новым параметрам, которые действительно влияют на улучшение работы в конкретных задачах. Такой подход позволяет достигать лучших результатов по сравнению с LoRA, при этом не увеличивая требования к вычислительной мощности. В рамках экспериментальной проверки WeGeFT продемонстрировала превосходство не только над LoRA, но и над множеством ее вариантов в различных сферах применения.

Среди задач, в которых была протестирована новая методика, — здравый смысл, арифметические вычисления, выполнение инструкций, генерация программного кода и визуальное распознавание. Именно такой широкий спектр доказывает универсальность и стабильность работы метода WeGeFT. Разработка WeGeFT не просто технический шаг вперед, но и открывает перспективы для повышения безопасности и этичности искусственного интеллекта. По словам одного из авторов исследования, будущие задачи будут связаны с использованием этой методики для выявления и редактирования параметров, ответственных за порождение вредных или нежелательных выходных данных модели. Это в свою очередь способствует улучшению так называемой AI-выравненности, т.

е. соответствия результатов работы искусственного интеллекта этическим и социальным нормам. Статья с описанием метода WeGeFT была представлена на Международной конференции по машинному обучению в июле 2025 года. Такая престижная площадка еще больше подчеркивает важность и актуальность работы ученых из Северной Каролины. Кроме того, исследование получило поддержку как от Национального научного фонда США, так и от Армейского исследовательского управления, что свидетельствует о значимости проекта для стратегического развития технологий искусственного интеллекта.

Научная новизна WeGeFT заключается в сбалансированном подходе к адаптации параметров модели через простую низкоранговую формулу, включающую две линейные слоя, которые могут быть разделены или объединены при обучении разных уровней модели. Такая архитектура способствует эффективному использованию памяти и вычислительных ресурсов, сохраняя или превосходя показатели производительности предшественников. В современном мире, где искусственный интеллект становится все более интегрированным во многие сферы жизни, от медицины до автомобильной промышленности, вопросы оптимизации и тонкой настройки моделей приобретают особую значимость. Экономия вычислительных ресурсов и повышение качества работы сокращают затраты на разработку и открывают модели для более широкого круга пользователей, что в конечном итоге приводит к более быстрому внедрению инноваций и технологическому прогрессу. Введение WeGeFT можно рассматривать как один из ключевых этапов в эволюции обучения больших языковых моделей.

Помимо технических преимуществ, ученые подчеркнули, что данный метод стимулирует дальнейшие исследования в направлении разграничения параметров моделей, что способствует не только повышению их точности и эффективности, но и повышению безопасности при использовании ИИ в реальных приложениях. Новые возможности, открывающиеся с WeGeFT, в том числе оптимизация моделей для работы с изображениями и кодом, расширяют сферы применения искусственных интеллектов, делая их инструментами многозадачности и глубокой адаптации под нужды пользователей. Особенно важными являются перспективы использования WeGeFT для снижения барьеров входа в разработку сложных решений — компании и исследователи с ограниченными ресурсами смогут более эффективно настраивать большие модели под свои задачи. Таким образом, метод Weight-Generative Fine-Tuning представляет собой инновационный и многообещающий подход к обучению и адаптации больших языковых моделей. Он успешно решает проблематику высокой вычислительной нагрузки, сохраняет или улучшает производительность и открывает новые возможности для дальнейшего улучшения и безопасного использования искусственного интеллекта во всех ключевых отраслях.

В условиях стремительного роста качества и количества ИИ-приложений подобные технологические достижения становятся неотъемлемой частью будущего цифрового мира.