В мире искусственного интеллекта и обработки естественного языка актуальность эффективных и быстрых языковых моделей неуклонно растет. Особенно востребованы модели, способные не просто генерировать текст, а глубоко анализировать и рассуждать, предлагая высококачественный и осмысленный результат. Одной из таких передовых моделей является DeepSeek-R1-Distill-Qwen-7B — улучшенная, облегчённая версия оригинальной DeepSeek-R1, отличающаяся компактностью и оптимизированной для более быстрой работы. Однако вопрос оптимизации этой модели для промышленного использования по-прежнему остается актуальным и требует значительных усилий, как с аппаратной, так и с программной сторон. Глубокое понимание этого процесса может не только помочь в интеграции модели в реальные продукты, но и вывести производительность на совершенно новый уровень.

Первоначально стоит отметить, что одним из вызовов при использовании reasoning моделей, к которым относится DeepSeek-R1-Distill-Qwen-7B, является их высокая задержка отклика. В отличие от традиционных языковых моделей, reasoning модели не стремятся сразу выдать ответ, а сначала проходят через этап генерации так называемых «думательных токенов». Это фактически последовательность промежуточных вычислений и размышлений, которые увеличивают качество и точность итоговой выдачи, но существенно замедляют время отклика — иногда до нескольких секунд и более. Для интерактивных приложений с высокими требованиями к скорости подобные задержки неприемлемы. Инженеры и исследователи, работающие над улучшением DeepSeek-R1-Distill-Qwen-7B, сделали акцент на снижении времени генерации одного токена до 3 миллисекунд, что является значительным достижением в области обработки больших языковых моделей (LLM).

Достичь такого результата позволил комплекс из нескольких инновационных подходов, которые мы рассмотрим подробнее. Одним из фундаментальных направлений оптимизации стала квантование модели. Оно позволяет существенно уменьшить размер параметров без значительных потерь в качестве. В случае DeepSeek-R1-Distill-Qwen-7B применялось консервативное квантование с плавающей точкой 8 бит (FP8), вместо исходных 16 бит. Такая мера уменьшила объем данных, которые нужно передавать с памяти графического процессора (GPU), что критично для скорости работы.

К тому же, современные графические процессоры Nvidia, особенно семейство Hopper, в том числе модель H200, поддерживают аппаратное ускорение операций с FP8, что обеспечивает дополнительное ускорение вычислений. Тесты на стандартных бенчмарках подтвердили, что снижение точности практически не повлияло на качество вывода, а задержки были сокращены почти в два раза. Еще одним ключевым решением стал переход на low latency kernels — низколатентные вычислительные ядра при построении TensorRT-LLM движка для инференса. Это решение позволило минимизировать задержки за счет оптимизированных операций умножения матриц (GEMM) и функций активации, соответствующих FP8 квантованным моделям. В итоге скорость генерации одного токена уменьшилась более чем на 20%, что вместе с квантованием дало значительный прирост общей производительности.

Важную роль в ускорении сыграла параллелизация тензорных вычислений на нескольких GPU. DeepSeek-R1-Distill-Qwen-7B имеет 28 голов внимания, что позволило распределить нагрузку на 4 графических процессора. Такая организация работы обеспечивает сокращение вычислительного времени, хоть и с определенными ограничениями, связанными с синхронизацией между устройствами и накладными расходами на коммуникацию. Тем не менее, в совокупности с другими оптимизациями, этот шаг позволил сократить время отклика до 3,1 миллисекунды на один токен — результат, близкий к теоретическому пределу, определенному скоростью передачи данных с памяти графического процессора. Не менее важным был переход к раздельному обслуживанию фаз prefill и decode — этапов предобработки и генерации токенов.

Отделение этих задач на разные GPU или серверы позволило более эффективно распределять вычислительные ресурсы и предотвращать ухудшение задержек при одновременной работе с несколькими сессиями. Особенно это актуально для приложений с большим количеством параллельных запросов, где без такого разделения система сталкивается с резкими колебаниями времени отклика, что негативно сказывается на пользовательском опыте. Тем не менее, несмотря на достигнутые успехи, практика эксплуатации таких reasoning моделей сталкивается с серьезными ограничениями, которые связаны с ростом KV-кеша — структуры, отвечающей за хранение промежуточных вычислений в механизме внимания. Длина последовательности и количество параллельных запросов напрямую влияют на размер KV-кеша, который требует значительных объемов памяти и пропускной способности. Квантование KV-кеша оказалось крайне сложным, так как попытки снизить точность этого кеша приводили к драматическому ухудшению качества модели.

Поэтому даже при оптимальных параметрах модели проблему расширения и нагрузки на память в полном объеме решить пока не удалось. Помимо технических аспектов важным остается и экономический фактор. Использование топового оборудования H200 с 4- или 8-ми GPU в продуктивной среде связано с высокими затратами, которые в пересчете на обработку одного запроса достигают около одного цента. Для некоторых приложений, особенно требовательных к качеству и комплексному рассуждению, такие затраты оправданы, учитывая уникальные возможности reasoning моделей. Однако для масштабного развертывания необходимы продуманные стратегии балансировки нагрузки, включая интеллектуальное распределение запросов, чтобы оптимально использовать ресурсы и избежать чрезмерной конкуренции за память и вычислительные единицы.

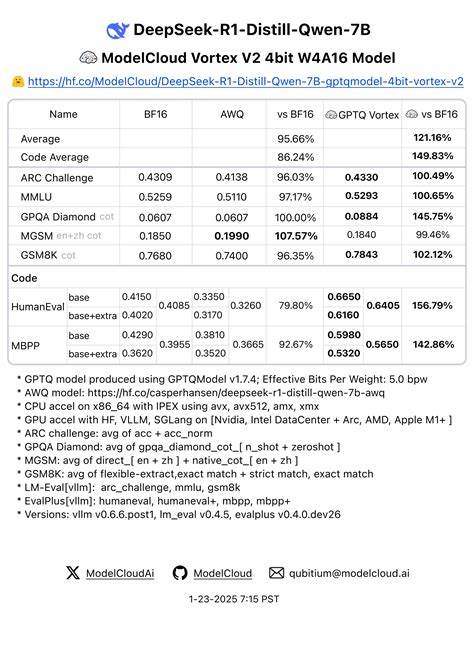

Перспективы дальнейшего развития видятся в области более агрессивного квантования — вплоть до 4 бит — с использованием современных методов AWQ и GPTQ. Такие подходы позволят дополнительно уменьшить размеры моделей и карту памяти, но потребуют тщательной проработки для сохранения качества. Кроме того, выход новых поколений GPU, например Blackwell B200, с увеличенной пропускной способностью памяти и поддержкой вычислений в формате FP4 откроет новые горизонты для снижения задержек и энергопотребления. Интересное направление — обучение кастомных speculative decoding моделей, которые могут генерировать несколько токенов за один проход, прогнозируя наиболее вероятные варианты и значительно сокращая время отклика. Несмотря на сложности с их адаптацией под DeepSeek-R1-Distill-Qwen-7B, перспективы интеграции таких моделей в будущем обещают существенный рост производительности.

В заключение, оптимизация DeepSeek-R1-Distill-Qwen-7B для использования в продакшене — это комплексный процесс, сочетающий квантование, аппаратные улучшения, специальные вычислительные ядра, распределённый расчет и умное управление памятью. Это не просто набор технических решений, а продуманный и сбалансированный подход, позволяющий сделать reasoning модели практически применимыми для интерактивных и масштабируемых приложений. Результаты, достигнутые в снижении времени отклика до 3 миллисекунд на токен, открывают двери к новым возможностям в области искусственного интеллекта и машинного обучения, позволяя решать задачи, которые ранее казались слишком сложными или ресурсоёмкими для реального времени.