В последние годы открытая архитектура RISC-V привлекла значительное внимание разработчиков аппаратного и программного обеспечения благодаря своей модульности, гибкости и расширяемости. Одной из перспективных областей применения RISC-V являются искусственный интеллект и машинное обучение, в частности, запуск и оптимизация больших языковых моделей (LLM) на RISC-V процессорах с поддержкой векторных инструкций. В этой статье мы подробно рассмотрим, как скомпилировать высокоуровневую модель, такую как BERT, в эффективный код для архитектуры RISC-V с использованием современных инструментов компиляторов и фреймворков. Архитектура RISC-V и векторное расширение Архитектура RISC-V основана на принципах RISC и является открытой, что позволяет свободно применять, модифицировать и расширять её под разные задачи. Уникальная особенность RISC-V — модульность, что дает возможность включать только необходимые расширения в конкретные процессорные решения.

Одним из таких расширений является векторное (Vector Extension, RVV), которое обеспечивает параллельную обработку данных в регистрах фиксированного или настраиваемого размера. Это играет ключевую роль в системах глубокого обучения, где требуется высокая производительность при работе с матрицами и тензорами. Векторные инструкции RISC-V позволяют выполнять операции одновременно над несколькими элементами данных, что ускоряет вычисления и повышает энергоэффективность, особенно в задачах с большими объемами численных операций. Конфигурация RVV поддерживает различные длины векторных регистров и гибкую настройку коэффициента LMUL, позволяя адаптировать аппаратное обеспечение под конкретные требования модели или алгоритма. Инструменты для компиляции LLM на RISC-V Для перевода сложных моделей глубокого обучения в исполняемый код, пригодный для архитектуры RISC-V, используются промежуточные представления и компиляторы с поддержкой ML-семантики.

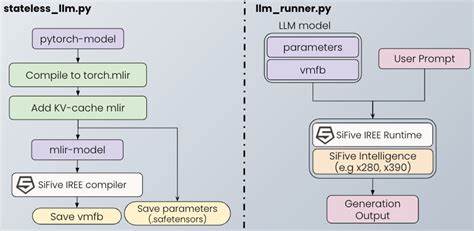

В экосистеме современного ML компилирования ключевую роль играют MLIR (Multi-Level Intermediate Representation) от команды LLVM и проект IREE (Intermediate Representation Execution Environment). Эти инструменты обеспечивают декларативное описание модели и её поэтапное преобразование для достижения максимальной производительности на целевом железе. MLIR предоставляет множество специализированных диалектов — доменно-специфичных языков, представляющих модели и операции на разных уровнях абстракции. Для нейронных сетей одним из таких диалектов является STABLEHLO (также известный как MHLO), где модели представлены в виде операндов и операторов высокого уровня, при этом сохраняя переносимость и оптимизируемость. Чтобы начать работу, необходимо установить Anaconda для управления средами и пакетами Python, затем установить pip пакеты IREE-компилятора и runtime.

Для сборки и использования LLVM с поддержкой RISC-V нужно скачать исходники, собрать необходимый набор инструментов с помощью CMake с включением проектов Clang и LLD для компиляции и линковки. Процесс компиляции модели Первым этапом является подготовка и конвертация модели, например BERT, в MLIR-диалект STABLEHLO. Используя библиотеку torch_mlir, можно обернуть модель для устранения проблем с множественными возвращаемыми значениями и сгенерировать высокоуровневое MLIR-представление, подходящее для дальнейшей компиляции. Важно подготовить корректные входные данные — в случае BERT это будут случайные индексы токенов из словаря модели. Далее с помощью утилиты iree-compile происходит поэтапное понижение MLIR кода до машинных инструкций и связывание с runtime-библиотеками.

Ключевые параметры компиляции указывают целевую архитектуру (riscv64), набор инструкций и расширений (+m, +a, +f, +d, +v и другие), ABI, а также настройки векторного исполнения, включая максимальный LMUL и минимальное количество бит вектора. Это позволяет создавать оптимизированный бинарный файл, компактно упакованный и готовый для запуска на RISC-V устройстве. Анализ и оптимизация сгенерированного кода Для изучения внутренностей конечного файла, содержащего исполняемый векторный код, удобно использовать инструменты вроде llvm-objdump, которые позволяют увидеть дизассемблированный текст и убедиться в наличии и использовании векторных команд vset, vload, vstore и арифметических операций. Это помогает верифицировать правильность генерации кода и его оптимальность. При необходимости можно адаптировать параметры компиляции, изменить ограничения длины вектора, включать дополнительные оптимизации LLVM, или настраивать ABI под особенности целевого процессора, например, изменяя поддержку атомарных операций или плавающих точек.

Практическое применение и перспективы Компиляция крупных языковых моделей на RISC-V становится актуальной задачей с ростом интереса к открытым аппаратным решениям для искусственного интеллекта. Использование векторного расширения позволяет ускорить обработку данных без необходимости использования энергозатратных GPU или специализированных ускорителей. Встраиваемые устройства, IoT, а также периферийные AI-модули выигрывают от энергоэффективности и гибкости RISC-V. Сообщество продолжает развивать поддержку RISC-V в LLVM и MLIR, что способствует появлению новых возможностей для оптимизации и расширения функциональности CPU и сопроцессоров. Также активно ведется работа с компиляторами высокоуровневых языков и фреймворков как TensorFlow и PyTorch, что приводит к более плотной интеграции алгоритмов машинного обучения с аппаратными возможностями.

Заключение Компиляция LLM, таких как BERT, для архитектуры RISC-V с использованием современных инструментов MLIR и LLVM — это перспективный и многоступенчатый процесс, позволяющий получать высокопроизводительный и энергоэффективный код с поддержкой векторных операций. Векторное расширение RISC-V, в сочетании с мощными компиляторами, открывает новые горизонты для разработчиков систем глубокого обучения на открытых аппаратных платформах. Использование IREE, torch_mlir и LLVM позволяет создать стабильный и управляемый процесс трансформации модели, при этом сохраняя переносимость и масштабируемость решения. Если вам важна свобода выбора архитектуры и гибкость настройки — RISC-V с векторным расширением и связанной экосистемой компиляторов станет отличным выбором для реализации современных AI-решений.