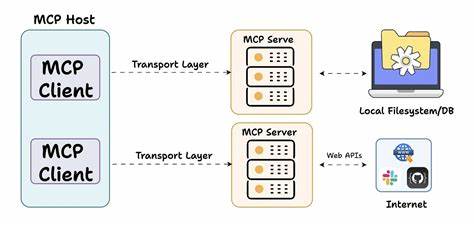

В современном мире программирования и разработки искусственного интеллекта всё большую популярность приобретают протоколы и инструменты, позволяющие легко интегрировать большие языковые модели (LLM) в разнообразные решения. Одним из подобных инструментов является MCP-123 — лаконичный и удобный сервер и клиент MCP, который можно запустить всего в пару строчек кода. Особенность MCP-123 — простота настройки и ориентация на максимально беспроблемную работу под Windows. Это даёт разработчикам мощный инструмент для быстрой реализации проектов, связанных с обработкой данных и взаимодействием с AI через OpenAI API. MCP (Model Context Protocol) — стандарт, который направлен на обеспечение эффективного взаимодействия между языковыми моделями и внешними функциями или инструментами.

MCP-123 опирается на эти принципы и делает их доступными даже для тех, кто не хочет углубляться в сложности инфраструктуры. С MCP-123 не придется создавать сложные обвязки или писать дополнительные схемы и настройки. Создание сервера сведено к написанию нескольких функций с логикой, которую вы хотите использовать, в отдельном файле tools.py. Эти функции автоматически подхватываются сервером MCP и становятся доступны клиенту без дополнительного вмешательства.

Это кардинально снижает входной порог для разработчиков и позволяет быстрее приступить к решению задач. Особое внимание в MCP-123 уделено интеграции с OpenAI. Клиентская часть использует ваш API ключ OpenAI для обработки запросов, при необходимости вызывая нужные функции с сервера. Такой подход даёт гибкость — клиент работает с языковыми моделями, а сервер расширяет концепцию с помощью пользовательских инструментов. MCP-123 разработан на Python версии 3.

11 и выше и предлагает простой процесс установки через менеджер пакетов pip с использованием requirements.txt. Это позволяет без лишних хлопот развернуть рабочее окружение, необходимое для запуска как сервера, так и клиента. Чтобы начать работу с MCP-123, достаточно создать файл инструментов, где описать необходимые функции. Эти функции могут выполнять различные задачи: от простых арифметических операций до сложных вызовов и обработки данных.

Достаточно просто листать файл, и все находятся автоматически. Запуск сервера и клиента — буквально несколько строк кода. Например, сервер запускается командой, которая импортирует сервер из MCP-123 и вызовом run_server с указанием файла инструментов и порта. Клиент подключается к серверу с использованием URL и вашего OpenAI ключа. Разработчики отмечают, что такой упрощённый подход позволяет при минимальных усилиях создавать рабочие прототипы и инструменты для решения реальных задач.

MCP-123 может стать связывающим звеном между AI и внутренними инструментами вашей компании или личным проектом. Среди достоинств отмечается отсутствие необходимости использования специальных обёрток или декораторов в коде инструментов. Достаточно описать обычные функции, что значительно упрощает цикл разработки. Это также обеспечивает расширяемость — добавление новых возможностей сводится лишь к написанию новых функций в файл tools.py.

Важно отметить, что MCP-123 ориентирован на разработчиков, предпочитающих максимально прозрачную и гибкую среду без дополнительного шаблонного кода. Интерфейс взаимодействия построен вокруг HTTP протокола, что облегчает интеграцию и отладку, а также совместимость с различными платформами. Что касается практического применения, MCP-123 отлично подходит для прототипирования и быстрого запуска сервисов с использованием возможностей LLM, например, для построения чат-ботов, систем подсказок или автоматизации рутинных задач. Наличие готовой интеграции с OpenAI открывает доступ к современным языковым моделям без дополнительной настройки. Проект находится на GitHub, где его можно найти под именем Tylersuard/MCP-123.

Тем, кто хочет испытать MCP-123 в деле, предлагается инструкция по установке зависимостей, созданию инструментов, запуску сервера на локальном хосте и работе с клиентом. При запуске клиент выводит информацию о доступных на сервере инструментах и позволяет отправлять запросы, которые обрабатываются с привлечением функций из tools.py и языковой модели OpenAI. Такая модель работы обеспечивает гибкий и мощный инструмент для создания интеллектуальных сервисов. Также отмечается, что проект построен с использованием FastMCP и вдохновлён протоколом MCP.

![Telli (YC F24) Is Hiring Engineers [On-Site Berlin]](/images/6325EFBB-0EB8-46CA-BAE3-2BB261C70829)