В мире информационных технологий каждая деталь играет важную роль, особенно когда речь идет о способах представления текста и символов в компьютерах. Одним из наиболее важных достижений в этой области является кодировка UTF-8 - универсальный формат, который стал стандартом для обмена текстом в интернете и современном программном обеспечении. В основе этой кодировки лежит история, которую рассказывает Роб Пайк, выдающийся разработчик и один из создателей UTF-8. Его рассказ открывает завесу над моментом создания стандарта, а также показывает, почему UTF-8 стал таким значимым и революционным. Появление UTF-8 тесно связано с командой разработчиков Plan 9, операционной системы из Bell Labs, куда входили Роб Пайк и Кен Томпсон.

Они столкнулись с необходимостью создания эффективной и универсальной системы кодирования символов, которая была бы совместима с уже существующими архитектурами и в то же время удовлетворяла требования многоязычия. Используемая тогда стандартная кодировка Unicode, именуемая UTF, предполагала 16-битное представление символов и казалась неудобной и неэффективной для их нужд. Согласно воспоминаниям Роба Пайка, создание UTF-8 произошло спонтанно и быстро - за один вечер в обычном американском ресторанчике в Нью-Джерси в сентябре 1992 года. Кен Томпсон предложил идею битовой разметки, которая позволила бы кодировать символы переменной длины, сохраняя при этом совместимость с ASCII. После этого они оперативно направили предложение в X/Open, международную организацию, которая занималась стандартизацией, с просьбой оценить и, возможно, внедрить их идею.

Реакция была очень положительной - их кодировка была признана более совершенной по сравнению с предыдущими разработками. Разработка реализации UTF-8 после этого продвигалась стремительно: на доработку кода и адаптацию систем ушло всего несколько дней. К концу недели Plan 9 уже успешно работала с UTF-8 в качестве основной формы кодирования текста. Это позволило им обеспечить синхронизацию потока байтов так, чтобы даже при чтении с середины последовательности символов можно было быстро определить начало следующего символа. Такой подход был необходим для надежной обработки текста в файловых системах и приложениях.

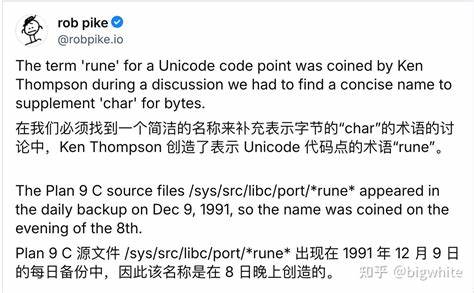

Важный аспект, который подчеркивает Роб Пайк, - это распространенное заблуждение о том, что IBM изобрела UTF-8 и Plan 9 лишь реализовала идею. Это неверно. На самом деле разработка произошла именно в Bell Labs, а X/Open и представители IBM сыграли роль среды, которая поддержала и помогла протестировать и внедрить новшество. Благодаря этому, UTF-8 стал открытым стандартом, который приобрел широкое распространение во всем мире. Технически UTF-8 представляет собой кодировку переменной длины, в которой первые 128 символов (ASCII) кодируются одним байтом, а остальные - последовательностями из двух и более байтов.

Такая архитектура обеспечивает совместимость с существующим программным обеспечением и сетями. Кроме того, кодировка позволяет легко определять начало символа по первому байту, упрощая обработку текста. В сравнении с более старыми методами UTF-8 вызывает меньше ошибок сопоставления и эффективнее использует память. Разработка UTF-8 была мотивирована рядом конкретных целей и требований. Во-первых, кодировка должна была совмещать универсальность UCS (Universal Character Set) с практичностью работы в привычных операционных системах, которые не поддерживали символы с нулевыми байтами или определенными управляющими символами.

Во-вторых, необходимо было сделать кодировку обратимо-конвертируемой и простой для реализации, чтобы облегчить переход на новую систему. Особое внимание уделялось совместимости с историческими файловыми системами и программами. Старые файловые системы не допускали использования нулевого байта или символа слэша в именах файлов, что создавало преграды для хранения всех символов UCS. Новая кодировка решала эти проблемы, обеспечивая удобное и гибкое представление символов без нарушения существующей инфраструктуры. Это открыло путь к поддержке многоязычного текста на уровнях файловых систем, терминалов и протоколов.

Интересно, что первоначальный протокол кодирования UCS существовал в более громоздкой и менее удобной форме, известной как FSS-UTF - "File System Safe UTF". Этот вариант был предложен IBM и отражал шаг к унификации, но имел существенные недостатки, главным из которых была неконтролируемая сложность и меньшее удобство для быстрой синхронизации в потоке байтов. Именно поэтому разработчики Plan 9 решили создать свою версию, которая в итоге стала UTF-8, оптимальной и простой в реализации. Понимание того, как был сформирован UTF-8, также помогает осознать, почему кодировка так широко принята и использует самые современные стандарты в интернете, мобильных устройствах и программном обеспечении. Её гибкость и надежность сделали возможным обмен данными между системами, говорящими на различных языках, и позволили преодолеть ограниченность старых кодировок, которые поддерживали лишь отдельные языковые группы.

Современный мир без UTF-8 был бы существенно ограничен, ведь именно эта кодировка лежит в основе большинства веб-страниц, электронной почты и файлов, которые ежедневно обрабатываются миллиардами пользователей. Благодаря простой и понятной концепции, заложенной в 1992 году, цифровая коммуникация стала по-настоящему глобальной. Рассказ Робa Пайка позволяет не только оценить технические решения, но и понять культурный и человеческий аспект создания технологий. Разработка UTF-8 - пример того, как настойчивость, креативность и способность работать в сжатые сроки приводят к возникновению инноваций, которые меняют индустрию. Сегодня UTF-8 продолжает развиваться и составлять основу для новых стандартов обработки текста.

Его история напоминает нам о важности открытых инициатив и сотрудничества в мире технологий, где даже простая идея, возникшая за ужином в маленьком ресторанчике, может стать фундаментом для изменений в масштабах всего мира. .