Современные большие языковые модели (LLM) кардинально изменили способы взаимодействия человека с технологиями, предоставляя инструменты для автоматизации, коммуникации и творчества. Их успех в значительной степени обусловлен качеством и количеством данных, на которых они обучаются. Особенно остро стоит вопрос многоязычного обучения: как создать эффективные модели для сотен языков, многие из которых имеют ограниченное цифровое присутствие? Недавно команда учёных и инженеров сделала важный шаг вперёд, представив новый подход к сбору и обработке данных и создав огромный многоязычный датасет FineWeb2 объемом 20 терабайт, включающий около пяти миллиардов документов с более чем 1000 языков. Это событие становится отправной точкой для построения более универсальных и справедливых языковых моделей, способных понимать и генерировать текст на самых разных языках мира, независимо от их распространённости или цифровой представленности. Работа, лежащая в основе FineWeb2, была описана в исследовании, опубликованном на arXiv летом 2025 года группой, включающей таких исследователей, как Гильерме Пенедо, Хинек Кидличек, Винко Саболчец и других.

Их целью стало преодоление существующих ограничений при создании многоязычных датасетов: сложностей адаптации фильтрации и дедупликации текстов для тысяч языков. Используемые ранее методы часто ориентировались на английский язык или несколько популярных языков, что приводило к недостаточному качеству данных для менее распространённых языков и, как следствие, к снижению качества обучения моделей на этих языках. Команда разработала специализированный конвейер обработки данных, который может автоматически подстраиваться под любой язык и учитывать уникальные особенности каждого из них, будь то морфология, орфография или структурные особенности текста. Главной инновацией нового конвейера стала возможность тонкой настройки этапов очистки данных и удаления повторов с применением универсальных критериев, основанных на характеристиках самих текстов, а не только на языке. Это позволило существенно улучшить качество датасетов для языков с ограниченными ресурсами, а не просто увеличить их объём.

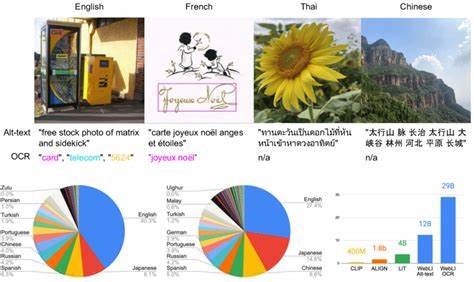

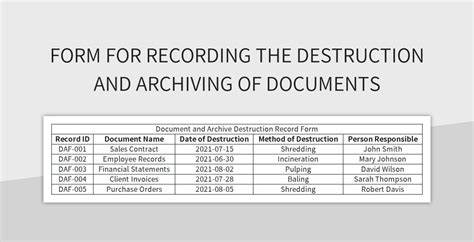

Кроме того, исследователи предложили метод сбалансирования набора данных, учитывающий как количество повторяющихся документов, так и их качество. Такой подход не только повышает разнообразие и репрезентативность данных, но и стимулирует рост производительности моделей, обученных на этих данных. Для создания собственного корпуса команда использовала почти 100 снимков Common Crawl — масштабного интернет-архива, который регулярно собирает веб-страницы по всему миру. Большая часть данных была специально отобрана и обработана с учётом многообразия языков, что позволило получить рекордный по объёму датасет, охватывающий более 1000 различных языков. Этот шаг знаменует собой новый этап в развитии многоязычных LLM, поскольку ранее существовавшие датасеты значительно уступали по размеру и многообразию языков.

FineWeb2 — это не просто набор данных. Это платформа для обучения высококачественных моделей, способных работать с разными языковыми сферами и контекстами. Благодаря открытому доступу к конвейеру обработки данных и оценочным инструментам, другие исследователи и разработчики могут адаптировать и расширять проект, создавая специализированные модели для своих целей. Это особенно важно для языков с низкой цифровой представленностью, которые ранее были практически исключены из трендов развития искусственного интеллекта. Теперь сообщества и разработчики могут самостоятельно создавать и улучшать возможности обработки и генерации текстов на родных языках, сохраняя культурное и лингвистическое разнообразие.

Ключевым аспектом успешности проекта стала его масштабируемость и универсальность. В отличие от прошлых инициатив, которые требовали ручной настройки или были ограничены несколькими крупными языками, FineWeb2 и сопровождающий его конвейер позволяют автоматически и эффективно обрабатывать данные для тысяч языков, используя единые и согласованные методы. Это также улучшает качество сравнения и оценки моделей, так как доступны стандартизированные наборы данных и процедуры тестирования для широкого круга языков. Помимо академического и технологического значения, FineWeb2 имеет большой социально-культурный потенциал. Он способствует снижению языкового барьера в цифровом мире, расширяя возможности доступа к информации и коммуникации для носителей различных языков.

Области применения многоязычных моделей широки: от автоматического перевода и создания образовательных материалов до цифровой архивации и помощи в изучении малоизвестных языков. Создание надежных и универсальных языковых моделей способствует укреплению глобального диалога и лучшему взаимопониманию между культурами. Несмотря на впечатляющие результаты, исследователи отмечают, что работа еще далека от завершения. Поиск оптимальных стратегий отбора, фильтрации и повышения качества данных остаётся ключевой задачей, равно как и расширение датасетов с учётом новых источников информации и языковых вариантов. Важно также вести постоянный мониторинг этических аспектов, таких как предотвращение распространения дезинформации и защита конфиденциальности пользователей.