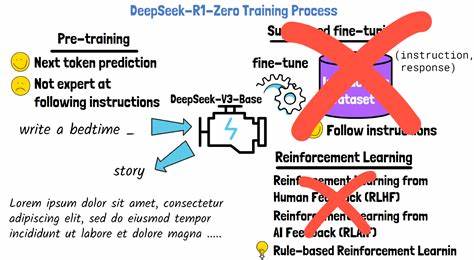

В современном мире искусственный интеллект становится все более важным инструментом для решения задач, требующих сложного анализа и рассуждения. Особое внимание исследователей и разработчиков привлекают модели с улучшенной способностью к продвинутому рассуждению, которые трансформируют подходы к обучению и применению ИИ. Одной из значимых разработок последнего времени стала методика POLARIS, представляющая собой рецепт для пост-тренировочного масштабирования обучения с подкреплением (Reinforcement Learning, RL) на таких моделях. POLARIS не просто демонстрирует высочайшие показатели точности, но и открывает новые горизонты в понимании, как правильно подходить к масштабированию и оптимизации RL в сфере сложных моделей. Основы POLARIS заложены в тщательном анализе и балансировке сложности тренировочных данных, что становится фундаментальным критерием для успешного обучения моделей с разной архитектурной сложностью.

Исследования команды POLARIS выявили, что многие существующие датасеты либо слишком просты, либо чрезмерно сложны для конкретных масштабов модели, что приводит к стагнации или даже снижению качества обучения. В связи с этим POLARIS советует использовать распределение трудностей, напоминающее зеркальное J-образное распределение, когда в тренировочном наборе сохраняется разумный баланс между простыми и сложными задачами. Такой подход стимулирует модель не только укреплять уже имеющиеся навыки, но и активно развивать новые способности к сложному рассуждению. В POLARIS невероятно важное значение придается и разнообразию примеров во время обучения. Использование разнообразных траекторий вывода, или rollouts, становится ключом к увеличению мощности модели.

Инициируя процесс с определенной температурой семплирования, адаптированной к базовой модели, и динамически повышая ее на протяжении обучения, методика обеспечивает широкие возможности исследовать пространство решений, не застревая на одном успешном шаблоне. Такая стратегия помогает моделям находить новые, ранее неизвестные подходы к решению задач, тем самым максимально используя потенциал RL. Еще одной революционной составляющей POLARIS является техника масштабирования длины вывода во время инференса. Проблема многозадачного и длинного обучения с подкреплением в том, что отработка долгих цепочек рассуждений связана с колоссальными вычислительными издержками. POLARIS вводит концепцию “train-short, generate-long” – сначала модель обучается на относительно коротких цепочках рассуждений, а затем во время инференса с помощью специальных методов экстраполяции длины, таких как модификация Rotary Position Embeddings (RoPE) с применением техники Yarn, достигает хорошей точности при генерации значительно более длинных решений.

Это новшество существенно снижает затраты на обучение и открывает возможности для масштабирования моделей на длинные последовательности. Преодоление проблемы снижения эффективности при обучении с длинными цепочками рассуждений становится возможным благодаря многоступенчатому обучению, которое предлагает POLARIS. В ходе данного подхода длина вывода постепенно увеличивается, что позволяет модели адаптироваться к возросшей сложности поставленных задач без резкого ухудшения качества. Однако при этом важно учитывать специфику конкретной модели. Например, для некоторых архитектур более эффективно сразу начинать с максимальной длины вывода, в то время как другие выгоды получают от плавного увеличения.

POLARIS предлагает гибкую настройку этого процесса, что способствует еще более эффективному обучению. Чтобы увеличить эффективность исследования и избежать так называемого «обнуления награды» при слишком сложных задачах, POLARIS внедряет инновационные механизмы поддержки и замены продвинутых выводов. К примеру, реализована процедура «Rollout Rescue Mechanism», которая сохраняет успешные решения из предыдущих эпох и подставляет их в текущие неудачные попытки. Такой механизм существенно снижает вероятность возникновения обучающих батчей без положительного сигнала и ускоряет общий процесс обучения. POLARIS также строится на учете уроков и стратегий, взятых из ведущих исследований, таких как DAPO и GRPO+, но при этом отказывается от некоторых элементов, способных вызывать нестабильность обучения, например, от энтропийных и KL-потерь.

Это не только делает тренировочный процесс более стабильным, но и позволяет моделям выходить за пределы изначальных ограничений, исследуя более широкое пространство стратегий решения задач. Результаты реализации POLARIS впечатляют: модели, построенные по этому рецепту, демонстрируют превосходство над современными коммерческими аналогами, такими как Claude-4-Opus и Grok-3-Beta, при значительно меньшем количестве параметров и возможности выполнять обучение и инференс на потребительских графических процессорах. Например, POLARIS-4B-Preview достигает уровня точности, сопоставимого с моделями размером свыше 200 миллиардов параметров, расходуя при этом менее 2% их ресурсов. Такая эффективность особенно важна для академического и исследовательского сообществ, где доступ к масштабным вычислительным мощностям ограничен. Благодаря открытию исходных кодов, датасетов и детализированных методик, команда POLARIS способствует развитию сообществ и стимулирует появление новых инноваций в области ИИ и обучения с подкреплением.

В заключение, POLARIS — это не просто очередная модель или методика, а тщательно собранный, проверенный и оптимизированный рецепт, позволяющий эффективно масштабировать обучение с подкреплением для продвинутых моделей рассуждения. Его глубокое понимание сложности данных, динамическая адаптация параметров синтеза, инновационные техники масштабирования длины вывода, а также надежные механизмы повышения исследовательской способности модели делают POLARIS одним из самых перспективных прорывов в области искусственного интеллекта. Методы, заложенные в этой разработке, открывают путь к созданию более умных, гибких и мощных моделей, способных решать задачи, ранее считавшиеся непосильными, и обещают существенные изменения в будущем ИИ-технологий.