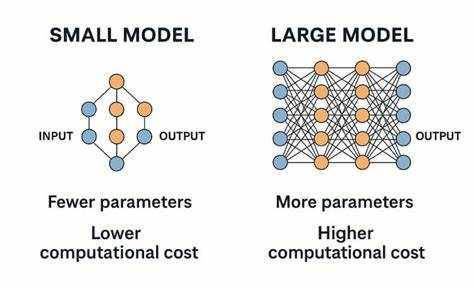

В мире искусственного интеллекта давно царит убеждение: чем больше модель, тем она умнее и эффективнее. Большие языковые модели с миллиардами параметров сегодня способны генерировать тексты, переводить, решать сложные задачи и поддерживать осмысленные беседы. Однако в последние годы появляется все больше внимания к так называемой концепции «когнитивного ядра» — идеи, что маленькие модели ИИ могут оказаться почти так же эффективны, как и их крупные аналоги. Стоит ли серьезно рассматривать малые модели как полноценный инструмент для интеллектуальных задач или они обречены оставаться вспомогательными и упрощенными версиями? Чтобы ответить на этот вопрос, необходимо глубже понять, как работают модели различного размера, в чем их сильные и слабые стороны и какие возможности открываются перед индустрией благодаря развитию маленьких моделей. Традиционная парадигма среди разработчиков искусственного интеллекта ориентирована на постоянное увеличение числа параметров.

Например, такие модели как Claude Opus 4 превосходят в ряде задач своих предшественников с меньшим количеством параметров, обеспечивая более точные ответы, изящные решения задач и лучшую управляемость в сложных сценариях. Согласно такому подходу, большие модели аккумулируют больше знаний и демонстрируют более высокий уровень когнитивных функций за счет значительного объема параметров. Тем не менее, последние годы выявили довольно удивительный феномен: маленькие модели ИИ, при правильной настройке и дистилляции, могут демонстрировать эффективность, приближающуюся к моделям в десятки раз больше по размеру. Дистилляция, процесс обучения более компактной модели на выходных данных крупной, позволяет маленькой «учиться» не только на результатах, но и на полной вероятностной распределённости предсказаний, что значительно обогащает качество знаний. В качестве примера наглядно можно посмотреть на достижение модели Gemma 3B – содержащей всего 3 миллиарда параметров, которая набирает более 65% на MMLU-бенчмарке, в то время как ранняя версия GPT-3 с 175 миллиардами параметров показывала порядка 44% в аналогичных тестах.

Это доказывает, что уменьшение в несколько десятков раз параметров не ведёт к пропорциональному ухудшению навыков модели. Однако, возникает важный вопрос: как это возможно? Ответ лежит в том, что модель помимо фактических данных, которые она хранит, должна обладать механиками рассуждения и умения обращаться с информацией. Большие модели запоминают много фактов благодаря огромному количеству параметров. Маленькие же могут концентрироваться на развитии когнитивных навыков, опираясь на возможность обращаться к внешним источникам информации, таким как интернет, базы данных и поисковые сервисы в режиме реального времени. Таким образом, малыми моделями можно создавать своего рода «когнитивное ядро», способное быстро направлять и интерпретировать запросы, докачивая данные по мере необходимости.

Это существенно снижает требования к вычислительным ресурсам и делает возможным запуск ИИ даже на мобильных устройствах. Несмотря на успехи маленьких ИИ, есть и причины, вызывающие скептицизм и осторожность. Одной из них является предположение, что для полноценного уровня рассуждений и обобщённого понимания необходимо иметь широкую и глубокую базу знаний, которую сложно уместить в маленькую модель. Исследования, проведенные Anthropic, показали, что у больших моделей более выражены абстрактные паттерны в нейронах, такие как универсальные концепты «животное» или «сущность», которые не воспроизводятся у менее крупных коллег. Если умение рассуждать опирается на такие широкие абстракции, то маленькая модель может оказаться ограничена в своих возможностях.

Еще один фактор — это соотношение усилий и результатов. Хотя маленькие модели гораздо быстрее запускаются и требуют меньше вычислительных мощностей, крупные модели предоставляют значительно лучшие результаты для большинства сложных и масштабных задач. Примером может служить ситуация с мобильным GPT-3.5: когда-то казалось, что запуск подобного ИИ на телефоне откроет эпоху персональной умной поддержки, но несмотря на то, что современные маленькие модели значительно продвинулись, они пока что в основном выполняют вспомогательные функции или используются как компоненты в более крупных системах, доступных через облачные сервисы. Тем не менее потенциал малых моделей ИИ сложно переоценить.

Возможность запускать интеллектуальные агенты локально, без необходимости обращения к удалённым серверам, это настоящий прорыв для конфиденциальности, скорости отклика и стоимости обслуживания. Представьте, что на вашем смартфоне постоянно работает модель, способная помогать в сборе и анализе информации, суммировать заметки и уведомления, консультировать вас по разнообразным темам без потребности подключаться к интернету или ожидать длительной обработки запросов. Такие изменения влияют не только на технологический уровень, но и на социальные аспекты – перераспределение влияния и возможностей от крупных корпораций к конечным пользователям. Будущее, где маленькие модели продолжают развиваться и совершенствоваться, выглядит вполне реальным. С одной стороны, это позволит сделать ИИ более доступным и универсальным инструментом.

С другой — поможет снизить экологический след вычислительных операций, поскольку небольшие модели потребляют заметно меньше энергии. Авторы и исследователи по всему миру регулярно подчеркивают важность сбалансированного развития: крупные модели останутся в своей нише сложных, масштабных проектов, а маленькие смогут интегрироваться в повседневную жизнь, расширяя круг задач, решаемых искусственным интеллектом. В конечном итоге, вопрос о том, могут ли маленькие модели мыслить так же эффективно, как большие, не имеет однозначного ответа. Все зависит от конкретной задачи, требований к скорости и глубине понимания, а также наличия внешних инструментов поддержки знаний. Однако тенденция к улучшению маленьких моделей и разработке гибридных систем, сочетающих компактное умозаключение и обширное взаимодействие с внешними данными, однозначно меняет ландшафт искусственного интеллекта.

Настало время переосмыслить догмы и внимательно смотреть на потенциал «когнитивного ядра» как нового шага в эволюции интеллектуальных систем.