В последние десятилетия машинное обучение достигло беспрецедентных успехов, во многом благодаря методам оптимизации, основанным на градиентном спуске. Несмотря на широкое практическое применение этих методов, глубокое математическое понимание принципов работы градиентных алгоритмов требует более точных и обоснованных теоретических подходов. Одним из таких подходов является рассмотрение обучаемых параметров через призму дифференциальной геометрии и концепции многообразий. Манифольды, или гладкие многообразия, можно рассматривать как обобщённое понятие привычных евклидовых пространств, но более гибкое и применимое к сложным нелинейным структурам. В контексте машинного обучения пространство параметров модели, зачастую многомерное и структурно богатое, можно формализовать как многообразие, детали локальной структуры которого во многом определяют поведение оптимизационных процедур.

В основе дифференциальной геометрии лежит идея, что в окрестности каждой точки пространства можно «приблизить» область поведения параметров линейным евклидовым пространством. Этот локальный взгляд позволяет изучать производные, градиенты и иные дифференцируемые объекты в более сложной топологии. Например, пространство параметров глубоких нейронных сетей, хоть и является достаточно сложным, при рассмотрении в малом масштабе ведет себя подобно обычному непрерывному пространству с заданным числом измерений. Ключевым объектом для анализа является касательное пространство в точке многообразия, которое представляет собой совокупность всех возможных направлений для бесконечно малых перемещений в этой точке. В машинном обучении касательное пространство можно интерпретировать как множество всех потенциальных направлений изменения модели при малых вариациях параметров.

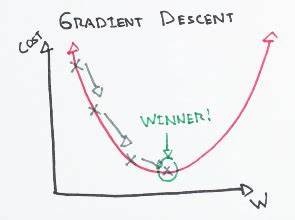

Важность такого взгляда заключается в том, что градиент функции потерь — это именно вектор в касательном пространстве, указывающий направление наискорейшего уменьшения ошибки. Однако для адекватного измерения величины и направления этих векторов на многообразии необходима метрика — обобщение привычного понятия скалярного произведения в евклидовом пространстве. Метрика вводит понятие длины и угла, что позволяет определять градиенты не только через производные функции, но и учитывать геометрическую структуру параметрического пространства. В зависимости от выбранной метрики меняется характер шага алгоритма градиентного спуска, что приводит к различным алгоритмам оптимизации. Поэтому дифференциальная геометрия предоставляет богатый инструментарий для создания более эффективных и адаптивных методов обучения.

В частности, метрики, основанные на информационно-геометрических свойствах, позволяют учитывать кривизну параметрического пространства и предлагать шаги в оптимизации, ориентированные на геометрическую структуру модели, что повышает скорость схождения и устойчивость. Еще один фундаментальный концепт — котангенциальное пространство, дуальное касательному пространству. Оно состоит из линейных функционалов, измеряющих векторы касательного пространства. Дифференциал функции потерь является элементом котангенциального пространства и описывает, как меняется функция в разных направлениях. Наличие метрики дает возможность преобразовать котангенциальные векторы (дифференциалы) обратно в касательные (градиенты), что и используется в вычислительных алгоритмах машинного обучения.

Совокупность касательных пространств, объединенных над всем многообразием параметров, формирует касательное расслоение — объект, который также играет ключевую роль в понимании динамики обучения. Интуитивно это пространство, в котором живут все возможные направления изменений модели во всех точках параметрического пространства. Анализ касательных расслоений и их метрик позволяет глубже понять поведение алгоритмов обучения как потоков на многообразиях. В последние годы активно развивается теория нейронного касательного ядра (Neural Tangent Kernel, NTK). В этой теоретической постановке изменение параметров модели рассматривается как движение по многообразию функций, к которому модель принадлежит.

Основываясь на дифференциально-геометрических представлениях, NTK описывает как малые изменения параметров влияют на выходные функции. Таким образом, связь между касательным пространством параметров и функциональным пространством становится очевидной и формальной. Различные метрики на параметрическом многообразии порождают различные оптимизационные алгоритмы. Например, классический градиентный спуск соответствует эвклидовой метрике, тогда как использование других норм, таких как спектральные нормы, ведет к появлению продвинутых алгоритмов оптимизации, способных быстрее адаптироваться к ландшафту функции потерь. Применение элементов дифференциальной геометрии в машинном обучении открывает путь к осмысленному улучшению алгоритмов.

Геометрическая интерпретация градиентного спуска не только облегчает понимание существующих методов, но и стимулирует разработку новых, которые учитывают сложную структуру параметрического пространства и функциональных зависимостей. Это позволяет сделать процесс обучения более эффективным, адаптивным и стабильным, что особенно важно для глубоких и сложных моделей. Немаловажно и практическое значение дифференциальной геометрии: она служит фундаментом для понимания инвариантности и устойчивости моделей при изменении параметров, а также углубляет представления о гладкости и кривизне функции потерь. Все это способствует более точной настройке моделей и повышает их обобщающую способность. Таким образом, дифференциальная геометрия предлагает мощный язык и набор инструментов, позволяющих раскрыть внутренние механизмы машинного обучения и наложиться на современные технологии оптимизации.

Построение оптимизационных методов, учитывающих геометрию модели, становится перспективным направлением исследований, способствующим дальнейшему развитию и совершенствованию искусственного интеллекта.