В современном мире искусственного интеллекта большие языковые модели (LLM) занимают центральное место в обеспечении взаимодействия между человеком и компьютерными системами. Они помогают автоматизировать самые разные задачи, от простых ответов на запросы пользователей до сложных бизнес-процессов. В частности, с ростом популярности агентных рабочих процессов, в которых LLM выступают в роли управляющих компонентов, остро стоит вопрос оптимизации выбора инструментов, которые вызываются для решения конкретных задач. Сложность и стоимость каждого вызова модели заставляют искать более экономичные и быстрые решения. В этом контексте исследование с использованием DSPy и PyTorch предоставляет важные инсайты, показывающие, что локальные контроллеры могут успешно и эффективно заменить традиционные промпт-базированные подходы к маршрутизации в agent workflow.

Основная концепция агентных рабочих процессов сводится к последовательности шагов, когда пользовательский запрос сначала анализируется языковой моделью, которая затем решает, какой из доступных инструментов (API, функции, дополнительные модели) следует вызвать для обработки запроса. После выполнения инструмента результат снова интерпретируется LLM для генерации ответа пользователю. Такой цепочный подход кажется удобным с точки зрения прототипирования и гибкости, однако он таит в себе значительные недостатки. Каждое обращение к модели связано с затратами на токены и временем отклика, и к тому же модели обычно не учатся на собственных предыдущих решениях, что приводит к повторному выполнению уже решённых задач и ненужному расходу вычислительных ресурсов. В ответ на эти вызовы была предложена идея замены первой стадии принятия решений о выборе инструмента с помощью легковесного локального контроллера — небольшой нейросети, обученной принимать бинарное решение.

Для проверки эффективности такого подхода был создан датасет из тысячи синтетически сгенерированных тикетов службы поддержки, смоделированных с использованием GPT-4o. Задачи, отражающие реальные проблемы клиентов, включали задержки в доставке, пропавшие товары и жалобы на качество обслуживания, что позволило построить репрезентативный набор для обучения и тестирования. Модель, основанная на простом рекуррентном нейронном модуле GRU с эмбеддингом и линейным слоем вывода, обучалась на 800 примерах, а оставшиеся 200 использовались для проверки результатов. Поразительно, несмотря на простоту архитектуры и отсутствие сложных техник предобучения, полученный локальный контроллер достиг почти совершенной точности в задаче классификации — решая, следует ли выдать возврат денег клиенту или нет. Этот результат говорит о том, что для ряда приложений достаточно легкой модели, способной быстро и дешево принять базовое решение, освобождая более сложные и дорогие модели для генерации ответов и анализа результатов.

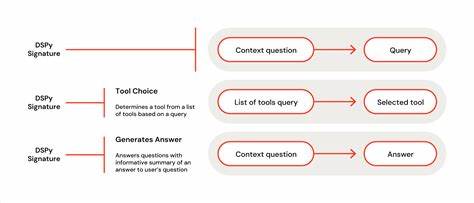

Далее в эксперименте были построены два агента при помощи DSPy — структурированного фреймворка для создания конвейеров из компонентов LLM. Первый агент управлялся полностью GPT-4o, принимающим решение о выборе пути и формирующим ответ, а второй имел гибридную схему, где контрольный модуль на базе обученного GRU принимал решение о маршрутизации, а генерация ответа оставалась за GPT-4o. Это позволило чётко отделить логику управления от логики генерации, что является важным шагом в построении более модульных, понятных и расширяемых систем. При тестировании с помощью встроенного блока Evaluate DSPy и анализе фактической стоимости вызовов модели, было обнаружено, что гибридный агент демонстрирует сопоставимую с полно GPT моделью точность при выборе действий, но при этом экономит до 40 процентов затрат путем сокращения количества API вызовов. Это достигается за счёт выполнения принятия решений локально, без необходимости каждый раз отправлять запрос в удалённую LLM.

Задержка при этом увеличивается незначительно и при оптимизации и использовании батчинга может быть ещё снижена. Результаты данного исследования подчёркивают важность смещения контроля изнутри LLM наружу, к программным контроллерам и нейросетевым модулям. Такой подход открывает перспективы создания более управляемых, предсказуемых и экономичных agent workflows. Он способствует повышению прозрачности систем, упрощает отладку и поддержку, а также позволяет лучше использовать вычислительные ресурсы, минимизируя избыточные вызовы моделей. Кроме того, переход к такой архитектуре содействует формированию более программно ориентированных агентов с чёткими интерфейсами и абстракциями, что облегчает масштабирование и интеграцию с другими бизнес-процессами.

Не менее важным направлением дальнейших разработок является изучение возможности обучения контроллеров не только определять, какой инструмент вызвать, но и каким образом это сделать. Например, если задача — выдать возврат, насколько велик должен быть его размер, кому следует передавать эскалацию — эти параметры требуют генерирования аргументов и дополнительных данных для вызова инструмента. Такой многоступенчатый подход ставит новые вызовы, связанные с обучением и поддержкой моделей, обеспечением согласованности и интеграцией с историей взаимодействий. В будущих работах будут исследованы методы синтетической истории, позволяющие передавать имитационные треки взаимодействий агентной системы, чтобы сохранить распределение данных внутри обучающей выборки, а также сравнительный анализ локальных контроллеров с мелкими дообученными языковыми моделями, способными работать непосредственно на локальном оборудовании. Оптимизация выбора инструментов в агентных рабочих процессах с помощью легковесных локальных контроллеров — это перспективный путь к увеличению эффективности и снижению затрат на интеграцию LLM в реальных приложениях.

Внедрение модульности, прозрачности и управления уровнем вызывает новые возможности для разработки комплексных систем искусственного интеллекта, которые будут быстрее, дешевле и надежнее, чем существующие решения, целиком полагающиеся на удалённые языковые модели. Таким образом, новая парадигма построения агентных систем, основанная на разделении контроля и генерации, а также использовании доступных нейросетевых моделей для принятия локальных решений, может изменить подход к проектированию ИИ-инструментов и улучшить качество обслуживания пользователей в масштабируемых и сложных бизнес-сценариях.