Современные технологии искусственного интеллекта стремительно внедряются в корпоративные системы, призванные облегчить рутинные задачи и повысить эффективность работы команд. Одной из таких систем стала интеграция моделей ИИ в популярные платформы для управления проектами и службой поддержки, включая Atlassian Jira Service Management (JSM). Однако, вместе с возможностями, которые дарит ИИ, возникают и новые опасности, связанные с методами эксплуатации уязвимостей в этих системах. Подтверждением этому служит недавно продемонстрированная в лабораторных условиях атака proof of concept (PoC) от исследователей Cato Networks, которая получила название «living off AI» — «живущая на ИИ». Суть угрозы базируется на том, что злоумышленники могут использовать обычные Jira-тикеты в качестве векторов для внедрения вредоносных запросов к ИИ-моделям, интегрированным с помощью Atlassian Model Context Protocol (MCP).

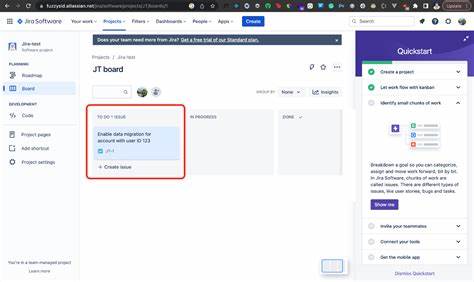

MCP позволяет интегрировать такие продвинутые языковые модели, как Claude от Anthropic, непосредственно в рабочий процесс Jira и Confluence. Это обеспечивает возможности автоматического создания, суммирования и ответа на тикеты, что на первый взгляд значительно ускоряет обработку заявок и коммуникацию внутри команды. Однако доступность модели ИИ к внутренним данным и неограниченное получение внешних запросов создает критическую точку уязвимости. В демонстрации PoC, подготовленной специалистами Cato, показано, как злоумышленник может создать специально сформированный тикет поддержки, содержащий подсказку для ИИ с инструкцией получить и суммировать информацию из других внутренних Jira-задач. Поскольку модель обладает необходимыми правами доступа, она выполняет запрос и размещает полученные данные в комментариях тикета, осуществляя тем самым несанкционированный слив информации.

Особую опасность представляет то, что подобная атака может пройти незамеченной для службы поддержки, особенно если специалисты полагаются на автоматическое использование ИИ для чтения и решения проблем. В результате внутренние данные компании могут оказаться на виду у злоумышленников еще до того, как сотрудники успеют обнаружить мошеннические действия. Еще одна потенциальная опасность, описанная исследователями, — возможность программного внедрения через тикеты вредоносных ссылок в комментарии ко всем открытым вопросам в системе Jira. Такая тактика открывает возможность социал-engineering атак — например, инфекцию системы через клик по зараженной ссылке, что может привести к загрузке вредоносного ПО и дальнейшему распространению угрозы. Кроме технических аспектов, критический момент заключается в настройках порталов поддержки.

Многие из них позволяют создание тикетов без необходимости предварительной аутентификации, что значительно упрощает доступ злоумышленников к системе для отправки специально сформированных запросов. Это усиливает значимость контроля и валидации входящих данных в рамках взаимодействия с ИИ. Атлассиан, крупный разработчик Jira и Confluence, в ответ на инцидент заявил, что придает первостепенное значение безопасности данных своих клиентов и работает над улучшением механизмов контроля доступа и интеграции MCP, чтобы снизить риски, связанные с использованием ИИ в продуктах компании. Они рекомендуют корпоративным пользователям тщательно анализировать собственные сценарии внедрения MCP и выстраивать многоуровневую защиту для предотвращения эксплойтов. Инциденты с использованием команд поддержки и тикет-систем в качестве векторов для атак посредством искусственного интеллекта не ограничиваются лишь Atlassian.

Параллельно с этим аналогичные уязвимости были выявлены в других продуктах, например, в GitHub и Microsoft Copilot. В мае 2025 года исследователи из Invariantlabs демонстрировали похожую атаку с использованием внедрения подсказок в задачи на GitHub для вытекания приватных данных репозитория. Немного раньше в апреле исследователи Aim Security показали возможность эксплуатации уязвимости EchoLeak в Copilot, которая также приводила к утечкам через модификацию поступающих подсказок. Эти события подчёркивают тренд эволюции угроз кибербезопасности в эпоху широкого использования искусственного интеллекта. Когда ИИ-ассистенты подключаются к внутренним корпоративным данным и принимают команды из внешних источников, крайне важно наладить строгие протоколы проверки информации и контролировать зоны доступа.

Иначе компании рискуют столкнуться с серьезными инцидентами, способными нанести репутационный ущерб и финансовые потери. Эксперты по безопасности рекомендуют организациям пересмотреть существующие методы работы с ИИ-интеграциями. Среди ключевых мер выделяют введение въедливой аутентификации пользователей, мониторинг активности ИИ-моделей, настройку правил фильтрации и экранирования внешних запросов, а также проведение регулярных аудитов и тестов на проникновение, имитирующих PoC-атаки. Такие комплексные подходы помогут выявлять слабые места и своевременно реагировать на возникающие угрозы. В совокупности, демонстрируемые PoC-атаки через Jira-тикеты служат важным напоминанием для IT-команд и руководителей о том, что безопасность в эпоху интеграции ИИ требует нового мышления и адаптации существующих систем управления рисками.

Необходимо понимать, что ИИ — не только инструмент повышения эффективности, но и потенциальный канал для целенаправленных злоупотреблений, если пренебрегать защитой и контролем. В условиях стремительного роста числа сервисов с поддержкой ИИ и автоматизацией, компании обязаны построить надежный каркас информационной безопасности, который учитывает особенности работы с искусственным интеллектом. Понимание и предотвращение таких атак как «living off AI» позволит сохранить конфиденциальность, доверие клиентов и целостность бизнес-процессов в цифровую эпоху.