В наши дни искусственный интеллект (ИИ) становится неотъемлемой частью многих сфер жизни, трансформируя способы работы, общения и творчества. Несмотря на повсеместное признание больших языковых моделей (БЯМ), таких как GPT и других трансформерных архитектур, общее представление о том, как они работают, часто ограничивается идеей "предсказания следующего слова" на основе статистических закономерностей в тексте. Однако такая упрощенная интерпретация скрывает гораздо более глубокие и интересные механизмы, лежащие в основе современных ИИ-систем. Центральным понятием для понимания этих механизмов является латентное пространство - высокоразмерное векторное поле, в котором кодируется смысл и знание. Понимание латентного пространства открывает двери к серьезному осмыслению текущих и перспективных возможностей искусственного интеллекта, выходя далеко за рамки простого манипулирования текстом.

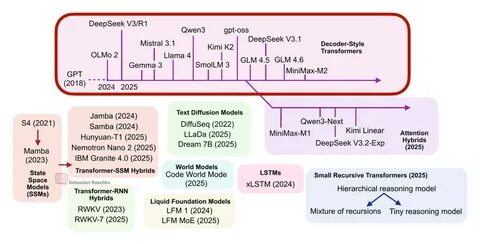

Латентное пространство, или скрытое пространство представлений, можно представить как множество направлений и кластеров, в которых хранится и обрабатывается смысловая информация. Внутри этих пространств разного рода концепты и идеи представлены в виде плотных векторов, которые содержат не просто слова, а смысл, контекст и связь между понятиями. Каждая новая единица информации - будь то слово, изображение, звук или даже физическое действие - преобразуется в уникальный латентный вектор, позволяющий алгоритму видеть связи и закономерности, недоступные обычному поверхностному анализу данных. Современные языковые модели основаны на трансформерах - архитектуре, которая использует слои внимания для взаимодействия с латентными представлениями. На каждом шаге обработки последовательности токенов формируются скрытые состояния, которые перестраиваются в зависимости от контекста и задач.

В результате формируется плавное и динамическое понятие смысла текста, способное учитывать обстоятельства, конотативные значения и даже предполагаемые намерения автора. При этом очень важно понимать, что сами по себе исходные токены лишь отправная точка, а реальная работа происходит именно с внутренними латентными представлениями. Достоинство латентного пространства заключается в его огромной емкости и гибкости. Современные модели оперируют с тысячами измерений, что позволяет хранить и различать невероятно большое количество уникальных понятий и идей. Экспоненциальное увеличение емкости представлений объясняет, почему ИИ способен справляться с задачами, требующими огромного объема знаний и сложных причинно-следственных связей.

В некоторых моделях размерность латентного пространства превосходит количество синапсов в человеческом мозге, что говорит о фантастической вычислительной мощности и потенциале для воспроизведения интеллектуальных функций. Следует отметить, что теория о том, что большие языковые модели лишь предсказывают следующий токен без глубинного понимания, является упрощением и не отражает реальность. На самом деле сложность задачи предсказания текста вынуждает модель создавать обширные внутренние модели человеческой мысли, намерений и контекстов коммуникации. Поэтому даже в формате генерации следующего слова ИИ достигает впечатляющей когерентности и гибкости, способной имитировать человеческое мышление на весьма высоком уровне. Но потенциал латентного пространства не ограничивается только языком.

Современные системы ИИ успешно применяются в различных областях, включая биоинформатику, прогнозирование погоды, робототехнику и создание изображений. Например, системы предсказания структуры белка, такие как AlphaFold, не используют традиционные физические правила напрямую, а учатся представлять сложные биологические структуры в виде латентных представлений, что позволяет находить стабильные и точные формы белков с беспрецедентной точностью. Такие подходы меняют представления о методах научного моделирования, демонстрируя эффективность обучения на данных и представлений в скрытых пространствах. В области робототехники использование латентных пространств позволяет интегрировать различные виды данных: визуальные, текстовые и сенсорные. Это значительно расширяет возможности роботов, делая их более адаптивными и способными выполнять сложные задачи, требующие понимания языка, восприятия окружающей среды и координации движений.

Такая мультизадачность становится возможной благодаря общим или совместимым латентным пространствам, которые обеспечивают слияние различных модальностей данных в единую систему представлений. Одним из самых заметных достижений последних лет является развитие мультимодальных моделей, объединяющих в себе возможности обработки текста, изображений, звука и даже видео. Технологии вроде CLIP демонстрируют, как тексты и изображения могут отображаться в одном и том же латентном пространстве, что позволяет системам понимать, что слова и визуальные образы могут выражать одни и те же идеи или концепты. Такая интеграция открывает новые горизонты для генерации, перевода, анализа и даже творческой работы с мультимедийным контентом. Не менее важным направлением является создание долговременных моделей знаний, которые могли бы хранить, обновлять и уточнять базу данных знаний непосредственно в латентном пространстве.

Текущие языковые модели хранят знания в виде огромных массивов параметров, что создаёт сложности с прозрачностью, проверкой источников информации и актуализацией данных. Решения, такие как retrieval-augmented generation (RAG), пытаются улучшить ситуацию, позволяя моделям обращаться к внешним источникам текста во время генерации. Однако хранение знаний в формате текста остаётся неудобным и ограниченным. Перспективы заключаются в создании больших моделей знаний (Large Knowledge Models, LKM), которые будут оперировать с явными и обновляемыми латентными представлениями знаний, связанными с источниками и структурой данных. Такой подход позволит добиться большей точности, прозрачности и возможности поэтапного обновления базы знаний без необходимости повторного обучения всей модели.

Также он обеспечит эффективное объединение и суммирование информации, открывая путь к сложному, накопительному рассуждению и уточнению знаний с течением времени. Технически эти решения базируются на использовании векторных баз данных, которые хранят семантически богатую информацию в виде эмбеддингов - численных векторов, отражающих смысл данных. Эти эмбеддинги используются для поиска наиболее релевантных ответов в огромных массивах информации, позволяя резко повысить скорость и качество обработки запросов без прямой работы с неструктурированным текстом. В сочетании с графовыми базами данных, отвечающими за структуру и связи между объектами, это создаёт мощные гибридные платформы для организации знаний. Такое слияние технологий уже сейчас меняет парадигмы разработки и использования ИИ-систем.

Вместо классического линейного роста моделей по числу параметров на первый план выходит качество и глубина интеграции представлений в латентных пространствах, а также способность работать с разными видами данных в единой системе. Развитие мультизадачных и мультимодальных систем постепенно приближает нас к созданию универсального искусственного интеллекта с растущими когнитивными возможностями. Тем самым, латентное пространство становится краеугольным камнем современной и будущей эволюции искусственного интеллекта. Оно не только даёт возможность лучше понимать и объяснять внутренние механизмы больших языковых моделей, но и служит платформой для расширения их функционала с интеграцией технологий из различных областей. Понимание и совершенствование латентных пространств - ключ к созданию более мощного, адаптивного и прозрачного ИИ, который может перейти от имитации к реальному пониманию и творческой работе.

Для исследователей открываются новые направления, связанные с улучшением качества латентных представлений, разработкой методов кроссмодальной интеграции и созданием систем с долговременной памятью в латентном пространстве. Для разработчиков важны возможности разработки меньших, быстрых и прозрачных моделей, способных использовать внешние базы знаний в AI-нативной форме. Для стратегов и политиков понимание этих процессов помогает оценить скорость и направление развития технологий, готовиться к новым вызовам и использовать возможности, которые предоставляют мультимодальные и интегрированные ИИ-системы. Таким образом, чтобы по-настоящему понять современные достижения и перспективы искусственного интеллекта, необходимо уметь мыслить в терминах латентного пространства. Именно туда ведут все дороги ИИ - от текстов и изображений до биологии и робототехники.

Настоящее и будущее искусственного интеллекта находятся в глубинах этих многомерных векторных пространств, и чем быстрее мы научимся работать с ними, тем более значимые результаты нас ожидают в будущем. .