В современном мире веб-разработки и построения масштабируемых систем производительность и скорость обработки данных играют решающую роль. Одной из наиболее популярных технологий для кеширования и ускорения доступа к данным является Redis, благодаря своей скорости и простоте использования. Однако, даже такая эффективная система может стать узким местом, если архитектура приложения не учитывает особенности взаимодействия с Redis. Статья расскажет, как можно существенно повысить производительность и снизить задержки путем комбинирования Redis с локальными словарями внутри процессов, а также о проблемах и решениях, возникающих при разработке динамических веб-фреймворков, на примере Frappe Framework. Frappe Framework представляет собой гибкий веб-фреймворк, который позволяет динамически изменять схемы и конфигурации в процессе работы, без необходимости перезапуска или долгой переустановки.

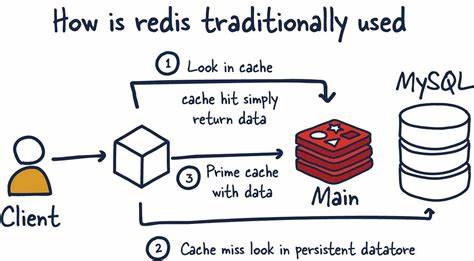

Такие системы требуют частого выполнения тяжелых вычислений во время выполнения запросов, что требует эффективных стратегий кеширования. В изначальной реализации данные обрабатывались и сохранялись в Redis для быстрого доступа и возможности централизованного обновления, позволяя запущенным процессам видеть последние изменения конфигураций и схем. Несмотря на свою эффективность, такой подход показал существенные недостатки, что было выявлено с помощью продвинутого профилирования и анализа производительности. Интерактивный flamegraph, созданный для простого API-запроса документа, показал, что до половины времени обработки запроса уходило не на извлечение данных из базы, а на работу с кешированием и запросы к Redis. Это стало неожиданностью, учитывая, что Redis работает локально на той же машине, что и веб-процессы, что сводит к минимуму сетевые задержки.

Анализ выявил несколько ключевых причин таких торможений. Во-первых, каждый вызов Redis требует межпроцессного взаимодействия, переправляя ключи и получая данные через TCP, даже если это происходит на локальной машине. Во-вторых, данные сериализуются и десериализуются — преобразуются в байтовые потоки и обратно в объекты Python, что несет дополнительные затратные вычисления. В-третьих, каждое обращение к Redis не дает возможности процессору эффективно кешировать данные в локальном кэше, так как объекты в памяти постоянно создаются заново. Эта ситуация подтолкнула разработчиков к мысли об использовании простого локального словаря в каждом процессе как альтернативы постоянным обращениям к Redis.

Такой подход позволил бы хранить необходимые данные в оперативной памяти процесса и устранил бы большую часть транзакционных издержек, связанных с межпроцессным взаимодействием и сериализацией. Однако при масштабировании с несколькими веб-процессами поднимается проблема согласованности: каждый процесс будет иметь собственный кеш, и при изменении данных в одном из них нужно получить актуализацию всех остальных. Для решения этой задачи была реализована система управления инвалидацией кеша. Когда в одном процессе меняется схема или метаданные, локальный кеш этого процесса очищается, и параллельно отправляется сообщение другим процессам с запросом удалить устаревшие данные. Это требует эффективного механизма коммуникации между процессами, чтобы гарантировать корректность данных без значительной потери производительности.

Поиск подходящего компромисса между временем ответа и целостностью данных стал главной инженерной задачей. Ситуация усложнялась тем, что полное отключение Redis ради локальных кешей было невозможным — все процессы нуждались в едином источнике правды. В итоге была использована одна из уникальных особенностей Redis — клиентское кеширование с поддержкой протокола RESP3, который позволяет получать push-уведомления об инвалидированных ключах. Это значит, что клиенты Redis могут локально кешировать данные, а Redis будет информировать их об изменениях, заставляя их обновить или удалить устаревшую информацию. Внедрение клиентского кеширования с серверным ассистентом позволило значительно уменьшить количество обращений к Redis и улучшить производительность.

Теперь каждый процесс хранит наиболее востребованные данные в локальном словаре, получая уведомления о необходимости инвалидации при изменении где-либо другого процесса. Это устранило множество накладных расходов на IPC и сериализацию, сохранив при этом целостность данных. Инженеры также внедрили ограничения на объём локального кеша, чтобы избежать чрезмерного потребления памяти, используя стратегию FIFO, которая проста и эффективна, поскольку применяет минимальные накладные расходы при чтении данных. Не все обращения к Redis отслеживаются для кеширования — только наиболее частые и критические для производительности, что позволяет избежать бесполезного роста кеша и излишних расходов ресурсов. Обязательным элементом стала система аварийного выключения клиентского кеширования при возникновении критических ошибок, чтобы избежать использования устаревших данных и сохранить корректность работы приложений.

Такой подход обеспечил резервный план, позволяющий поддерживать стабильность системы даже в нестандартных ситуациях. Реальные результаты внедрения новых механизмов не заставили себя ждать. Микробенчмарки показали колоссальное уменьшение времени отклика: операции, которые ранее занимали порядка 11 миллисекунд, сократились до менее чем 100 микросекунд, что соответствует ускорению в сотни раз. В реальных пользовательских нагрузках ERP-системы скорость обработки выросла примерно на 50 процентов без необходимости масштабного рефакторинга бизнеса-логики. Этот опыт демонстрирует важность глубокого анализа узких мест в системах и творческого переосмысления архитектурных подходов, особенно в таких гибких фреймворках как Frappe, где динамичность и постоянные изменения — норма.

Оптимизация кеширования и правильное распределение данных между процессами дают возможность продолжать расширять функциональность без ущерба скорости и отзывчивости. В конечном итоге, комбинация традиционного Redis с локальными словарями и продвинутыми механизмами клиентского кеширования становится мощным инструментом для построения масштабируемых, высокопроизводительных приложений, которые могут эффективно работать в условиях постоянных изменений и высокой нагрузки. Для инженеров, стремящихся оптимизировать свои проекты, такой подход открывает новые перспективы по снижению задержек и повышению стабильности без значительных затрат на инфраструктуру. Подобные технологии уже включены в обновления Frappe v16, обещая больше чем двукратный прирост скорости работы фреймворка в различных сценариях применения. Кто ищет наиболее эффективные методы работы с Redis в условиях динамического кеширования и масштабирования, может почерпнуть ценный опыт и вдохновение, следя за развитием этих подходов и внедряя их в собственные решения.

Таким образом, ключ к преодолению кажущихся ограничений Redis лежит в комбинировании проверенных технологий кеширования на стороне сервера с умной организацией локальных данных, что открывает широкие возможности для достижения выдающихся результатов в скорости и стабильности современных веб-систем.