В современную эпоху цифровых технологий платформы социальных сетей становятся не только источником развлечений, но и полем для сложных форм информационного вмешательства. TikTok, одна из самых популярных видеоплатформ в мире с более чем миллиардом пользователей, не исключение. Новейшие исследования и практические случаи выявили новую форму обмана на TikTok — видеоролики с глубокими подделками, в которых используются настоящие слова реальных создателей контента, но представлены они через искусственно сгенерированные голоса и образы. Этот феномен вызывает серьёзные вопросы о приватности, достоверности информации и новых практиках цифрового мошенничества.Суть проблемы заключается в том, что некоторые видеоролики, распространяемые на платформе, демонстрируют сообщения, которые выглядят и звучат как высказывания реальных пользователей TikTok, но на самом деле созданы с помощью технологий искусственного интеллекта.

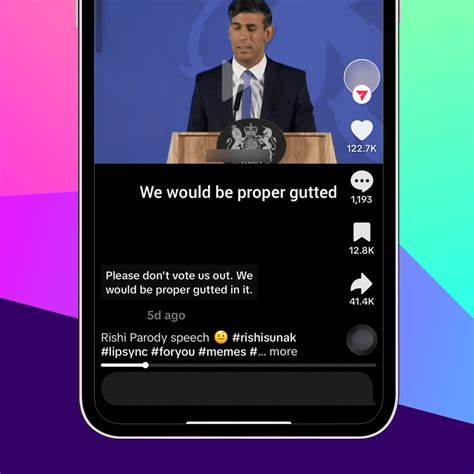

Таким образом, создаются глубокие подделки, в которых голос, внешний вид и поведение говорящего — результат работы сложных алгоритмов генеративного AI. Эти видеоролики могут запутать пользователей и распространить дезинформацию, несмотря на то, что слова в них были взяты из реального контента.Одна из тревожных историй касается распространяемого за несколько дней видео, в котором говорилось о якобы установке мусоросжигательных печей в центре иммиграционного содержания в штате Флорида, известном как «Alligator Alcatraz». Несмотря на полное отсутствие доказательств, это конспирологическое утверждение быстро распространилось в сети и привлекло миллионы просмотров. Два видео, одно из которых — оригинал с реальным создателем, а другое — подделка с генеративным AI, имели идентичный текст, но отличались голосом и внешностью персонажа.

Последующая экспертиза цифровых специалистов подтвердила использование искусственного интеллекта для создания реалистичной копии видеоконтента.Важно отметить, что подобные случаи в социальной сети TikTok не единичны. Существуют аккаунты, которые систематически используют слова реальных авторов, создавая при этом персонажей с искусственно сгенерированным голосом и лицом, чтобы привлечь внимание и просмотры. Для создателей контента это не только проблема нарушения авторских прав, но и нарушение приватности, поскольку их личные слова используют без разрешения в иных формах, зачастую с целью монетизации или привлечения подписчиков на фальшивые аккаунты.Защита от копирования и подделки контента в социальных сетях давно является актуальной задачей.

Однако технологии искусственного интеллекта вносят свои коррективы, делая традиционные методы контроля менее эффективными. В отличие от обычного воровства видео, где копируется или републикуется оригинал, AI способен брать только звуковую дорожку, преобразовывать голос и генерировать новое, полностью синтетическое изображение говорящего, сохраняя при этом содержание речи.Наряду с техническими сложностями, данная проблема поднимает этические и юридические вопросы. Создатели контента столкнулись с трудностями при попытках пожаловаться на нарушения через официальные каналы TikTok. Сообщается, что жалобы часто остаются без должного рассмотрения, что усиливает ощущение беззащитности и несправедливости.

Отсутствие ясных и действенных правил, касающихся использования искусственного интеллекта для создания глубоко подделанных видео, создает благоприятную почву для распространения недостоверной информации и мошенничества.Эксперты в области цифровой криминалистики отмечают, что подобные случаи уже не просто развлечение или интернет-фольклор, а реальная угроза безопасности и общественной информированности. В то время как ранее глубоко подделанные ролики использовались преимущественно в политических целях для дискредитации публичных фигур и распространения пропаганды, теперь мы наблюдаем и повседневные примеры, где среднестатистических авторов подвергают цифровому «воровству» их слов и образов.Еще одной опасностью является потенциальное использование таких технологий злоумышленниками для создания фейковых аккаунтов с целью манипуляции общественным мнением или распространения мошеннических схем. Отслеживание, выявление и борьба с такими цифровыми угрозами требуют совместных усилий технических специалистов, платформ социальных сетей и политиков.

Однако говорят о том, что, несмотря на растущую доступность инструментов глубоких подделок, нехватка грамотной модерации и законодательных мер пока затрудняет эффективную борьбу с явлением.Как можно защитить себя и сообщество? Во-первых, пользователям рекомендуется сохранять критический взгляд при просмотре информации в социальных сетях. Важно проверять источники, сравнивать сведения с новыми сообщениями и не доверять информации на основании вирусной популярности. Создатели контента должны внимательно следить за своими материалами и при обнаружении копий обращаться к администраторам платформ, а также документировать факты нарушения. В будущем не исключено появление специализированных инструментов для проверки аутентичности видео, основанных на распознавании признаков глубоких подделок и выявлении несоответствий технических параметров.

В целом современный феномен использования реальной речи создателей на искусственно сгенерированных аватарах — это новое направление в развитии цифрового мошенничества и вызов для индустрии социальных медиа. Он призывает к более серьёзному подходу к регулированию AI-технологий, а также повышению цифровой грамотности пользователей, чтобы обезопасить себя от фальсификаций и сохранить доверие к информации online. TikTok, как одна из крупнейших платформ, стоит на передовой этой борьбы и должен стремиться к быстрому внедрению решений, которые помогут остановить распространение такого рода обмана и защитить права создателей контента и пользователей в целом.