Живые демонстрации технологий искусственного интеллекта всегда вызывают большой интерес у широкой аудитории, инвесторов и экспертов. Они представляют собой возможность показать достижения в области ИИ в реальном времени, подтвердить заявленные возможности и завоевать доверие публики. Однако именно живые презентации нередко становятся источником проблем и вызывают скептицизм, когда система дает сбой или не выполняет заложенных функций. Неудачные демонстрации искусственного интеллекта приобретают большую резонансность, поскольку технологии часто воспринимается как нечто почти волшебное, а провалы в живом эфире подрывают репутацию проектов и компаний. В современном мире, где информация распространяется мгновенно, даже незначительные ошибки могут дорого обойтись с точки зрения доверия, финансирования и развития технологий.

Одной из ключевых причин неудач на живых демонстрациях ИИ является недостаточная подготовка и тестирование в условиях, максимально приближенных к реальным. Многие разработчики проводят испытания в контролируемой среде, где поведение машины предсказуемо. Однако при переходе на живой показ возникает множество непредвиденных факторов - изменчивость ввода, различия в окружении, сетевые задержки, ограничение ресурсов или даже человеческий фактор. Все эти элементы могут существенно влиять на стабильность работы системы. Еще одна важная причина - завышенные ожидания.

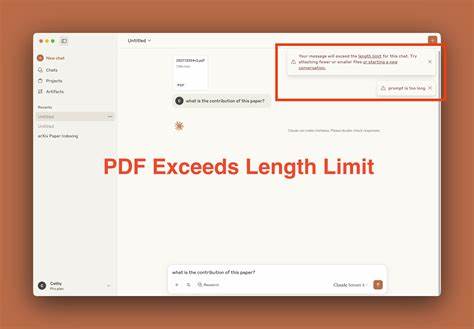

Компаниям порой свойственно демонстрировать технологии, которые пока находятся на ранних стадиях разработки или являются прототипами. Под давлением маркетинга и стремления привлечь инвесторов или клиентов, руководство может принимать решение о проведении презентации раньше, чем продукт стабильно функционирует. В результате даже малейший сбой воспринимается как полный провал, а общественное мнение формируется на основе неполных или ложных представлений о возможностях ИИ. Техническая сложность систем искусственного интеллекта также играет существенную роль. Часто ИИ-алгоритмы требуют значительных ресурсов и оптимизации для работы в реальном времени.

Невозможность правильно масштабировать модель или недостаточное обучение на разнообразных данных приводит к ошибкам при неожиданных вводах. Проблемы могут возникать на стадии интеграции с другими программными компонентами, аппаратным обеспечением или облачными сервисами, что также усугубляет риски поломок во время демонстрации. Публика и специалисты, наблюдающие за такими неудачами, порой начинают критиковать не только конкретный проект, но и всю отрасль искусственного интеллекта. Это может приводить к снижению доверия инвесторов и пользователей, откладыванию финансирования и замедлению внедрения инноваций. В то же время, неудачи в живых показах - это важный источник уроков и опыта, позволяющий выявить слабые места в системах, улучшить методики разработки и коммуникации с аудиторией.

Одним из последних примеров можно назвать публичные демонстрации чат-ботов на базе ИИ, в ходе которых системы демонстрировали неожиданные и некорректные ответы, иногда противоречащие этическим нормам или демонстрирующие явные ошибки понимания контекста. Такие случаи подчеркнули необходимость усиленной фильтрации контента, обучения нейросетей на более репрезентативных и разнообразных данных, а также важность функционала контроля качества. Стоит отметить, что успешные демонстрации ИИ сегодня - результат комплексной работы, включающей подготовку сценариев, автоматизированное тестирование, отказоустойчивость систем и подробное обучение команды, ведущей презентацию. Это требует согласованности между разработчиками, инженерами, маркетологами и менеджерами проектов. Опыт показал, что попытки импровизации и недостаточная координация негативно влияют на имидж технологии и компании.

Кроме того, в сфере искусственного интеллекта важно принимать во внимание этические и социальные аспекты, которые могут всплыть во время демонстраций. Публичные сбои иногда сопровождаются вопросами о контроле над поведением ИИ, защитой персональных данных и прозрачности алгоритмов. Компании, проводящие живые демонстрации, должны четко понимать и заранее готовиться к таким вопросам, чтобы укреплять доверие и минимизировать негативное восприятие. Также стоит подчеркнуть растущую роль обратной связи от пользователей и аудитории, которая принимает активное участие в оценке функций ИИ. Негативные комментарии и критика зачастую помогают выявить скрытые дефекты и улучшить продукт.

Однако именно заранее установленные рамки и прозрачность в коммуникации позволяют избежать чрезмерных ожиданий и способствуют более адекватной реакции общества на результаты демонстраций. В итоге неудачные живые демонстрации искусственного интеллекта стали важной частью эволюции индустрии. Они служат своеобразным тестом на прочность технологий и отзывчивость команд, работающих над ними. Эти опыты стимулируют совершенствование процессов разработки, укрепление стандартов качества и этических норм, а также формирование более ответственного отношения к презентациям инноваций перед широкой публикой. Важно, чтобы компании и разработчики учились на своих ошибках и воспринимали неудачи не как полный провал, а как возможность роста и развития.

Правильное понимание технических ограничений, прозрачность, тщательная подготовка к презентациям и внимание к этическим аспектам помогут сделать живые демонстрации ИИ более успешными и эффективно продвигать технологии в будущее. Таким образом, провалы сегодня - это фундамент для достижений завтра и шаг к созданию действительно надежных и полезных систем искусственного интеллекта, способных изменить мир. .