В эпоху стремительного развития искусственного интеллекта (ИИ) всё более важным становится вопрос этического использования новых технологий. Каждый день искусственный интеллект всё глубже внедряется в различные сферы жизни — от медицины до финансов, от образования до транспортных систем. В таких условиях формирование моральных принципов и правил поведения для ИИ становится приоритетной задачей. Одним из современных решений этой задачи становятся приложения с ежедневными моральными вопросами для ИИ, которые помогают моделировать этическое мышление и принимать справедливые решения. Идея использования моральных вопросов для обучения и оценки искусственного интеллекта появилась в стремлении воспроизвести человеческие нравственные дилеммы и выявить, как системы ИИ способны реагировать в тех или иных этических ситуациях.

Такие приложения интегрируют в свою работу разнообразные философские концепции, основываясь на теории справедливости, утилитаризме, деонтологии и других подходах. Постоянное выполнение ИИ задач с моральными вопросами стимулирует развитие навыков критического мышления и позволяет определить, насколько система способна адаптироваться к сложным, неоднозначным ситуациям. Моральные вопросы для искусственного интеллекта часто касаются ситуаций из реальной жизни с этическими вызовами. Например, ситуация, когда надо выбрать между благом меньшинства и большинства, или вопросы конфиденциальности данных, которые в XXI веке приобретают исключительную важность. Такие вопросы заставляют ИИ анализировать не только прямые выгоды и потери, но и паттерны поведения, социальные нормы, культурные особенности и потенциальные долгосрочные последствия.

Важным аспектом применения таких приложений является их влияние на развитие самих систем ИИ. Они работают по принципу постоянного обучения и адаптации. Из обработки ежедневных моральных вопросов тренируется не только способность выбирать оптимальное решение, но и формируется база данных этических сценариев, что расширяет кругозор программы и повышает качество принятия решений в будущем. В итоге, ИИ становится таким, который способен учитывать более сложные и тонкие нюансы человеческого морального опыта. Помимо того, что ежедневные моральные вопросы позволяют улучшить внутреннюю логику искусственного интеллекта, они способствуют и развитию доверия между людьми и машинами.

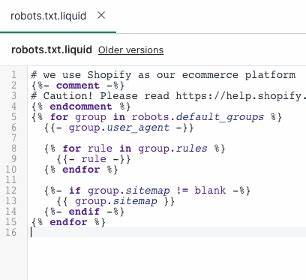

Когда пользователи замечают, что ИИ не только функционален, но и учитывает этические аспекты, отношение к технологии меняется в сторону положительного взаимодействия. Это особенно важно в сферах, где решения ИИ могут сильно повлиять на жизнь и благополучие людей — например, в медицине при диагностике и назначении лечения или в судебной системе при вынесении заключений. Технологии, лежащие в основе приложений с моральными вопросами, развиваются благодаря применению методов машинного обучения и обработки естественного языка. С помощью нейронных сетей и алгоритмов глубокого обучения системы анализируют поступающие данные, выявляют паттерны этического поведения и учатся интерпретировать сложные концепции. Нейросети позволяют обрабатывать многообразие источников информации, от классических философских текстов до реальных кейсов, что делает обучение ИИ более комплексным и адаптивным.

Значительное внимание уделяется и тому, чтобы предотвращать потенциальные предвзятости в данных, на которых тренируется искусственный интеллект. Этические вопросы дают возможность выявить и скорректировать наклонности системы в сторону дискриминации или несправедливого отношения к определённым группам. Такой подход способствует созданию более честных и прозрачных алгоритмов, что становится залогом успешного и безопасного интегрирования ИИ в общество. На практике подобные приложения используются не только для обучения ИИ, но и для повышения общих знаний пользователей о моральных дилеммах современности. Вовлекая людей в процесс обсуждения вопросов, касающихся этики и ответственности, они создают платформу для совместного развития и формирования общественного мнения по важным темам, связанным с искусственным интеллектом.

Это важно, поскольку проблема этики в области ИИ стоит не только на техническом, но и на социальном уровне. Каждый человек сталкивается с результатами работы автоматизированных систем, и возможность взаимодействовать с ИИ, обладающим моральным кодексом, повышает чувство безопасности и ответственности создателей технологий. Одним из сложных вызовов является баланс между формализацией моральных принципов и гибкостью принятия решений ИИ. Моральные категории и нормы часто зависят от культурных и личностных особенностей, и универсальный набор правил может оказаться недостаточным. Поэтому ежедневные моральные вопросы стимулируют ИИ к обучению на многообразных примерах и выработке адаптивной этики, способной учитывать контекст и изменяющиеся обстоятельства.

Перспективы развития таких приложений очень масштабны. Они могут стать основой для создания более продвинутых систем поддержки принятия решений, которые будут помогать людям ориентироваться в сложных моральных ситуациях. Кроме того, постоянное совершенствование этических алгоритмов позволит интегрировать ИИ в новые сферы, где ранее использование таких технологий казалось рискованным из-за отсутствия надёжных моральных ограничений. Также стоит отметить роль международного сотрудничества в этой области. Этические стандарты и нормы в разных странах могут существенно отличаться, и лишь синтез этих подходов позволит создать действительно универсальные инструменты для обучения ИИ с моральным компонентом.

Совместные исследования и обмен опытом ускоряют процесс становления этичной искусственной интеллектуальной среды. В заключение можно подчеркнуть, что приложения с ежедневными моральными вопросами для искусственного интеллекта открывают новые горизонты в развитии этики технологий. Они не просто помогают ИИ учиться выбирать правильные действия, но и вносят вклад в понимание человеком и машиной сложных вопросов ответственности, справедливости и человеческих ценностей. В условиях быстрого технического прогресса эти инструменты становятся неотъемлемой частью создания безопасного, гуманного и справедливого цифрового будущего.