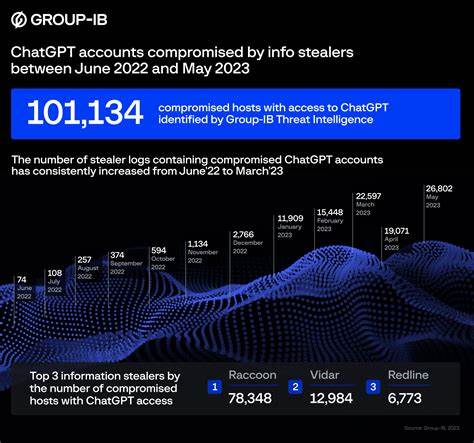

В последние годы искусственный интеллект стремительно вошел в повседневную жизнь, трансформируя коммуникации, работу и образование. Одной из ключевых технологий, которая получила огромное распространение, стал ChatGPT - языковая модель, способная вести осмысленные беседы, создавать тексты, помогать в программировании и выполнять множество других задач. Однако, с увеличением популярности и объемов обрабатываемых данных всегда возрастает риск их компрометации. Недавние подозрения относительно возможной утечки или нарушения безопасности данных ChatGPT вызвали широкий резонанс в сообществе специалистов и пользователей ИИ. Попробуем разобраться, что собой представляет данная ситуация, каковы ее потенциальные последствия и какие меры профилактики можно принять для защиты информации и приватности.

Обнаружение возможной компрометации началось с наблюдений отдельных пользователей, одним из которых был специалист, работающий над патентами, связанными с ИИ и использующий ChatGPT для исследований. После интенсивной работы с моделью в течение нескольких недель этот пользователь получил подозрительные запросы на добавление в LinkedIn от профилей с китайскими именами, которые утверждали, что имеют опыт работы в области искусственного интеллекта. Более того, аккаунты выглядели подозрительно: один из них был зарегистрирован как страница вымышленного автора, практически без активности в течение десяти лет до недавнего времени. Такие совпадения вызвали предположения, что возможно произошло несанкционированное получение данных или иное нарушение безопасности. Хотя на данный момент официального подтверждения утечки данных нет, данная история поднимает важные вопросы о том, как защищаются данные пользователей при взаимодействии с ИИ.

В эпоху, когда многие предприятия и частные лица регулярно обмениваются конфиденциальной информацией через цифровые платформы, гарантия безопасности становится первоочередной задачей. ChatGPT и подобные языковые модели обрабатывают огромное количество текстов, многие из которых могут содержать интеллектуальную собственность, личные данные или другие чувствительные сведения. Одним из ключевых аспектов, требующих внимания, является способ хранения и обработки информации внутри платформы. Многие ИИ-сервисы используют облачную инфраструктуру и сохраняют запросы для улучшения качества обучения и сервисов. Если протоколы безопасности окажутся недостаточными, злоумышленники могут получить доступ к хранящимся данным и использовать их в своих целях - от промышленного шпионажа до кибератак на физических лиц.

Еще одной важной проблемой является возможность психологического воздействия на пользователя и социальная инженерия. В примере с LinkedIn, подозрительные аккаунты пытаются наладить контакт под предлогом профессиональных интересов, что может стать точкой входа для сбора дополнительной информации или передачи вредоносных ссылок. Подобные действия уже давно известны в практике киберпреступников и могут значительно усложнить отслеживание реальной угрозы. С точки зрения пользователи, крайне важно соблюдать осторожность при обмене информацией через цифровые каналы, включая ИИ-сервисы. Необходимо тщательно анализировать, кому и в каком объеме предоставляется доступ к конфиденциальным данным.

В случае проявления подозрительной активности - как в социальных сетях, так и в самой системе ИИ - необходимо оперативно информировать соответствующие службы безопасности, а также использовать многофакторную аутентификацию и другие доступные меры защиты. Компании, разрабатывающие и обслуживающие подобные платформы, обязаны инвестировать в безопасное хранение данных, мониторинг и предотвращение утечек. Внедрение новых алгоритмов, минимизация хранения личной информации и регулярные аудиты безопасности помогут снизить риски. Сегодня механизмы конфиденциальности на уровне архитектуры ИИ и этические стандарты становятся неотъемлемой частью развития технологий, поскольку доверие пользователей напрямую влияет на успешность и масштаб внедрения. Эксперты в области кибербезопасности рекомендуют уделять особое внимание обучению пользователей, повышать их осведомленность о современных угрозах и способах защиты.

Для тех, кто активно работает с ИИ, важно помнить, что модель - это инструмент, и конечное решение, как и ответственность за сохранность данных, всегда лежит на человеке. Нельзя забывать и о законодательной базе, регулирующей использование и защиту персональных данных. В разных странах она оперативно адаптируется к появлению новых технологий, включая ИИ. Вступают в силу новые правила, обязывающие компании раскрывать информацию об инцидентах безопасности и принимать меры по восстановлению доверия клиентов. Анализ ситуации с возможной компрометацией данных ChatGPT подчеркивает необходимость такого правового надзора и прозрачности.

Подводя итог, можно сказать, что потенциальное нарушение безопасности данных ChatGPT демонстрирует сложность и важность защиты информации в современном мире ИИ. С одной стороны, технологии открывают невиданные ранее возможности для работы и творчества, с другой - требуют ответственного подхода к личной и корпоративной безопасности. В эпоху цифровой трансформации гармоничное сочетание инноваций и мер защиты позволит максимально безопасно и эффективно использовать потенциал искусственного интеллекта, минимизируя риски и укрепляя доверие пользователей во всем мире. .