Сэм Олтман покинул новый комитет по безопасности OpenAI В мире технологий и искусственного интеллекта новости, связанные с OpenAI, всегда вызывают большой интерес. Недавние изменения в составе Комитета по безопасности и защите, целью которого является обеспечение безопасного развития искусственного интеллекта, стали настоящей сенсацией. Сэм Олтман, генеральный директор OpenAI и один из основателей компании, больше не будет членом данного комитета. Это решение вызвало много вопросов и обсуждений как среди специалистов, так и среди широкой общественности. Решение о создании нового Комитета по безопасности пришло в ответ на растущие опасения о потенциальных рисках, связанных с высокоразвитыми моделями искусственного интеллекта.

По мере того, как технологии развиваются, задачи, стоящие перед ними, становятся все более сложными и серьезными. В этой связи важность надзора со стороны независимого органа нельзя переоценить. Новый комитет возглавит Зико Кольтер, директор кафедры машинного обучения в Университете Карнеги-Меллона. В состав также вошли такие видные личности, как Адам Д'Анджело, генеральный директор Quora, генерал-полковник в отставке Пол Накосоне и бывшая исполнительная вице-президент и генеральный консультант Sony Николь Селигман. Правила нового комитета существенно изменились по сравнению с предыдущей системой.

Ранее комитет просто делал рекомендации, тогда как теперь он будет обладать полномочиями проводить оценки безопасности новых моделей искусственного интеллекта. Это означает, что комитет сможет не только рекомендовать, но и останавливать запуск новых технологий до тех пор, пока не будут решены возникающие проблемы безопасности. Это изменение подчеркивает серьезный подход OpenAI к вопросам безопасности и этичности разработки искусственного интеллекта. Причины, по которым Сэм Олтман покинул комитет, прежде всего связаны с конфликтами интересов. Это решение стало следствием критики в адрес предыдущего руководства компании и имевшихся разногласий с другими членами оригинального комитета по безопасности.

В частности, такие ключевые фигуры, как Илья Сутскевер и Ян Лейк, покинули компанию, выразив недовольство тем, что безопасность и культура безопасности отходят на второй план в пользу более привлекательных продуктов. Лейк, в частности, открыто заявил, что на протяжении долгого времени не соглашался с приоритетами руководства OpenAI, и, в конце концов, это выяснение позиций стало причиной его ухода. Он завил, что компания теряет фокус на основных вопросах безопасности в погоне за прибыльностью и популярностью своих разработок. И это стало сигналом для OpenAI: время кардинальных перемен настало. Новый Комитет по безопасности был создан с целью устранить конфликт интересов и привести процесс разработки и оценки моделей искусственного интеллекта в соответствие с более строгими стандартами безопасности.

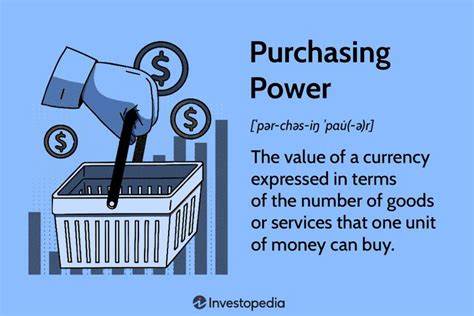

Тем не менее, уход Олтмана вызывает вопросы о том, как это повлияет на дальнейшую стратегию компании и на ее способность привлекать которые ранее работали с ним. Многие эксперты считают, что его уход может ослабить связь между руководством и научной частью, что, в свою очередь, может привести к недопониманию и недовольству среди работников компании. С другой стороны, решение о создании независимого комитета может также предоставлять новые возможности. Оно подчеркивает готовность OpenAI к открытому диалогу о безопасности и этике технологий. Важно осознать, что создание эффективных механизмов контроля – это не просто формальность, а необходимость в быстроменяющемся мире, где возможны непредсказуемые риски.

Теперь, когда комитет будет составлен из независимых экспертов, он сможет более объективно оценивать потенциальные угрозы и предлагать решения. Сэм Олтман остается одной из самых ярких фигур в мире технологий и искусственного интеллекта, и его вклад в развитие OpenAI невозможно переоценить. Под его руководством компания достигла значительных успехов в разработке передовых технологий, таких как GPT-3 и других моделей, которые изменили представления о возможностях искусственного интеллекта. Тем не менее, его уход из комитета также указывает на то, что изменения необходимы для дальнейшего прогресса и развития безопасных технологий. Ситуация вокруг OpenAI и ее новых инициатив иллюстрирует более широкие изменения в мировой индустрии, где вопросы безопасности и этики становятся все более важными.

Растущая осведомленность общества о потенциальных последствиях AI-технологий создает давление на компании разрабатывать более надежные механизмы контроля и безопасные системы. Конечно, последствия этого решения будут складываться не сразу. Однако вполне вероятно, что на создание независимого комитета с новыми полномочиями будет положительно влиять на восприятие OpenAI в обществе. Доверие к технологиям, разработанным компанией, зависит от воспринимаемой способности к надзору и ответственности. Время покажет, насколько успешно удастся новому комитету выполнить поставленные задачи и как это повлияет на репутацию OpenAI в будущем.