В современном мире искусственного интеллекта большие языковые модели (LLM), такие как ChatGPT, Gemini и другие, играют ключевую роль в помощи пользователям получать ответы на самые разные вопросы, в том числе касающиеся актуальных событий и политической ситуации. Однако возникает любопытный феномен — многие пользователи замечают, что LLM продолжают называть Дональда Трампа «бывшим президентом» даже в тех случаях, когда обсуждаются события, происходящие в настоящее время. Это вызывает вопросы о том, как именно эти модели обучаются, обновляют свои знания и почему возникает подобное несоответствие формулировок. Чтобы понять причину, необходимо разобраться в механизмах работы LLM и особенностях их взаимодействия с информацией из реального мира. Прежде всего стоит отметить, что большие языковые модели обучаются на огромных объемах текста, собранного из интернета, книг, статей и других источников.

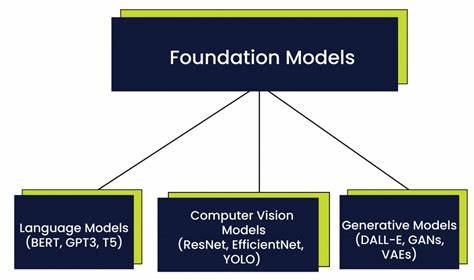

Однако период создания обучающей выборки всегда ограничен конкретной временной рамкой. К примеру, ChatGPT обучался на данных, собранных до 2021 года, а некоторые более новые модели могут иметь обновленную базу знаний, но всё равно с задержкой до нескольких месяцев. Таким образом, основная память модели — это информация, накопленная и структурированная на момент завершения обучения. Любые сведения, появившиеся после этого времени, фактически не хранятся «в голове» модели до тех пор, пока не будет произведено дополнительное обучение или обновление данных через интерфейсы реального времени. В связи с этим, когда пользователь задает вопрос о текущих событиях, модель может обращаться к внешним источникам информации через подключение к интернет-поискам или новостным агентствам.

При таком подходе ответы формируются на основе найденных фактов, но базовая трактовка и терминология зачастую остаётся прежней — той, что была закреплена в основной базе обучения. Подобный эффект можно сравнить с тем, как человек, длительно изучавший какую-то тему и «застрявший» на старой информации, пытается оперативно понять новую ситуацию без полного переосмысления ранее усвоенных понятий. Т.е. название «бывший президент» закреплено в модели как факт, относящийся к Трампу, и это описание не меняется несмотря на новые факты о его участии в политике после окончания президентского срока.

Кроме того, проблема связана с фундаментальным характером LLM, которые основаны на вероятностных языковых паттернах и предсказаниях. Модель выдает наиболее вероятные и распространённые словосочетания, найденные в обучающей выборке, чтобы ответить максимально естественно и реалистично. Так называемые «факты» вовсе не хранятся в виде структурированных данных, как в базе знаний, они представлены через контекст и паттерны слов, с которыми встречалась модель. Если в базе есть устойчивое и частое использование формулы «бывший президент Трамп», модель с большой вероятностью выберет именно такое выражение, даже если контекст указывает на событияпосле его срока. Нельзя забывать и о том, что работа с временными аспектами — одна из сложнейших задач для ИИ.

В реальной жизни информация меняется со временем, и корректное понимание того, что было правдой вчера, может перестать соответствовать действительности сегодня. В традиционных логических системах сложная временная логика является непростой для реализации. LLM, в свою очередь, устроены иначе — они не ведут строгий учёт времени, а вместо этого черпают свои знания из статических текстов. Они не имеют встроенного механизма, способного динамически обновлять статус объектов или событий без повторного обучения или полноценного обновления корпуса данных. Иное представление возникает и в плане речевых норм.

«Бывший президент» — это официальное и юридически корректное название, которое вызывается уважением и подчёркивает позицию Трампа в иерархии политических фигур. Даже если он продолжает активно участвовать в общественной и политической жизни, по президентскому статусу он остаётся именно экс-главой государства, и модели склонны придерживаться формального и устойчивого контекста, который зафиксирован в большинстве источников. При этом многие пользователи отмечают, что данные модели в целом способны предоставлять сведения о последних событиях, упоминая конкретные действия или заявления Трампа. Но такой подход — результат смешения давно усвоенного базового понимания с новообнаруженной информацией. Модель не переосмысливает роль Трампа, а использует свои знания последовательным образом, прочно держа в головной базе обозначение «бывший президент».

Иногда это может создавать ощущение несогласованности, когда факт активности Трампа идёт рука об руку с памятью о его статусе. Также немаловажно отметить, что в свете постоянных изменений продолжается работа над новыми версиями LLM, которые стремятся улучшить учёт временного контекста и обработку свежих данных. Создаются гибридные модели, умеющие легко интегрировать актуальную информацию и при этом сохранять прочную основу знаний. В будущем можно ожидать, что подобные несоответствия станут менее заметными, а ответы станут более динамичными и соответствующими реальным статусам и событиям. В заключение можно подытожить, что причины, по которым большие языковые модели называют Трампа «бывшим президентом» несмотря на знакомство с текущими событиями, связаны с особенностями обучения, типом представленных знаний, трудностями работы с временной логикой и стремлением сохранять формальную терминологию.

Эти модели — не полноценный источник живого знания, а инструмент, базирующийся на анализе текстов с ограниченной способностью к самообновлению и глубокой интерпретации времени и статуса объектов. Со временем, по мере эволюции ИИ и появления новых технологий, эти аспекты будут устранены и модели станут еще более точными, актуальными и чувствительными к изменению контекста в реальном времени.