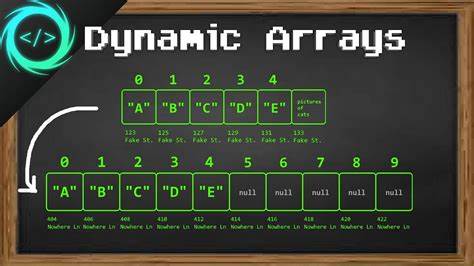

В современном программировании работа с данными переменного объёма является одной из самых распространённых и важных задач. В таких условиях стандартные статические массивы оказываются ограниченными, поскольку требуют заранее заданного максимального размера, что ведёт к излишнему расходу памяти или невозможности обработки увеличивающихся наборов данных. Динамические массивы возникли как универсальное решение этой проблемы, позволяя изменять размер хранилища элементов по мере необходимости без вмешательства программиста. На протяжении десятилетий практически все языки программирования плавно интегрировали динамические массивы, делая сложную работу с памятью полностью прозрачной для разработчиков. Классическим примером служат ArrayList в Java или обычные массивы JavaScript, которые автоматически расширяются при добавлении новых элементов.

Традиционно реализация динамических массивов основана на механизме копирования: когда текущая ёмкость массива достигается, выделяется новый блок памяти, вдвое превышающий предыдущий, после чего элементы переносятся в новую область. Несмотря на кажущуюся простоту, этот процесс обладает рядом недостатков. Во-первых, каждый этап расширения массива сопровождается затратами на копирование всех существующих данных, что особенно заметно при работе с большими объёмами информации. Во-вторых, ссылки или указатели на элементы до расширения становятся недействительными после копирования, что требует дополнительной работы с поддержанием корректности ссылок. Кроме того, эффективность копирования напрямую зависит от расположения и доступности смежных блоков памяти, а невыполнение условия смежности влечёт необходимость дополнительного выделения памяти и перемещения данных.

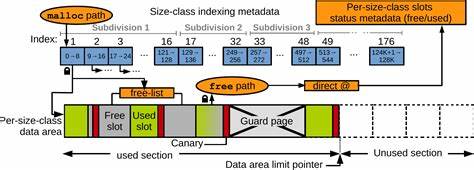

Новое направление в реализации динамических массивов, которое заслуживает особого внимания, опирается на возможности современной архитектуры процессоров и операционных систем, а именно на использование виртуальной памяти и механизмов отображения страниц памяти. Этот подход, называемый отображаемым вариантом динамического массива, предлагает предварительное выделение очень большой области виртуальной памяти (например, порядка одного гигабайта), но физическая память под неё резервируется и отображается только по мере обращения к соответствующим страницам. Иными словами, изначально программный массив занимает огромный диапазон виртуальных адресов без реального выделения физической памяти. Когда код записывает данные в новую часть массива, операционная система перехватывает доступ к неотображенной странице памяти (т.н.

page fault) и под неё выделяется реальная физическая память. Преимущества данного метода наглядны. Во-первых, отсутствует необходимость копирования содержимого при расширении массива: элементы всегда находятся по фиксированным адресам, благодаря чему ссылки на них остаются валидными вне зависимости от количества добавленных данных. Во-вторых, производительность значительно повышается за счёт устранения временных затрат на копирование. Текущие технологии виртуальной памяти делают возможным эффективное использование таких больших предвыделенных областей без фактического потребления большого объёма ОЗУ.

Тем самым разработчик получает динамическую структуру данных с производительностью, близкой к статическому массиву, и гибкостью динамического. Однако у этого подхода есть и свои ограничения. Во-первых, он требует наличия поддержки виртуальной памяти на целевой платформе, что исключает многие встроенные системы и 32-битные архитектуры. Во-вторых, предварительное резервирование большого объёма адресного пространства может показаться расточительным, особенно если реально размер массива остаётся небольшим. Чтобы смягчить этот недостаток, можно комбинировать данный метод с техникой так называемой малой оптимизации для массивов малого размера, где используется более классический подход, а маппинг виртуальной памяти включается при достижении определённого порога.

Не менее важным аспектом является влияние размеров страниц виртуальной памяти на производительность работы маппируемого массива. На архитектуре x86 обычно поддерживаются страницы 4 Кбайт, 2 Мбайт и 1 Гбайт. Использование более крупных страниц снижает число page fault'ов и повышает общую скорость обработки, поэтому эффективная настройка может обеспечить значительный прирост как пропускной способности, так и снижению задержек. Исследования показали, что при использовании 2 Мбайт страниц достигается практически равная производительность базовой статической реализации, что является впечатляющим результатом. Проведённые в разных средах испытания и сравнительные бенчмарки подтверждают эффективность отображаемой реализации.

На примере Linux и экспериментальной ОС FLOS выяснилось, что классический копирующий динамический массив уступает в быстродействии отображаемому варианту, причём преимущество видно во всех сценариях — как при последовательном добавлении большого количества элементов, так и при добавлении в случайных объёмах. Хотя для абсолютного быстродействия статический массив всё ещё опережает оба динамических варианта, достигается впечатляющая близость к оптимальному уровню. На FLOS появилось ещё больше возможностей за счёт гибкой настройки размеров страниц, чего нет в стандартных ОС вроде Linux. Нельзя также не отметить и практические моменты внедрения этой технологии. Хотя для большинства приложений подобное решение будет отличным выбором, важно учитывать специфику целевой платформы и объёмы данных.

Например, при ограниченных ресурсах памяти или на системах без полноценной поддержки виртуальной памяти более безопасным и универсальным остаётся классический подход с контролируемым ростом. Ещё одной особенностью является возможный риск превышения физической памяти в моменты резкого роста массива, что ведёт к появлению page fault с долгими ожиданиями подкачки или исключениям. Современные операционные системы умеют эффективно управлять такими ситуациями, а программный код может реализовать обработку ошибок и ограничения расхода памяти. Портативность и совместимость с разными архитектурами — ещё один вопрос, требующий внимания. Результаты исследований показывают, что даже в пределах широко используемых 64-битных систем могут возникать различия в поддержке и поведении виртуальной памяти, что накладывает дополнительные требования к тестированию и отладке программ с динамическими массивами, построенными на виртуальной памяти.

Тем не менее, преимущества маппируемой реализации динамического массива делают её чрезвычайно привлекательной для разработки высокопроизводительных приложений, игр, обработки больших данных и системного программирования. Она упрощает логику работы с памятью, исключает дорогостоящие операции копирования и распространённые ошибки, связанные с устаревшими указателями или ссылками. По мере развития компьютерных архитектур и совершенствования ОС ожидать улучшений в области управления виртуальной памятью стоит и впредь. Уже сегодня разработчикам стоит обратить внимание на инновационные подходы и экспериментировать с внедрением маппируемых динамических массивов в свои проекты, чтобы обеспечить максимальную эффективность и устойчивость решений. В итоге, динамические массивы — одна из самых фундаментальных структур данных в программировании — продолжают эволюционировать.

Использование потенциала виртуальной памяти кардинально меняет парадигму их реализации, позволяя получать одновременно высокую производительность, удобство и безопасность работы с переменными объёмами данных. Внедрение таких инноваций способно значительно улучшить качество программного обеспечения и эффективность разработки в самых разных областях.