Искусственный интеллект (ИИ) переживает беспрецедентный этап развития, который к 2030 году обещает перевернуть представление о возможностях современных технологий. Начиная с 2020 года, когда самые мощные открытые модели искусственного интеллекта требовали для обучения целых дата-центров, и заканчивая 2029-м, когда те же задачи смогут выполняться на обычном ноутбуке, прослеживается удивительный путь трансформации, подкрепленный многочисленными экспоненциальными тенденциями. Эти процессы не являются простым предположением или научной фантастикой: данные и тренды показывают, что будущее уже практически расписано по времени и технико-экономическим параметрам.</p> В основе столь стремительного развития лежит катализатор в виде масштабного увеличения доступных вычислительных мощностей. В мире инфраструктуры искусственного интеллекта инвестиции в оборудование для обучения моделей становятся крупнейшим пунктом затрат среди гипермасштабных дата-центров.

Компании-лидеры, такие как Microsoft и Meta, уже нарастили десятки сотен тысяч передовых графических процессоров Nvidia, что гарантирует доступ к гигантским объемам параллельных вычислений. Проекты масштаба Stargate, планируемые к концу десятилетия с бюджетом в полтриллиона долларов и миллионами GPU, поражают своим размахом. Эта тенденция отражает не только экономическую и технологическую гонку, но и геополитические устремления, с инвестициями в развитие ИИ от Саудовской Аравии и ОАЭ, что подчеркивает глобальный характер конкуренции и сосредоточения ресурсов на данный сектор.</p> Ускорение вычислительных мощностей уже значительно превзошло классический закон Мура, который утверждал, что количество транзисторов на микрочипе будет удваиваться примерно каждые восемнадцать месяцев. Современные исследования демонстрируют, что вычислительные затраты на обучение масштабных моделей ИИ удваиваются примерно каждые пять с половиной месяцев, что приблизительно в три раза быстрее привычных темпов роста.

Это кардинально меняет динамику развития технологий и дает основания рассчитывать, что к 2030 году мощь искусственного интеллекта вырастет в тысячи раз по сравнению с 2020-м.</p> Помимо необъятных расчетных ресурсов, новая эпоха ИИ характеризуется значительными достижениями в области энергоэффективности и мощностей процессоров. Например, последние поколения графических чипов способны выполнять операции с плавающей запятой с превышающей предыдущие поколения пропускной способностью, что делает модели не только быстрее, но и экономичнее по энергопотреблению. Прогнозы указывают, что к концу 2020-х годов эффективность таких операций может вырасти в тридцать пять раз по сравнению с уровнем 2020 года. Это меняет представления о том, насколько дорогостоящей и энергоемкой будет обработка данных и обучение интеллектуальных систем.

</p> Бум вычислительных мощностей не ограничен исключительно центрами обработки данных. Рост производительности персональных устройств – ноутбуков и смартфонов – также демонстрирует экспоненциальный рост, удваиваясь примерно каждые два года. Ожидается, что к 2027 году обычный потребительский ноутбук будет по мощности сопоставим с графическими процессорами уровня A100, предназначенными для инференса ИИ в 2020-м. Это означает, что полноценные ИИ-решения перестанут быть прерогативой больших корпораций и войдут в повседневный обиход каждого пользователя.</p> Однако вычислительная мощность – лишь одна сторона медали.

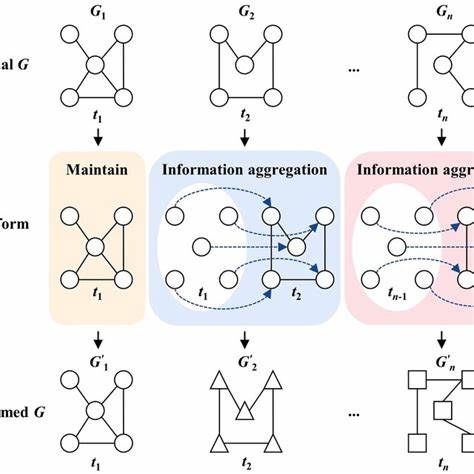

Не менее важным становится рост алгоритмической эффективности моделей. За последние десять лет вычислительные затраты для достижения единичного результата в задачах ИИ сокращались практически вдвое каждые восемь месяцев. Более свежие данные показывают, что эффективность улучшается в три раза ежегодно, что подтверждает скачкообразное развитие интеллектуальных систем не за счет наращивания «железа», а через оптимизацию моделей, сокращение избыточности и внедрение принципиально новых архитектур.</p> Эти успехи зиждутся на глубоких исследованиях в области машинного обучения, в особенности трансформеров и других архитектур, способных более эффективно использовать информацию и обучаться на меньших объемах данных. Благодаря этому снижаются не только временные и энергетические затраты, но и повышается качество результатов, например, способность к генерации более точного, креативного и контекстно релевантного текста или ответов на сложные вопросы.

</p> В совокупности повышение вычислительных мощностей и алгоритмическая оптимизация формируют мощный импульс к «демократизации» искусственного интеллекта. Уже в ближайшие годы персональные устройства смогут запускать модели класса GPT-5 без необходимости подключения к облаку, что откроет доступ к интеллектуальным ассистентам с возможностью решать задачи, ранее требовавшие недель напряженной работы специалистов, менее чем за доллар. Возникают перспективы автоматизации огромного количества рутинных операций, повышения производительности работников и появления новых форм взаимодействия с компьютерами и бытовыми технологиями.</p> Этот эффект уже сегодня ощущается в таких сферах, как обработка естественного языка, компьютерное зрение, робототехника и многие другие. По мере продвижения к 2030 году AI станет неотъемлемой частью инфраструктуры и повседневной жизни, выступая в роли универсального помощника в медицинских диагностических системах, системах управления транспортом, интеллектуальных учебных платформах и в автоматизации производства.

![China's catching up to US AI Here's why it won't matter [video]](/images/FC7A85DD-4ACB-430F-B55A-CCE163F2AEA3)