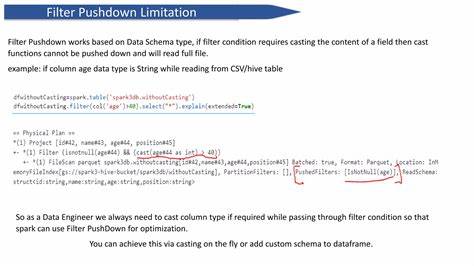

В современном мире обработки данных эффективность выполнения запросов к большим массивам информации играет ключевую роль. В этой связи оптимизация работы с базами данных становится важнейшей задачей для разработчиков и пользователей. Одним из самых интересных и результативных подходов является так называемый «filter pushdown» — оптимизация, направленная на раннее отбрасывание ненужных данных до их загрузки и обработки. Понимание того, как именно работает filter pushdown, позволяет не только повысить производительность, но и снизить расходы на хранение и обработку информации, особенно в облачных и распределённых системах хранения. Filter pushdown — это метод, который позволяет переносить условия фильтрации с этапа обработки данных непосредственно на этап их чтения из хранилища.

Основная идея состоит в том, чтобы заранее отсеять части данных, которые точно не удовлетворяют заданным фильтрам, не загружая их полностью в память и не обрабатывая впустую. Такой подход значительно сокращает объемы передаваемых данных и ускоряет выполнение запросов. Рассмотрим более детально пример с системой Materialize, которая использует эту технологию на практике. Представим, что имеется крупная таблица событий с временной меткой создания и другими параметрами. При выполнении запроса с фильтром на конкретный год, например, для подсчёта количества событий, происходивших в 2025 году, типичный процесс обработки запроса включает несколько последовательных этапов.

Сначала система анализирует метаданные и определяет, какие части данных необходимо загрузить из объектного хранилища. Затем она получает и декодирует эти части, применяет фильтрацию по условию и, наконец, агрегирует отфильтрованные данные для получения результата. Без применения filter pushdown системе приходится загружать и обрабатывать большой объем данных, включая те, которые по фильтру окажутся лишними. Часто данные сгруппированы или же физически разделены на части по временным или другим признакам. Это позволяет определить сегменты, которые с большой вероятностью либо содержат, либо не содержат удовлетворяющие фильтру строки.

Используя filter pushdown, Materialize при анализе запроса уже на этапе выбора частей данных отбрасывает все те, которые заведомо не содержат интересующую информацию. Таким образом, снижается объем передаваемых данных и время отклика. Для реализации filter pushdown система Materialize собирает статистические данные о каждой части внутри метаданных. Одним из таких показателей является «nullability» — статистика о наличии или отсутствии NULL-значений в столбцах. Этот показатель позволяет быстро понять, можно ли исключить определённую часть данных при фильтрации по условию наличия или отсутствия NULL.

Если столбец в части данных никогда не содержит NULL, и запрос ищет строки с NULL, то эта часть сразу может быть исключена из обработки. Дальнейшее улучшение достигается за счет введения анализа диапазонов значений в столбцах. Вместе с информацией о nullability Materialize хранит минимальные и максимальные значения каждого столбца для каждой части данных. Это позволяет не только учитывать наличие пустых значений, но и определять диапазон возможных значений, что важно при запросах с условиями сравнения, например, фильтры по дате или по числовым показателям. Например, если временные метки в части ограничены диапазоном с 2022 по 2024 год, а фильтр запросит события 2025-го, такая часть может быть пропущена без загрузки и проверки.

Однако реализация фильтрации на уровне метаданных требует точных и продуманных алгоритмов анализа фильтров. В системах типа Materialize применяется метод, известный как абстрактная интерпретация, используемый для статического анализа программ. В условиях filter pushdown он позволяет определить, при каких условиях сложные фильтры, состоящие из множества функций и выражений, могут возвращать истинное значение на основе статистик, вместо выполнения фактической выборки и фильтрации всех строк. Абстрактные значения в этой интерпретации представляют собой обобщенные множества возможных конкретных значений. Статистики nullability и диапазонов формируют часть таких абстрактных представлений.

Для операторов и функций SQL существуют «абстрактные функции», которые принимают абстрактные значения и возвращают оценку результата фильтрации. Это позволяет последовательно анализировать сложные запросы и принимать решение о необходимости загрузки части данных без их фактического разворачивания и фильтрации. Преимущество такого подхода — в обеспечении безопасности и консистентности результата. Поскольку абстрактная интерпретация ориентируется на консервативные оценки, большое значение имеет отсутствие ложных отрицательных срабатываний, то есть пропуска релевантных данных. Допустимо лишь загрузить данные, которые затем будут отфильтрованы, но никогда — наоборот.

Для этого реализованы механизмы тестирования и аудита, включая рандомизированную загрузку отсеянных частей с проверкой правильности алгоритма. Следует отметить, что использование статистических данных налагает некоторое влияние на процесс записи данных. Для того, чтобы статистики были актуальными и точными, система при создании новых частей данных анализирует значения каждой колонки и записывает обобщённые характеристики в метаданные. Это повышает затратность записи, однако выгодно сказывается на быстродействии и стоимости запросов в дальнейшем. Помимо технических аспектов, filter pushdown оказывает значительное влияние на эффективность обработки данных в реальных условиях.

В системах с очень большими наборами данных, хранящихся в облаке или распределённых хранилищах, поток трафика и время ожидания при выполнении запросов критически зависят от объемов передаваемых данных. Благодаря filter pushdown удается существенно снизить нагрузку на сеть и вычислительные ресурсы, поддерживая низкую задержку отклика и уменьшая затраты на инфраструктуру. Особенно это заметно на фильтрах, нацеленных на временные интервалы или конкретные значения, при наличии грамотной партиционизации данных. Важным моментом является также универсальность решения. Обычные системы фильтрации на стороне хранилищ зачастую ограничиваются простыми или очень специфичными вариантами.

Materialize же при помощи абстрактной интерпретации и метаанализа функций SQL предлагает более гибкий метод, способный эффективно обрабатывать даже сложные запросы с использованием функций и выражений различного уровня сложности. Это расширяет спектр применимости оптимизации и соответствует реальным пользовательским сценариям. Еще одним аспектом является влияние фильтрации на дизайн базы данных и формирование запросов. Оптимальное использование filter pushdown требует, чтобы данные хранились в частях (или партициях), оформленных по осмысленным признакам. Для временных данных рекомендуется хранить их по месяцам или годам, что существенно упрощает фильтрацию.

Аналогично для других типов значений создаются партиции по наиболее часто используемым критериям фильтрации. Такой подход позволяет максимально эффективно применять filter pushdown и добиваться наилучших показателей производительности. Кроме того, filter pushdown служит базой для построения других оптимизаций. Его концепция масштабируется и интегрируется в более сложные механизмы оптимизации запросов, в том числе в комбинированные фильтры, адаптивные выборки и динамическое управление ресурсами. Учитывая рост объёмов данных и многообразие источников, эти методы становятся неотъемлемой частью современных аналитических платформ.

В заключение, filter pushdown представляет собой мощный инструмент оптимизации производительности баз данных, который существенно снижает нагрузку на систему, ускоряет запросы и уменьшает операционные расходы. Его ключевая сила заключается в раннем отсеве ненужных данных, что достигается за счёт аккумулирования и анализа метаданных, применения статистических сводок и абстрактной интерпретации сложных фильтров. Для пользователей и разработчиков важно понимать принципы работы и условия успешного применения этой технологии, чтобы максимально эффективно использовать её потенциал и создавать высокопроизводительные решения для работы с большими данными.