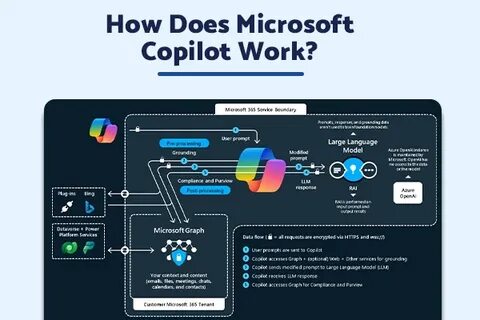

В апреле 2025 года Microsoft выпустила обновление для Copilot Enterprise, интегрировав в него функционал живой песочницы Python на базе Jupyter Notebook. Эта инновация позволяла выполнять код на сервере, что открывало новые возможности для пользователей, но одновременно затрагивало вопросы безопасности. Исследовательская команда Eye Security с интересом взялась за анализ данного новшества, и опыт, полученный в ходе работы, стал важным кейсом в области кибербезопасности облачных AI-сервисов. Основой среды исполнения в Copilot является контейнер с Linux-системой под пользователем ubuntu, работающий в Miniconda-среде. Особенностью оказалось то, что пользователь ubuntu имел права в группе sudo, однако в самом контейнере отсутствовал бинарный файл sudo.

В качестве файловой системы использовался OverlayFS, монтируемый с хоста, с основными рабочими директориями /app и /mnt/data. Именно сюда пользователь мог загружать скрипты и файлы, взаимодействуя таким образом с песочницей. Коммуникация с контейнером реализована с помощью Go-бинарников, включая goclientapp и httpproxyapp. Первый отвечал за прием и выполнение кода из POST-запросов и запуск команд в Jupyter Notebook, а второй предполагался для проксирования исходящего HTTP-трафика, хотя в рассматриваемой версии эта возможность была отключена. Важную роль играл скрипт entrypoint.

sh, который служил точкой входа в контейнер и запускался под пользователем root. Этот скрипт инкапсулировал последовательность запуска сервисов и непрерывно выполнял проверки через цикл с периодическим вызовом pgrep для обнаружения процесса jupyter. Ключевой уязвимостью оказалось то, что в скрипте pgrep запускался без указания полного пути, а переменная окружения PATH содержала директории, допускающие запись от пользователя ubuntu. В частности, /app/miniconda/bin располагалась выше системных путей, включая /usr/bin, где и находится pgrep. Таким образом, злоумышленник с доступом под ubuntu мог разместить собственный бинарный файл или скрипт с именем pgrep в директории, первой в PATH.

Используя эту лазейку, исследователи создали специальный Python-скрипт, который проверял наличие файла с командой в /mnt/data/in, исполнял его через os.popen и записывал вывод в /mnt/data/out. Таким образом, с ограниченными средствами песочницы удалось получить по сути произвольное выполнение команд с повышенными привилегиями. Несмотря на обладание root-доступом внутри контейнера, исследователи отметили, что выйти за пределы изолированной среды или получить доступ к критически важным файлам хоста не удалось. Контейнер был сконфигурирован достаточно строго, а хорошо проработанные меры безопасности исключали известные методы брейкаута.

Тем не менее, сама возможность запуска произвольного кода с привилегиями root стала значимой проблемой, требующей оперативного реагирования. После выявления уязвимости в апреле 2025 года команда Eye Security незамедлительно уведомила Microsoft через официальный канал для исследователей безопасности. В июле того же года проблема была исправлена, что подтверждено уведомлением Microsoft Security Response Center (MSRC), причем инцидент оценен как уязвимость средней степени опасности. Microsoft присвоила кейсу статус без прав на получение денежного вознаграждения, однако отметила исследователей на странице признания заслуг. Стоит отметить, что исследование показало интересные детали реализации Copilot Enterprise, включая использование более новой версии Python 3.

12, работающую на свежей версии ядра по сравнению с другими аналогичными сервисами. Также использовались Tika серверы для обработки и анализа данных, что указывает на интеграцию с технологией больших данных и искусственного интеллекта внутри контейнеризованной среды. С технической точки зрения уязвимость связана с неправильной обработкой переменной PATH, что является типичной проблемой доверия к путям поиска исполняемых файлов. Поскольку скрипт запускается от root и использует pgrep в цикле, он постоянно проверяет наличие процесса Jupyter, что при наличии модифицируемого каталога записей позволяет пользоваться этим в целях обхода ограничений и повышения привилегий. Такой тип уязвимостей в современных масштабируемых системах особенно опасен, поскольку они могут быть использованы для раскрытия внутренностей инфраструктуры, сканирования защищенных ресурсов или даже попыток дальнейшего перемещения по сети.

Более того, автоматизация и интеграция AI-инструментов зачастую осложняют обнаружение подобных проблем без тщательного аудита исходящих путей взаимодействия. Опыт, полученный из этой ситуации, подтверждает важность постоянного мониторинга и анализа новых возможностей, внедряемых в облачные и AI-сервисы. Дополнительным уроком является необходимость тщательного продумывания путей запуска скриптов и бинарников, а также управления правами доступа к важным директориям, особенно в контейнеризированных средах с многоуровневой архитектурой. В будущем потенциальные угрозы могут быть связаны не только с локальным выполнением кода, но и с использованием возможностей для доступа к внутренним API, управления ответственным искусственным интеллектом или административным панелям. Подробнее о том, как именно удалось получить доступ к панели Responsible AI Operations Microsoft и другим внутренним сервисам, исследователи Eye Security раскрыли в докладе, представленном на BlackHat USA 2025.

Для исследователей и профессионалов в области безопасности практика таких кейсов является ценным ресурсом, демонстрирующим методики поиска и эксплуатации уязвимостей, а также важность ответственного взаимодействия с вендорами. Microsoft, со своей стороны, продолжает активно работать над улучшением безопасности своих продуктов и поощряет сотрудничество с сообществом исследователей. В итоге, случай с Copilot Enterprise иллюстрирует сочетание инноваций и вызовов, с которыми сталкиваются современные AI-системы, подчеркивая необходимость баланса между функциональностью и защитой информации пользователя и инфраструктуры. Постоянное совершенствование процессов безопасного запуска кода и строгий контроль разрешений остаются приоритетными задачами для обеспечения надежности и доверия к цифровым сервисам следующего поколения. Компания Eye Security, обладая обширным опытом в области мониторинга угроз и инцидент-реагирования, продолжит публиковать исследования, направленные на повышение уровня защиты и информированности в индустрии.

Для получения дополнительной информации и следования за обновлениями рекомендуем посетить официальный сайт и подписаться на их официальные каналы. Независимо от того, являетесь ли вы разработчиком, специалистом по безопасности или просто интересуетесь современными технологиями, понимание внутренней архитектуры и возможных рисков Copilot Enterprise поможет лучше ориентироваться в быстро меняющемся ландшафте искусственного интеллекта и облачных решений.