В современном мире искусственный интеллект (ИИ) быстро развивается, выходя за рамки традиционных цифровых приложений и стремясь понять и взаимодействовать с физическим миром более глубоко и осознанно. Одной из наиболее многообещающих технологий в этом направлении являются визуальные языковые модели действия, или VLAM (Visual Language Action Models). Эти модели интегрируют визуальную информацию, языковое описание и модель действий, чтобы создавать более комплексное понимание окружающей среды и прогнозировать правила взаимодействия в реальном времени. В статье мы подробно рассмотрим, что представляют собой VLAM, почему они важны, как они работают и какие перспективы открывают для будущего искусственного интеллекта. Одной из ключевых проблем создания ИИ, способных работать в реальном мире, является его способность понимать физические объекты и их взаимодействия.

Традиционные системы, такие как рекомендательные алгоритмы или системы модерации контента, работают в ограниченных цифровых рамках, где ошибки сравнительно безвредны. Однако попытки внедрить ИИ в физическую среду сталкиваются с гораздо большими рисками и сложностями. Ошибки могут привести к реальному вреду или сбоям. В таких условиях модели должны не только распознавать объекты, но и прогнозировать последствия своих действий, а также понимать контекст сцены. VLAM - это шаг к решению этой задачи.

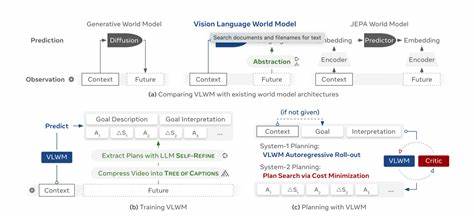

Основная идея визуальных языковых моделей действия заключается в объединении нескольких типов данных и знаний. Во-первых, это визуальные данные, например видеопоток с камеры или изображения. Во-вторых, лингвистическая информация - описание того, что происходит, или способности описывать и интерпретировать действия на языке. В-третьих, модель действий - набор правил или процедур, которые позволяют ИИ не просто воспринимать окружение, а активно взаимодействовать с ним и прогнозировать развитие событий. Таким образом модели VLAM становятся инструментом, который симулирует человеческое понимание сцены, включая причинно-следственные связи и намерения.

Важным компонентом VLAM является способность к физическому рассуждению или physical reasoning. Это означает, что модель не просто идентифицирует объекты, но и анализирует, как объекты взаимодействуют, какие силы и воздействия присутствуют, какие действия могут привести к каким результатам. Например, если в видео показано, как человек ставит книгу на наклонную поверхность, VLAM может предсказать, что книга может соскользнуть. Такое глубокое понимание основано на знании фундаментальных физических закономерностей и умении применять их в конкретных ситуациях. Одной из главных технологических трудностей является интеграция визуального восприятия с языковым описанием и действиями.

Наука добилась успехов в области компьютерного зрения и обработки естественного языка, однако комбинировать эти области для создания моделей, которые достигают адекватного понимания физической сцены, сложнее. Задача состоит в том, чтобы не просто распознавать объекты, но и строить смысловые модели, связывающие визуальные элементы с их функциями и возможностями взаимодействия. Современные VLAM используют нейросетевые архитектуры глубокого обучения, которые обучаются на больших объемах данных, включающих видео с разметкой, описаниями и действиями. Обучение происходит в нескольких режимах: распознавание объектов, генерация описаний сцены, предсказание действий на основе визуальных данных. Применение таких моделей позволяет создавать интеллектуальные агенты, способные понимать сложные ситуации и совершать действия, основанные на реальном контексте.

Практическое применение VLAM можно встретить в робототехнике, где роботы обучаются выполнять задачи в физическом пространстве с помощью видеоанализа и команд на естественном языке. Например, робот может получить инструкцию собрать предметы на столе или переставить объекты в определенном порядке, используя VLAM для анализа сцены и корректировки своих действий в ходе выполнения задачи. Аналогично такие модели могут использоваться в системах наблюдения, автономных транспортных средствах и любых сценариях, требующих гибких решений в реальном времени. Однако развитие VLAM также содержит ряд вызовов. Во-первых, необходимы огромные вычислительные ресурсы для обучения и работы моделей в реальном времени.

Во-вторых, сложность физического мира и разнообразие сценариев затрудняют создание универсальной модели, способной работать во всех условиях. В-третьих, вопрос безопасности и контроля работы таких систем остается приоритетным, учитывая возможные последствия ошибок в физической среде. Рассмотрение VLAM становится важным в контексте глобального развития ИИ, поскольку они воплощают попытки приблизить машины к человеческому уровню понимания. Будущее может привести к появлению систем, которые не только воспринимают видеоряд, но и способны объяснять, прогнозировать и обучаться через взаимодействие с реальным миром, используя визуальный язык действия. Это откроет новые горизонты для автоматизации, интеллектуального анализа и синтеза человеческих навыков в цифровом формате.

В заключение, визуальные языковые модели действия представляют собой революционный этап на пути к созданию действительно понимающего ИИ, способного действовать и мыслить в сложном физическом мире. Их потенциал выходит далеко за рамки текущих цифровых приложений, предлагая качественно новый подход к взаимодействию и осмыслению информации. Постоянное развитие алгоритмов, расширение обучающих наборов данных и повышение эффективности вычислений будут способствовать внедрению VLAM в самые разные сферы человеческой жизни, меняя наше представление о возможности искусственного интеллекта. .