В эпоху стремительного внедрения генеративных искусственных интеллектов (GenAI) компании сталкиваются с необходимостью интеграции этих технологий в свои информационные системы, сохраняя при этом соответствие строгим требованиям регулятора и внутренним политикам управления рисками. В особенности это актуально для сфер с высокой степенью регулирования — финансы, здравоохранение, государственные учреждения и другие, где малейшее несоответствие может привести к серьезным юридическим и репутационным последствиям. Одной из ключевых задач становится перевод высокоуровневых, зачастую бизнес-ориентированных политик управления рисками искусственного интеллекта (ИИ) в конкретные, понятные и управляемые задачи для разработчиков, а также обеспечение надежного контроля их выполнения. Чаще всего политики разрабатывают команды по управлению рисками и соответствию требованиям (GRC), ориентированные на стратегические и организационные аспекты, что формирует разрыв между формулировками и технической реализацией. Этот разрыв осложняет не только процесс внедрения адекватных контрольных мер, но и последующую проверку их эффективности.

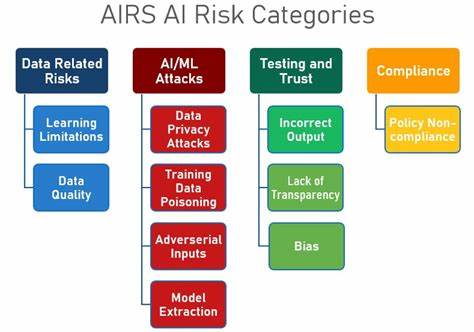

Сложность заключается в возможности объективной оценки, действительно ли реализованные меры обеспечивают ожидаемый уровень безопасности и управляемости ИИ, а также в автоматизации таких проверок в условиях динамичных CI/CD процессов. Один из ключевых вопросов, с которыми сталкиваются компании, — как сделать так, чтобы политика риска ИИ перестала быть абстрактной декларацией и стала конкретным, измеримым набором требований. Для этого необходимо наладить коммуникацию между специалистами GRC и командами разработки. Важным этапом является декомпозиция высокоуровневых политик на более мелкие, технически осуществимые требования, которые можно внедрить и протестировать. Например, политика, регламентирующая обязательное отсутствие предвзятости в алгоритмах принятия решений, может быть переложена на создание контрольных механизмов оценки качества данных, реализации функций мониторинга статистики ошибок, а также внедрение инструментов аудита моделей.

Кроме того, необходимо четко определять метрики и критерии, по которым будет осуществляться проверка выполнения политики. Это дает разработчикам четкое представление о конечной цели и способах доказательства соответствия. Для интеграции контроля в процесс разработки и доставки ПО (SDLC) все чаще используют автоматизацию. Внедрение проверок с помощью специализированных инструментов в CI/CD конвейеры позволяет не допускать на продакшен решения, нарушающие политики ИИ, например, обнаружение запрещенных данных для обучения, оценка рисков модели, проверка на наличие уязвимостей и др. Автоматизация мониторинга после развертывания также важна и служит дополнительной гарантией.

Она помогает ловить отклонения от заданных норм поведения моделей в реальном времени и оперативно реагировать. Среди популярных инструментов и платформ, способствующих управлению рисками ИИ, выделяются фреймворки для аудита моделей, платформы по объяснению моделей (model explainability), а также специализированные решения для мониторинга и отчетности. Использование открытого программного обеспечения в сочетании с собственными разработками позволяет создать гибкую экосистему контроля, адаптируемую под специфические требования компании. В операционализации AI risk governance в SDLC часто встречаются дополнительные вызовы. Это необходимость постоянного обучения и повышения квалификации разработчиков в области ответственного использования ИИ, сложность управления данными с точки зрения конфиденциальности и безопасности, а также быстро меняющиеся нормативные требования и стандарты.

Все это требует от компаний не только технических, но и организационных изменений для формирования культуры ответственности и соблюдения рисков. В конечном итоге, успех перевода высокоуровневых политик риска ИИ в конкретные задачи зависит от совместных усилий разных подразделений, использования современных инструментов и методов, а также от гибкости и проактивного подхода к управлению изменениями. Так компании смогут максимально эффективно реализовать потенциал искусственного интеллекта, сохраняя при этом безопасность, доверие и соответствие нормативам.