В последние годы искусственный интеллект стремительно развивается, а значительную роль в этом процессе играют большие языковые модели (LLM), такие как GPT и Claude. Эти модели предназначены для обработки и генерации естественного языка, что позволяет им выполнять широкий спектр задач, от простого общения с пользователем до решения сложных проблем, включающих многократное логическое рассуждение. Однако, несмотря на мощь и универсальность таких систем, их эффективность долгое время ограничивалась устаревшими методами обучения, основанными на имитации человеческого поведения. Столкнувшись с проблемами компаундинга ошибок и неспособностью к последовательному решению многошаговых задач, исследователи и инженеры были вынуждены пересмотреть подходы к обучению моделей. Ключевым переворотом стало широкое внедрение методов обучения с подкреплением и развитие технологий, позволяющих моделям не просто копировать тексты, но и самостоятельно учиться на собственных ошибках.

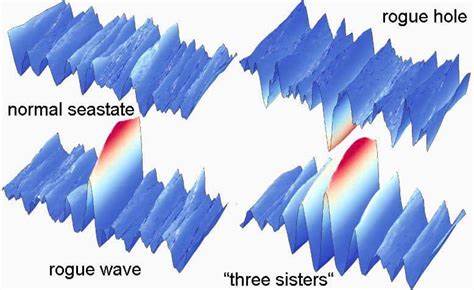

Традиционный этап обучения больших языковых моделей строился на принципе предсказания следующего слова в тексте на основе огромных массивов данных, составленных из различных публичных источников. Этот подход, называемый также имитационным обучением, обеспечивает модели способность воспроизводить грамматически правильные и семантически связные предложения, приближая ее к стилю и контексту человеческого языка. Тем не менее, несмотря на впечатляющие результаты, именно этот тип обучения содержит фундаментальные ограничения. Одной из основных проблем стала так называемая проблема накопления ошибок. Если модель в процессе генерации допускает ошибку, это отклоняет ее в область, не представленную в обучающих данных, что увеличивает вероятность последующих ошибок и негативно сказывается на качестве результатов.

Такие сбои особенно проявлялись в задачах, требующих многократного планирования и последовательного выполнения действий — например, в проектах BabyAGI и AutoGPT, которые пытались использовать языковые модели для автономного решения комплексных задач. Опыт контроля моделей в играх, таких как SuperTuxKart, помог ученым понять, что для повышения устойчивости к ошибкам и способности к самостоятельному обучению необходим принцип проб и ошибок — фундаментальный принцип обучения с подкреплением. В таком подходе модель не просто копирует поведение эксперта, а получает обратную связь о результатах своих действий и учится улучшать их, стремясь максимизировать общую награду или пользу. Это позволило решить проблему выхода за пределы обучающего распределения: вместо того чтобы полагаться на ограниченный набор примеров, модели начали систематически исправлять собственные промахи, развивая навыки комплексного рассуждения и поиска решений. Развитие методов подкрепляющего обучения обрело принципиальную значимость благодаря появлению эффективных механизмов автоматизации оценки качества ответов моделей.

Ведь человек не способен вручную оценивать миллионы ответов, генерируемых на этапе обучения, особенно учитывая многообразие ошибок, которые могут возникать в текстах. Наиболее распространенной и успешной на данный момент техникой стала Reinforcement Learning from Human Feedback (RLHF) — обучение с подкреплением на основе человеческой обратной связи. Оно состоит из нескольких этапов: сначала человеческие рецензенты оценивают пары ответов модели и выбирают лучший, затем эта оценка используется для обучения вспомогательной модели, предсказывающей качество текста, которая в свою очередь становится функцией награды для процесса обучения основной модели. Такая схема позволяет моделям учиться на предпочтениях пользователей без необходимости детальной разборчивой проверки каждого отдельного примера. Параллельно с RLHF развивался метод Constitutional AI, предложенный компанией Anthropic.

Его суть состоит в том, что модель-«судья» на основе набора принципов, сформулированных в простом и понятном виде (конституции), сама оценивает выводы обучаемой модели и её соответствие этим принципам. Такой подход снижает прямую зависимость от человеческого фактора, минимизируя стоимость и время на подготовку данных для обучения. При этом он требует наличия достаточно сложной модели для выполнения роли инспектора, что создает процесс самобустинга: более совершенные версии моделей используются для тренировки их упрощенных, более экономичных вариантов с сохранением высокого качества работы. Значительный прорыв в возможностях LLM связан с освоением цепочки рассуждений — способности разбивать сложные задачи на последовательные логические шаги и генерировать расширенные «мысленные» процессы до выдачи окончательного ответа. Обучение моделей при помощи подкрепления позволило добиться того, что они стали лучше справляться с долгими многослойными запросами, снижая эффект накапливающихся ошибок и повышая точность итоговых результатов.

Примером является модель o1 от OpenAI, которая способна генерировать тысячи токенов с размышлениями и аналитикой, значительно улучшая качество ответов. Еще одним любопытным примером стал китайский проект DeepSeek с моделью R1. Исследователи обучали её решать сложные математические и программные задачи, где можно объективно оценить правильность ответа. В ходе обучения модель научилась самостоятельно продлевать время размышлений, пересматривать собственные шаги и искать альтернативные решения — всё это без прямого программирования таких стратегий. Так называемые рефлексия и планирование — умения, которые обычно считаются сугубо человеческими, проявились как естественные следствия процесса подкрепляющего обучения.

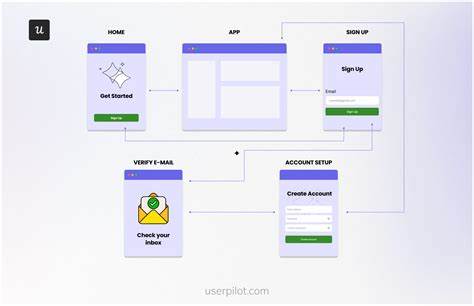

Результаты внедрения новых методов обучения позволили вывести ИИ на качественно новый уровень. Автономные агенты, которые раньше ограничивались простыми задачами, стали способны выполнять сложные многоступенчатые операции, включая разработку программного обеспечения, углубленный исследовательский поиск и управление программами с использованием виртуальной клавиатуры и мыши. Такие возможности открывают широкие перспективы для интеграции ИИ в повседневную работу, облегчения создания приложений и значительного повышения продуктивности разработчиков и специалистов различного профиля. Другим важным аспектом стало развитие новых архитектур и систем, позволяющих моделям эффективно работать с длинными контекстами, что существенно расширяет их «память» и способность к углубленному анализу информации. Вместо однократного поиска данных и генерации ответа современные модели могут iteratively пересматривать запросы, уточнять поисковые параметры, совершенствовать план действий и достигать более точных и обоснованных выводов.

Такая итеративность стала возможна именно благодаря повышению устойчивости и последовательности поведения, обеспеченного методами обучения с подкреплением. Сравнение имитационного обучения и подкрепляющего обучения показывает, что оба подхода имеют свои плюсы и недостатки. Имитация обеспечивает быстрый старт и освоение базовых навыков, опираясь на широкий объем данных, а обучение с подкреплением — постепенное улучшение результатов, особенно в новых, ранее неизученных сценариях. Комплексное применение этих методов — сначала имитация для заложения фундамента, затем подкрепление для достижения мастерства — стало стандартом в индустрии. Очевидно, что нынешняя революция в возможностях больших языковых моделей произошла именно благодаря смене акцентов в обучении — от пассивного копирования текста к активному обучению на своих ошибках с помощью подкрепления.

Чтобы сделать ЛЛМ по-настоящему интеллектуальными помощниками, способными эффективно планировать, принимать решения и корректировать свои действия, этого шага не избежать. В ближайшем будущем можно ожидать еще более глубокой интеграции моделей с подкрепляющим обучением в различные сферы деятельности. Это позволит создавать надежных цифровых агентов, которые смогут работать в условиях неопределенности и решать творческие задачи на уровне, близком к человеческому мышлению. Такие системы найдут применение в медицине, образовании, инженерии, юридической практике и многих других областях, где важна способность обрабатывать сложные сценарии и предоставлять обоснованные рекомендации. Таким образом, переход к методам обучения с подкреплением ознаменовал новый этап в развитии искусственного интеллекта.

Он стал тем ключом, который открыл двери к значительно более высокому уровню понимания и интеллектуальных возможностей больших языковых моделей. Благодаря этому прогрессу появляются полностью новые классы приложений, а привычный нам ИИ преобразуется из инструмента для генерации текста в полноценного интеллектуального агента, способного на творческое и самостоятельное мышление.