Тестирование программного обеспечения всегда было важным этапом разработки, существенно влияющим на качество конечного продукта. В классической модели разработки приоритетом становится юнит-тестирование — написание небольших, изолированных тестов, которые проверяют корректность отдельных функций или модулей. Этот метод позволяет выявить регрессии и ошибки на ранних стадиях, прежде чем код попадет в руки пользователей. Но к современным системам на основе искусственного интеллекта такой подход сложно применим напрямую. Особенно остро это проявляется в случае агентных ИИ — автономных систем, способных взаимодействовать с внешними инструментами, API и пользователями в ходе длительных и сложных диалогов или действий.

Традиционные методы тестирования часто не справляются с задачей черезмерной изменчивости, неопределенности и сложных сценариев поведения таких агентов. Именно здесь на сцену выходят симуляции агентов — новый способ тестирования, который можно считать аналогом юнит-тестов в традиционном программировании, адаптированным под особенности ИИ. Эти симуляции создают контролируемые, структурированные и повторяемые сценарии, призванные проверять, как агент ведет себя при возникновении различных сложных и редких ситуаций, которые редко встречаются в реальной эксплуатации, но могут привести к критическим ошибкам. Подобная идея родилась из опыта разработки автономных автомобилей, где уже давно поняли, что сбор только реальных данных ограничен и не покрывает всех редких событий. Зато моделирование и воспроизведение сценариев с возникновением пограничных, аномальных ситуаций позволяют значительно повысить надежность.

У ИИ, особенно у многозадачных агентов, ситуация аналогична: агент работает в условиях, насыщенных непредсказуемыми факторами — сменой намерений пользователя, сбоями внешних сервисов, несовершенством собственных предположений. Тестировать такие поведения надо, фиксируя задачи в виде сценариев и прогоняя их повторно, отслеживая результаты. Применение симуляций в цикле разработки позволяет не просто отлавливать ошибки после релиза, а предпринимать профилактические меры в самом процессе. Важно, что эти симуляции не стремятся к абсолютному покрытию всех возможных ситуаций, а концентрируются на проверке наиболее значимых и рискованных кейсов, где особенно возможно проявление скрытых дефектов. Результатом становится постепенное повышение качества и безопасности агента благодаря постоянной автоматизированной проверке ключевых сценариев.

Практическая реализация таких симуляций часто основывается на нескольких ключевых компонентах. Во-первых, это сам агент под тестированием — автономный ИИ, который должен выполнять поставленные задачи в рамках симулируемой ситуации. Во-вторых, вокруг агента выстраивается пользовательский симулятор, который имитирует поведение человека, задавая вопросы, меняя намерения, провоцируя сбои. Наконец, существует судья или оценщик — другой агент или программа, которая оценивает успешность прохождения сценария, ставит вердикт на основе заранее заданных критериев. Такой цикл имитации диалогов и взаимодействий позволяет создавать условия, близкие к реальным, одновременно контролируемые и воспроизводимые.

Он напоминает цикл разработки с тестами: сначала создается сценарий с четким описанием и критериями, затем симуляция запускается, изначально ожидается провал теста — после чего проводится корректировка поведения агента. Повторные прогоны демонстрируют прогресс и стабильность. Для удобства и повышения эффективности разработчики создают специальные фреймворки, которые автоматизируют создание и управление симуляциями. Примером может служить проект Scenario, позволяющий описывать сценарии, задавать правила оценки и комбинацию агентов, работающих в рамках одной симуляции. Такой инструментарий дает гибкость: можно задавать полностью автоматическое проходжение, или вручную управлять частями диалога, подменять реплики, «подбрасывать» сбои внешних инструментов и проверять реакцию агента.

Кроме того, встроенные в тесты коллбэки и проверки позволяют расширять логику валидации, например, контролировать вызовы API, состояние промежуточных инструментов, соблюдение правил безопасности. Все это становится возможным благодаря следующим преимуществам агентных симуляций. Во-первых, они дают возможность на ранних стадиях выявлять сложные ошибки, которые не проявились бы при тестировании отдельных функций или коротких запросов. Во-вторых, симуляции помогают отслеживать и предотвращать регрессии при обновлениях модели, изменениях промптов или интеграций с новыми сервисами. В-третьих, они обеспечивают уровень прозрачности и воспроизводимости, позволяя независимо анализировать проваленные сценарии и улучшать алгоритмы поведения.

Кроме того, agent simulations способствуют более безопасному развёртыванию ИИ в реальных приложениях. Автономные агенты, работающие с конфиденциальной информацией или принимающие важные решения, должны проходить тщательную проверку перед выходом «в поле». Сценарные тесты позволяют имитировать атаки, ошибочные условия, сбои и гарантировать, что система сможет корректно реагировать и не навредит пользователю или бизнесу. Следует также отметить, что это не универсальное решение для всех проблем тестирования ИИ, а скорее эффективный инструмент для конкретного класса задач, связанных с агентным поведением и долгосрочными интерактивными сценариями. В сочетании с классическими методами, такими как метрики качества, A/B тестирование, ручной анализ и автоматические эвристи-вы (evals), симуляции становятся незаменимой частью современной системы контроля качества.

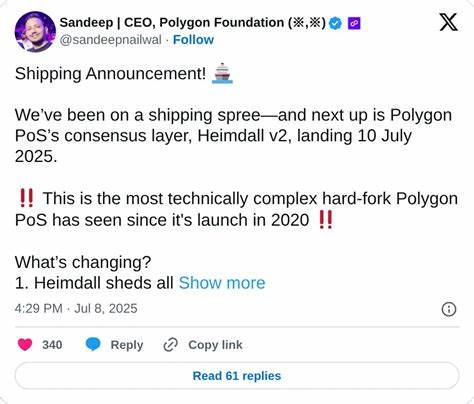

Масштабирование и развитие симуляций требуют также поддержки в виде версионирования сценариев, интеграции в непрерывные системы интеграции и развертывания (CI/CD), мониторинга и аналитики. Это помогает строить культуру ответственной разработки, где изменение поведения интеллектуальных агентов контролируется на всех этапах, а качество систем «поддерживается» активно, а не пассивно. Современное сообщество разработчиков ИИ активно обсуждает методику агентных симуляций, делится практиками и инструментами, что способствует стандартизации и распространению лучших подходов в индустрии. В конечном счете, именно зрелое и системное тестирование, в том числе через симуляции, позволит сделать ИИ более надежным, понятным и безопасным для пользователей и бизнеса. Вывод очевиден: от простых unit-тестов для изолированных функций мы переходим к моделированию поведения и взаимодействия агентов в комплексных условиях.

Такой подход повышает качество, снижает риски и открывает новые горизонты для контроля над сложными интеллектуальными системами будущего.