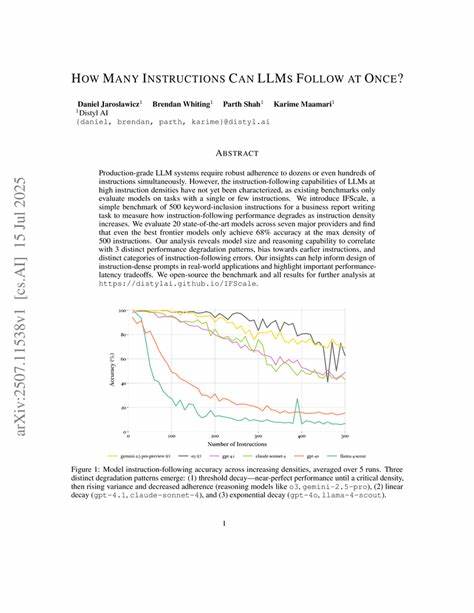

В современном мире искусственный интеллект прочно вошел в повседневную жизнь и промышленность, а большие языковые модели (LLM) играют ведущую роль в развитии технологий обработки естественного языка. Они способны выполнять широкий спектр задач, от перевода текста до создания сложных творческих произведений. Однако среди пользователей и специалистов возникает один важный вопрос: сколько инструкций могут одновременно обрабатывать большие языковые модели? Чтобы ответить на этот вопрос, необходимо сначала понять, что именно представляют собой большие языковые модели и как они функционируют. LLM основаны на архитектурах трансформеров и обучены на обширных корпусах текстовой информации. Они воспринимают входящий текст как последовательность токенов и на базе вероятностных расчетов генерируют ответы.

Каждая инструкция, которую получает модель, формулируется как запрос, чаще всего в текстовом виде, и модель исполняет ее согласно внутренним алгоритмам и ограничениям. Одним из ключевых факторов, влияющих на количество одновременно выполняемых инструкций, является концепция контекста. Модель способна воспринимать ограниченный объем информации за раз, какой называют "окно контекста". Размер этого окна варьируется в зависимости от конкретной модели — у современных решений он может достигать нескольких тысяч токенов. Это означает, что все инструкции и сопутствующая информация должны уместиться в это окно, чтобы быть обработанными одновременно.

Когда пользователю требуется, чтобы LLM одновременно выполняла несколько задач, например, отвечала на вопросы, переводила текст и выполняла суммирование, модель должна принимать все эти запросы в пределах одного контекстного окна. Если суммарный объем инструкций превышает размер окна, модель не сможет корректно обработать все запросы сразу, и часть информации будет потеряна. Это ограничивает практические возможности выполнения мультизадачности на уровне одного запроса. Еще один аспект — это внутренние вычислительные ресурсы модели. Большие языковые модели требуют значительных мощностей обработки, и параллельная работа с несколькими инструкциями внутри одного сеанса повышает нагрузку.

Современные облачные инфраструктуры и оптимизации позволяют обрабатывать множество отдельных запросов одновременно, но именно мультиинструкции внутри одного контекста модели ограничены техническими параметрами архитектуры. Интересно отметить, что разработчики моделей постоянно улучшают алгоритмы с целью расширения окна контекста и повышения эффективности интерпретации множества задач. Так, появляются модели с увеличенной длиной контекста, достигающей десятков тысяч токенов. Также эксперты исследуют методы контекстного сжатия и распределенного анализа, что в будущем позволит эффективно управлять большим количеством инструкций. Для конечного пользователя количество одновременно выполняемых LLM инструкций зависит от способа взаимодействия с моделью.

При использовании API обычно каждое задание отправляется как отдельный запрос, что позволяет платформам масштабировать работу и многозадачность. Однако в рамках одного запроса мультиинструкции ограничены возможностями окна контекста. Практическое применение таких моделей часто требует умения формулировать запросы максимально четко и компактно, чтобы уложиться в допустимый объем текста и получить высококачественный результат. Это особенно актуально для сложных проектов, где требуется комплексный анализ или выполнение серии взаимосвязанных инструкций. В целом, ответ на вопрос «Сколько инструкций может одновременно выполнять LLM?» нельзя выразить конкретным числом — он зависит от технологии, параметров модели, ее архитектуры и специфики запроса.