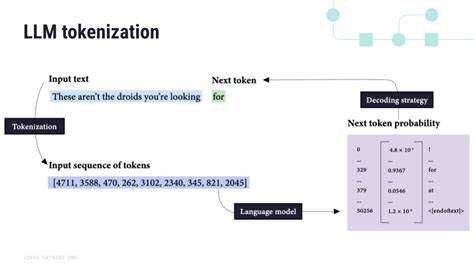

С развитием технологий больших языковых моделей (LLM) и их интеграции в веб-приложения возникает новая задача — сохранение состояния сессии генерации текстов, особенно потоков токенов, при обновлении страницы. Пользователи, взаимодействующие с такими моделями через браузер, часто сталкиваются с неудобствами, когда запущенный процесс генерации текста прерывается, и приходится начинать заново. В этой статье рассмотрим, почему сохранение токенов важно, с какими сложностями это связано и какие подходы позволяют реализовать устойчивую работу LLM в условиях обновления веб-страниц. Одной из ключевых проблем при обновлении страницы является потеря состояния JavaScript-приложения. Большинство рантаймов браузера сбрасываются, и динамические данные, загруженные в оперативную память, исчезают.

В случае, если генерация текста идет по токенам и занимает продолжительное время, невозможно воспроизвести прогресс без перезапуска процесса. Таким образом, пользователю приходится либо терпеть потерю сгенерированной части, либо предпринимать дополнительные действия для сохранения текстового результата. Сохранение состояния генерации — это, по сути, сохранение последовательности токенов, до которых дошла модель, а также внутреннего состояния модели, если он необходим для продолжения вывода. Однако в большинстве клиентских реализаций LLM не сохраняется глубинное состояние модели, а только получаемые токены, что усложняет возобновление процесса именно с того места, на котором он прервался. Решения для сохранения данных между обновлениями страницы пользуются различными возможностями браузера, такими как локальное хранилище (LocalStorage), IndexedDB, sessionStorage или кеширование через Service Worker.

Все эти методы позволяют сохранить строки текста или массивы токенов и извлекать их после перезагрузки. Проблема усложняется, когда токены передаются не сразу, а по потокам через WebSocket или SSE (Server-Sent Events), когда рассылка зависит от состояния сервера или сети. Если связь обрывается, восстановить сессию без дополнительной логики сервера проблематично. Практически важным подходом является сохранение уже полученных токенов на клиенте и периодическая синхронизация с сервером. Некоторые современные сервисы предлагают механизм возобновляемого потока, где сервер присваивает токенам индексы и в случае прерывания соединения клиент запрашивает с определенного индекса ранее сгенерированные токены.

Такой подход позволяет не терять прогресс и продолжать генерацию досрочно прерванных частей. Веб-разработка в контексте LLM также развивается в направлении вызовов через API с возвратом результатов не целиком, а частями, что создает предпосылки для реализации возобновления на уровне HTTP-запросов. Если предусмотрена концепция маркеров состояния или checkpoint, клиент может передавать серверу информацию о пройденных токенах, а сервер — продолжать генерацию с нужного фрагмента без необходимости полного повтора. Важную роль играет выбор архитектуры приложения. Состояние сессии, включая текущее положение потока токенов и метаданные, полезно хранить на сервере, а клиент — выступать лишь в роли отображения и передачи команд.

Такая модель упрощает управление сессиями и резервное копирование данных. На стороне клиента разработчикам стоит обратить внимание на использование возможностей современных браузеров по сохранению данных и ограничению излишнего потребления ресурсов. Кэширование промежуточных результатов и дебаунсинг обновления интерфейса снижают нагрузку и улучшают отзывчивость. Еще одной перспективной технологией являются прогрессивные веб-приложения (PWA), которые обеспечивают дополнительную устойчивость при нестабильном соединении и позволяют работать с оффлайн-режимом, что сказывается положительно на сохранении токенов и сессий LLM. Несмотря на все технические возможности, важным остается вопрос пользовательского опыта.

Необходимо продумать информирование пользователя о текущем прогрессе генерации, о возможности сохранить промежуточный результат вручную или автоматически. Это поможет снизить разочарование в случае прерывания и повысить лояльность к продукту. В целом, задача сохранения потоков токенов при обновлении страницы становится все более актуальной с ростом спроса на приложения с генеративным искусственным интеллектом. Технологии веб-разработки и инфраструктуры продолжают адаптироваться, предлагая удобные решения, которые делают взаимодействие с LLM более стабильным и комфортным. В будущем ожидается появление стандартов и библиотек, которые упростят реализацию возобновления генерации.

Кроме того, развитие серверных функций, позволяющих отделить ответственность за состояние от клиента, позволит создавать масштабируемые и надежные продукты. В итоге, сохраняя последовательности токенов и поддерживая их передачу между клиентом и сервером, разработчики формируют фундамент для эффективной работы с большими языковыми моделями в веб-среде. Эта тенденция способствует не только практической пользе, но и расширению горизонтов применения искусственного интеллекта в повседневных онлайн-сервисах.