Разработка и управление конвейерами данных - одна из ключевых задач современного программирования и аналитики. С ростом объёмов информации и повышением требований к параллельной обработке возникает необходимость в гибких и мощных инструментах, позволяющих эффективно организовать последовательность обработки данных. В этом контексте интересно рассмотреть экосистему Sparrow6 и язык программирования Rakulang (Raku), которые предлагают инновационные возможности для построения таких конвейеров. Sparrow6 представляет собой гибкий каркас, объединяющий задачи и скрипты, позволяющий работать с параллелизмом и вычислениями в кластере. Язык Rakulang служит связующим звеном, предоставляя выразительный и универсальный синтаксис для реализации бизнес-логики и скриптов.

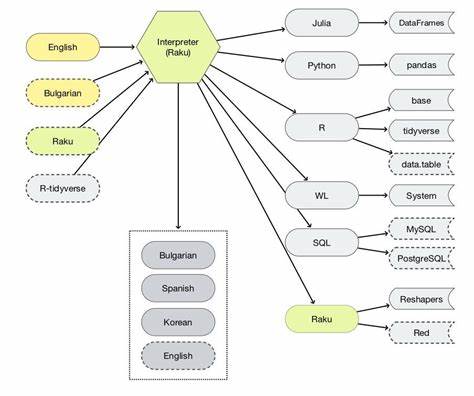

Вместе они формируют платформу, способную адаптироваться под разнообразные сценарии и требования. Главное преимущество использования Sparky и Rakulang - это поддержка любых языков программирования для выполнения отдельных этапов конвейера. Это означает, что для каждого процесса можно выбрать тот язык, который оптимально подходит по функционалу, производительности или удобству. Такой подход способствует более быстрой разработке и упрощает поддержку кода, поскольку логика скриптов отделена от основной управляющей программы. Примером можно привести конвейер из двух этапов: первый запускает скрипт на Perl, который генерирует массив рациональных чисел, второй - запускает Python-скрипт, который рассчитывает среднее значение по этим числам.

Между собой эти процессы обмениваются данными через механизм stash Sparky, в основе которого лежит передача состояния с помощью HTTP-протокола. Это обеспечивает прозрачную и надежную передачу информации между задачами, работающими в разных инстансах или даже на разных узлах кластера. Архитектура организации работы с задачами в Sparky предусматривает создание и использование объектов задания (job), которые могут инициировать другие задания с необходимыми параметрами. Такой подход позволяет реализовывать сложные сценарии, например, запуск дочерних задач, ожидание их завершения, использование рекурсии или оркестрацию рабочих процессов на основе различных паттернов. Это открывает широкие возможности для масштабируемости и повышения эффективности обработки данных.

Отдельного внимания заслуживает удобство отладки и поддержки кода. В отличие от некоторых других систем конвейеров, где скрипты могут быть встроены непосредственно в основной файл конфигурации, здесь они располагаются как самостоятельные файлы. Это значительно упрощает их тестирование и локальное исполнение без необходимости запускать весь конвейер целиком. Кроме того, механизм конфигурации переменных и передачи данных в Rakulang очень прост и интуитивен. Функция task-run выступает в роли основного интерфейса для запуска скриптов, она принимает пути к скриптам и входные данные в виде структурированных параметров, а возвращаемые значения напрямую интегрируются в состояние задания.

Такой подход улучшает читаемость и контроль над потоками данных внутри конвейера. Важным аспектом является параллелизм и использование высокопроизводительных вычислений (HPC). Sparky поддерживает запуск задач на кластере, что позволяет распределять нагрузку между различными вычислительными узлами. Это критично для проектов, где обработка больших объемов данных требует масштабирования без снижения скорости выполнения. Вложенная иерархия задач, а также возможность тегирования каждого этапа позволяют мониторить процесс выполнения конвейера в режиме реального времени через удобный веб-интерфейс.

Такая визуализация облегчает контроль, диагностику и оптимизацию рабочих потоков. Данный подход отлично подходит для биоинформатики, анализа данных, ETL-процессов и многих других сфер, где нужно сочетать гибкость разработки и мощь распределенных вычислений. Опыт показал, что даже портирование примера из популярного фреймворка Nextflow вполне возможно всего за час с использованием Sparky и Rakulang. В отличие от Nextflow, который применяет каналы для обмена данными между процессами, Sparky использует простые вызовы функций для передачи параметров между задачами, что повышает прозрачность и снижает вероятность ошибок. Удаленная работа с данными через HTTP упрощает синхронизацию и масштабирование.

Также Sparky поддерживает расширение функциональности с помощью плагинов Sparrow, что открывает новые возможности для распределенного запуска различных вычислений, интеграции с внешними сервисами и адаптации к специфическим требованиям проекта. В общем, использование Rakulang и Sparky для создания конвейеров данных - это современный и эффективный подход, сочетающий простоту использования, мощный инструментарий и масштабируемость. Применение таких технологий позволяет не только повысить производительность, но и повысить качество и надежность обработки данных, что крайне важно в эпоху больших данных и динамичного развития IT-индустрии. Разработка конвейеров с использованием этих инструментов предоставляет разработчикам гибкость выбора языков, упрощает поддержку скриптов и обеспечивает высокий уровень параллельности и распределения задач. Такой набор характеристик делает Rakulang и Sparky привлекательным решением для компаний и специалистов, стремящихся оптимизировать процессы обработки данных и вывести их на новый уровень эффективности.

Таким образом, экосистема Sparrow6 с языком Rakulang является перспективным решением для построения сложных, масштабируемых и удобных в эксплуатации конвейеров данных, способных удовлетворить самые разнообразные требования современных проектов в области анализа и обработки данных. .