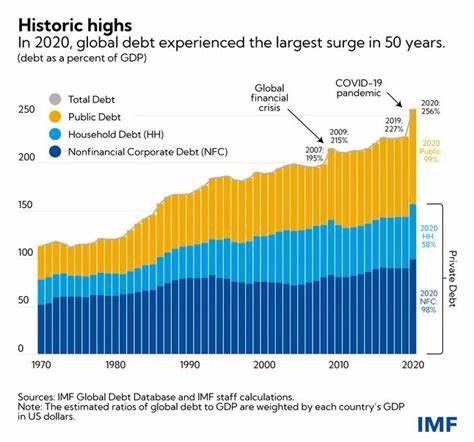

В современном цифровом мире технологии искусственного интеллекта (ИИ) стремительно меняют ландшафт бизнеса. AI-агенты становятся незаменимыми помощниками, ускоряя разработку программного обеспечения, автоматизируя обслуживание клиентов, а также интегрируясь в финансовые и управленческие процессы. Однако с ростом влияния AI возрастает и уровень риска, связанный с безопасностью. Многие организации напоминают передовые компании с новичками на ключевых позициях, предоставляющими доступ уровня root, но без должного контроля и управления. В результате безответственное обращение с AI-агентами становится уязвимостью, через которую злоумышленники могут получить доступ к важнейшим системам и информации.

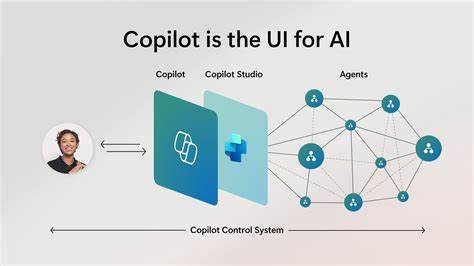

Одной из главных ошибок является попытка защитить AI-системы так же, как традиционные веб-приложения. Однако AI-агенты действуют как младшие сотрудники с серьезными привилегиями, что требует иного подхода — ориентированного на идентичность пользователей и устройств. Внедрение больших языковых моделей (LLM) и разнообразных AI-инструментов происходит с целью увеличения скорости и масштабируемости бизнес-процессов. Но каждый новый доступ к LLM либо API — это, по сути, новая точка идентификации, создающая дополнительные ворота для потенциальных атак. Возникает дилемма между созданием собственных AI-агентов, адаптированных под внутрикорпоративные нужды, и покупкой готовых коммерческих решений.

Однако выбор не снимает с компании обязанности обеспечить надежную защиту. Пользовательские AI-агенты расширяют внутреннюю поверхность атаки, особенно если отсутствует строгий контроль доступа и сегментация ролей. В то же время сторонние инструменты часто эксплуатируются без должного управления, нередко пользователи обращаются к ним с личных аккаунтов, создавая информационные пробелы и открывая риски несанкционированного доступа. Безопасность AI зависит не от особенностей алгоритма, а от того, кто или что взаимодействует с системой и какие полномочия получает. AI-агенты обладают способностью действовать от имени человека, выполняя операции, которые обычно доступны сотрудникам.

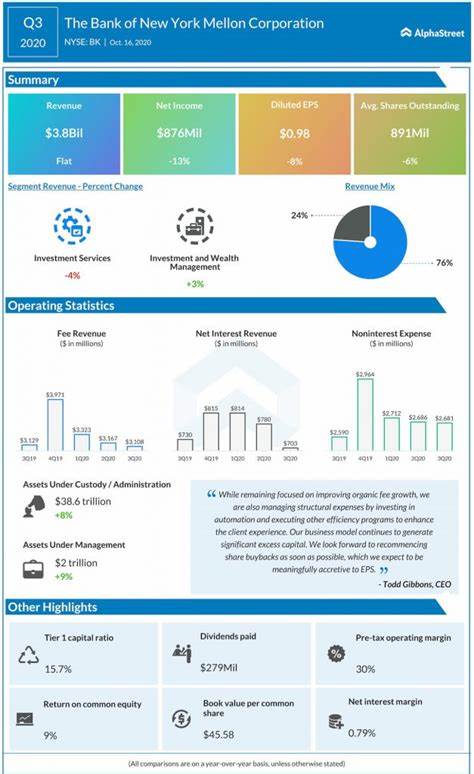

Они встраиваются в критически важные бизнес-приложения, такие как хранилища исходного кода, финансы и зарплатные системы, почтовые ящики, CRM и ERP платформы, а также службы поддержки клиентов. Если учетная запись пользователя или устройство оказывается скомпрометировано, AI-агент становится дверью для быстрого доступа к конфиденциальным данным и системам. Привилегированность таких систем увеличивает скорость и глубину потенциальных атак. Специфические угрозы для AI-систем включают атаки на идентичность, например, перебор паролей или захват сессий, направленные на LLM API, ошибки в конфигурации агентов с чрезмерными правами, а также слабую защиту сессий, когда зараженные устройства выполняют действия с повышенными привилегиями через AI. Для эффективности защиты необходимо внедрять многофакторную аутентификацию, устойчивую к фишингу, для каждого пользователя и устройства, имеющего доступ к API AI или уровню LLM.

Не менее важно реализовать точечное разграничение прав согласно ролям, чтобы, например, разработчики не имели доступа к финансовым моделям. Контроль состояния устройств с использованием современных сигналов безопасности EDR, MDM и ZTNA должен осуществляться постоянно и в реальном времени. Без таких мер контроль доступа к AI нельзя сводить к одноразовой проверке при входе. Необходимо создание механизмов, которые обеспечивают исполнение политики безопасности на основе текущих данных об идентичности и состоянии устройств. Среди ключевых подходов — отказ от совместного использования учетных данных и секретов, отсутствие слепой доверия к устройствам, исключение излишних прав у AI-агентов и сохранение производительности без дополнительных задержек.

Современные технологии позволяют выстроить архитектуру, в которой блокировка неавторизованного доступа осуществляется по умолчанию, устраняются предположения о доверии на всех уровнях, а рабочие процессы с AI остаются удобными и эффективными для законных пользователей. Такие инновационные решения уже реализует платформа Identity and Access Management (IAM) Beyond Identity. Она обеспечивает невозможность несанкционированного доступа благодаря использованию устойчивой к фишингу аутентификации, привязанной к устройству и с непрерывным контролем доступа. Платформа исключает пароли и общие секреты, блокируя риски, связанные с сомнительными или заражёнными устройствами. Beyond Identity также работает над безопасной архитектурой для корпоративных AI-агентов, где права агентов жестко связаны с подтвержденной личностью пользователя и состоянием его устройства.

Права доступа регулируются в реальном времени через механизмы RBAC, а система постоянно анализирует сигналы риска от решений по защите конечных точек (EDR), мобильного управления (MDM) и доступа с нулевым доверием (ZTNA). Для примера, если инженер утрачивает полные права на диск в CrowdStrike, AI-агент мгновенно блокирует доступ к чувствительной информации до момента восстановления безопасности. Такая практика позволяет гармонично сочетать безопасность и инновации, предотвращая угрозы без ущерба для скорости и производительности. Реальные кейсы компаний, уже внедривших подобные решения, доказывают, что надежный контроль над AI-агентами способствует не только защите корпоративных данных, но и улучшению бизнес-процессов. В эпоху, когда AI становится неотъемлемой частью корпоративного ландшафта, отказ от адаптации и недооценка рисков приведут к серьезным последствиям.

Организации должны смотреть на AI не только как на инструмент повышения эффективности, но и как на потенциальный вектор атак, требующий продуманного и комплексного подхода к безопасности. В конечном итоге ключ к успешной цифровой трансформации — создание зрелой системы безопасности, которая учитывает уникальные особенности AI-агентов и обеспечивает непрерывное управление идентичностью и состоянием устройств в реальном времени. Использование новейших технологий и архитектур уровня Beyond Identity позволит компаниям сохранить контроль над AI с минимальными рисками и максимальной отдачей.