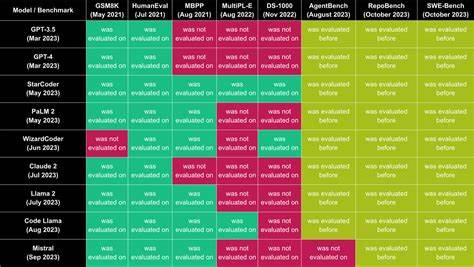

В эпоху стремительного развития искусственного интеллекта большую популярность приобрели большие языковые модели (LLM), которые нашли применение в самых разных сферах — от создания контента до автоматизации бизнес-процессов. Однако несмотря на возросшее количество провайдеров LLM, таких как OpenAI с ChatGPT, Claude от Anthropic и множество локальных или самохостинг-решений, вопрос объективной оценки их производительности и качества остается открытым. Для выбора оптимального API крайне важно иметь возможность не просто сравнивать функционал, но и измерять реальные показатели работы моделей в условиях, близких к боевым. В этом контексте появляется и приобретает популярность специальный инструмент — платформа для бенчмаркинга API больших языковых моделей, которая помогает всесторонне тестировать, анализировать и сравнивать производительность таких сервисов. Основная суть подобного инструмента — организация детальных тестов запросов к различным API и сбор метрик, демонстрирующих скорость отклика, качество генерации и стабильность работы.

Обычный пользователь, разработчик или исследователь может задать набор моделей, указать конкретные запросы в виде кастомных промптов, определить количество тестовых раундов и начать автоматический процесс оценки. При этом система фиксирует время до появления первого токена (Latency), скорость генерации текста (Throughput) и успех обработки запросов (Success Rate). Реальное измерение латентности критично для приложений, где важна оперативность ответов — например, в интерактивных чат-ботах или сервисах обработки документов в реальном времени. Скорость вывода токенов же отражает эффективность генерации и может значительно влиять на пользовательский опыт при работе с длинными ответами. Кроме того, показатель успешных запросов помогает оценить стабильность и надежность API в условиях нагрузок и разных типов запросов.

Инструмент предлагает удобный интерфейс, где можно быстро настроить протокол взаимодействия (REST, GraphQL и др.), указать URL API, добавить ключи доступа и перечислить необходимые модели для тестирования. Важной особенностью является возможность задавать собственные промпты, которые соответствуют конкретным задачам пользователя — будь то генерация маркетингового текста, помощь в программировании, диалог в стиле техподдержки или творческие сценарии. Тестирование проводится в несколько раундов, что позволяет получить усреднённые результаты и минимизировать влияние случайных факторов или кратковременных сбоев. Полученные данные визуализируются в режиме реального времени, что удобно для оперативного анализа и выявления потенциальных проблем — например, задержек или ошибок в ответах.

Статистика по каждой модели позволяет сравнивать их в плановом режиме, делая процесс выбора transparent и продуманным. Важным преимуществом инструмента является поддержка не только облачных API, но и локальных/самохостинг решений. Это актуально для организаций с особыми требованиями к безопасности, конфиденциальности данных или для разработки кастомных моделей на собственной инфраструктуре. Возможность масштабировать тесты и интегрировать результаты с внутренними метриками позволяет создавать комплексные оценки и оптимизировать использование LLM в бизнес-процессах. Современный рынок API больших языковых моделей чрезвычайно динамичен.

Новые провайдеры и модели появляются регулярно, часто предлагая уникальные возможности по снижению стоимости, повышению качества генерации или адаптации к специфическим задачам. Отслеживание и сравнение актуальных параметров работы становится залогом успешного внедрения ИИ-технологий. Кроме скорости и стабильности получение качественного результата генерации подразумевает также оценку релевантности, адекватности и творческого потенциала ответов, что в ряде случаев требует дополнительных пользовательских исследований. Применение рассматриваемого инструмента для бенчмаркинга позволяет не только упростить техническую часть сравнения, но и значительно сэкономить время и ресурсы на тестирование моделей вручную. Это важный аспект при организации масштабных проектов с использованием LLM, где ошибки при выборе API могут привести к значительным потерям в эффективности и бюджете.