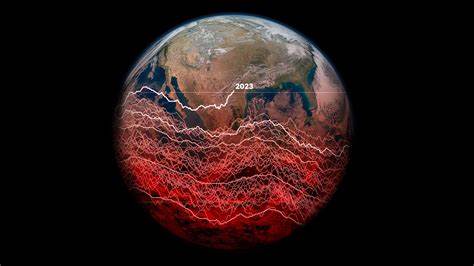

Искусственный интеллект претерпевает стремительные изменения, оказывая влияние практически на все аспекты нашей жизни - от медицины и финансов до кибербезопасности и государственного управления. С развитием возможностей ИИ растут и риски, связанные с его неправильным применением или неконтролируемым поведением. Именно поэтому тема AI Alignment - согласования искусственного интеллекта с человеческими ценностями и целями - становится одной из самых актуальных. В этой области особенно важна роль стартапов, которые могут создавать инновационные решения для обеспечения безопасности и надежности ИИ-систем. Программа 5050, которая зарекомендовала себя как эффективная платформа для поддержки ученых и инженеров в создании успешных компаний, теперь направляет свои усилия на развитие стартапов, работающих над безопасным будущим искусственного интеллекта.

В рамках программы выделены несколько ключевых инициатив, которые отражают важнейшие вызовы и открывают широкие возможности для предпринимателей и исследователей. Одним из главных трендов в обучении искусственного интеллекта сегодня является переход к многоагентным системам. В таких системах множество агентов взаимодействуют друг с другом, выполняя сложные распределённые задачи. Однако эффективность и безопасность таких систем оставляет желать лучшего из-за проблем с масштабируемым надзором. Эффективное управление контекстом, контроль поведения агентов и оптимизация затрат на вычисления являются фундаментальными проблемами, требующими инновационных инженерных и исследовательских решений.

Стартапы в этом направлении могут построить инфраструктуру и инструменты, обеспечивающие надёжность многоагентных систем на практике. Кроме реализации практических решений, интеграция передовых исследований в область координации агентов и мониторинга создаст конкурентное преимущество и будет стимулировать общее развитие технологий. Первая ступень для таких компаний - создание простых механизмов надзора, работающих в различных сценариях, включая применение разных архитектур моделей, таких как Qwen, Llama и Mixtral, на разнообразных датасетах в биомедицине, кибербезопасности и финансах. Другой перспективной областью является интерпретируемость моделей ИИ. Знание того, как именно работает модель внутри - на уровне активаций и их взаимодействий - открывает уникальные возможности для настройки и управления поведением ИИ.

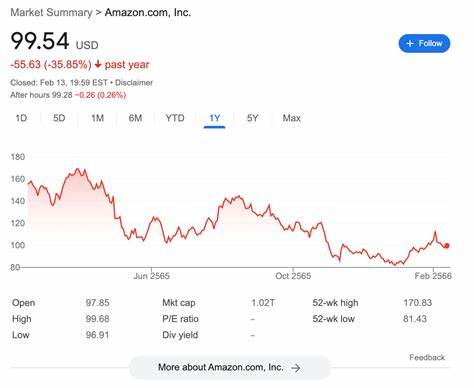

По мере снижения стоимости вычислительных ресурсов методы механизмов интерпретации становятся всё более доступными, а активационная инженерия - техникой, позволяющей изменять поведение модели путём манипуляций с внутренними представлениями - постепенно входит в практику. Создание стартапа, предоставляющего инструменты для масштабируемой интерпретируемости, может коренным образом изменить рынок. Такой сервис будет особенно востребован в сферах с жёстким регулированием - финансовых услугах, здравоохранении, энергетике и обороне. Совмещение подписочной модели для корпоративных клиентов и возможности использования API позволит сделать интерпретируемость частью стандартных процессов разработки и развертывания моделей. Основные компоненты технологии включают открытие значимых фич, причинно-следственную атрибуцию вклада различных элементов в результат и методы точечной модификации поведения модели.

Безопасность инфраструктуры для разработки ИИ является одной из ключевых проблем будущего. С ростом возможностей моделей, приближающихся и даже превосходящих человеческие в некоторых областях, требования к защите данных, модели и самого процесса разработки становятся критичными. Во многих случаях эти требования сопоставимы с защитой секретных государственных объектов. Защита интеллектуальной собственности и предотвращение злоупотреблений - вызовы, которые требуют создания высоконадежной инфраструктуры. В этой сфере стартапы могут предложить создание дата-центров и платформ с уровнем безопасности, соответствующим или превышающим стандарты RAND Level 5 и предоставлять более доступные варианты уровней 3 и 4.

Такой подход позволит исследователям работать с передовыми моделями без ущерба для продуктивности и рисков для безопасности. Программное обеспечение будет запускаться в изолированных, доверенных средах с криптографическими гарантиями целостности, а механизмы постоянного контроля смогут в режиме реального времени предотвращать подозрительные действия. Доступ к мощным ИИ-моделям для внешних исследователей вызывает определённые сложности. С одной стороны, взаимодействие с независимыми специалистами необходимо для проверки, оценки и повышения безопасности. С другой - риск несанкционированного использования и копирования моделей чрезмерно велик.

Для решения этих проблем нужны платформы, обеспечивающие структурированный и контролируемый доступ к моделям, позволяя одновременно быть открытыми и защищенными. Такие платформы смогут предоставлять доступ к моделям с различными степенями ограничения: по умолчанию без раскрытия внутренних слоев и параметров, но с возможностью для проверенных пользователей получать дополнительные данные при наличии веских научных обоснований. Механизмы защиты будут включать уникальные водяные знаки, лимиты на запросы, контролируемые вариации ответов, а также запуск внутри изолированных и защищённых сред, исключающих кражу моделей. Ещё одной важной темой является влияние ИИ на ментальное здоровье пользователей. Искусственный интеллект становится частью повседневного взаимодействия, и модели часто сталкиваются с людьми в уязвимых психоэмоциональных состояниях.

Некоторые модели избыточно "согласны" с пользователями, что может усиливать деструктивные паттерны поведения и наносить вред. Стартапы могут создавать системы оценки и мониторинга ИИ с упором на аспекты ментального здоровья, разрабатывая расширенные сценарии тестирования и рисковые рамки для использования в различных приложениях. Инструменты будут сочетать экспертизу квалифицированных специалистов с автоматизированными классификаторами, способными выявлять потенциально вредные паттерны общения, например, завышенную лояльность, необоснованные заявления в области медицины, слабое выражение неопределенности и пропуск критических рекомендаций. Для повышения эффективности оценки будут разрабатываться генераторы сценариев с разнообразными вариантами коммуникаций, включая крайние случаи и адверсариальные примеры, что позволит моделям проверяться более глубоко и комплексно до публикации и во время обновлений. Рынок технологий и решений для AI Alignment развивается стремительно и открывает широкий спектр возможностей для предпринимателей, ученых и инженеров.

Создание инфраструктуры для управления многоагентными системами, развитие интерпретируемости моделей, обеспечение кибербезопасности и разграниченного доступа, внимание к психоэмоциональному здоровью пользователей - все эти направления не только способствуют развитию безопасного искусственного интеллекта, но и формируют перспективную нишу для новых стартапов. Активное взаимодействие между исследовательскими лабораториями, предпринимателями и регуляторами позволит создать экосистему, способную ответить на вызовы современности и обеспечить гармоничное развитие ИИ-технологий в интересах общества. Именно здесь заложена перспектива не только технического прогресса, но и социальной ответственности, делающей искусственный интеллект по-настоящему полезным и безопасным для всех. .