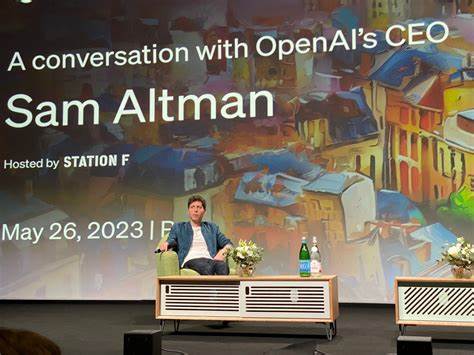

В современном мире искусственный интеллект становится все более интегрированным в повседневную жизнь, предлагая новые возможности от автоматизации задач до индивидуальной поддержки пользователей. Одним из наиболее популярных и обсуждаемых применений является использование таких ИИ-систем, как ChatGPT, в качестве виртуального терапевта или психологического консультанта. Однако недавно глава OpenAI Сам Альтман выступил с тревожным предупреждением: при общении с ChatGPT отсутствует юридическая конфиденциальность, что несет серьезные риски для пользователей. Эта тема приобретает особую актуальность в свете роста популярности ИИ и важных вопросов защиты персональных данных и приватности в цифровом пространстве. Сам Альтман, будучи главным исполнительным директором OpenAI, высказался в одном из последних интервью, где затронул проблему отсутствия для пользователей, обращающихся к ChatGPT за психологической поддержкой, юридической защиты их личных разговоров.

В отличие от традиционных терапевтов, которые подчиняются строгим этическим нормам и законам о сохранении врачебной тайны, разговоры с ИИ не имеют никакой такой гарантии. Это означает, что информация, которую пользователи делятся с виртуальным помощником, может быть использована в судебных разбирательствах или оказаться доступной третьим лицам согласно требованиям законодательства. Стоит подчеркнуть, что этот вопрос далеко не гипотетический. На данный момент в ряде юридических дел компаниям технологической сферы уже приходилось предоставлять данные диалогов пользователей. Открытую борьбу в судах ведет и сама OpenAI, которая пытается оспорить любопытные постановления с требованием передавать сотни миллионов чатов пользователей.

Такая практика вызывает справедливое беспокойство в сообществе, ведь данные, которыми мы делимся с цифровыми сервисами, зачастую бывают глубоко личными, затрагивая интимные и психологические сферы жизни. Использование ChatGPT в роли терапевта или лайф-коуча особенно популярно среди молодежи, которая часто предпочитает анонимное и доступное решение для поиска советов и поддержки по вопросам семьи, отношений и психологического состояния. Это связано с тем, что ИИ может оперативно отвечать на сложные вопросы, предлагать варианты решения конфликтов и предоставлять эмоциональную поддержку. Несмотря на очевидные преимущества, отсутствие этической и юридической базы для подобных взаимодействий делает использование такого сервиса потенциально опасным. Еще одной важной тенденцией, которую указал Сам Альтман, является отсутствие пока четкой законодательной базы по вопросам конфиденциальности в отношении ИИ-консультаций.

В то время как традиционная медицина и юриспруденция обладают давно установленными нормами, регулирующими защиту личных данных и врачебную тайну, искусственный интеллект функционирует в правовом вакууме. Это создает существенный разрыв между безопасностью пользователей при обращении к живым специалистам и виртуальным помощникам. Компания OpenAI осознает эту проблему и публично заявляет о намерениях добиваться создания специальных стандартов и правовой защиты, сопоставимых с существующими формами врачебной или юридической тайны. Альтман подчеркивает, что частичное решение вопроса конфиденциальности и приватности может стать ключом к более массовому и безопасному использованию ИИ-технологий, что в конечном итоге принесет обществу большую пользу. Однако помимо юридических аспектов существует и технический вызов.

В процессе обучения и функционирования ИИ требуется огромное количество данных, часть из которых формируется за счет пользовательских запросов. Даже если компании стремятся к совершенствованию систем анонимизации и шифрования, полная гарантия того, что личная информация не будет раскрыта, пока отсутствует. В случае постановления суда или иного официального запроса, организации вынуждены передавать требуемые сведения, что фактически нивелирует усилия по защите конфиденциальности. Проблему усложняет и тот факт, что разговоры с ChatGPT не регулируются стандартами медицинской или психологической практики. Психологи и терапевты проходят множество сертификаций и обязаны соблюдать этические кодексы, включая запрет на разглашение личной информации своих пациентов без их согласия.

ИИ-системы же не имеют человеческого понимания контекста и моральных обязательств, а их разработчики — компании — действуют в рамках существующего законодательства, которое не успевает за развитием технологий. В свете вышесказанного пользователям стоит критически подходить к выбору ИИ в качестве инструмента личной поддержки. Хотя ChatGPT и другие подобные платформы предлагают удобный и зачастую полезный интерфейс для общения, особенности работы и отсутствие юридической гарантии конфиденциальности означают, что делиться с ними глубоко личной и чувствительной информацией следует крайне осторожно. Многие эксперты отмечают, что для полноценного и безопасного внедрения ИИ в сферу психического здоровья необходимо разработать специальное законодательство и создать надежные стандарты конфиденциальности. Возможно, будущее за новыми правовыми нормами, которые признают виртуального помощника в определенной роли, схожей с живыми терапевтами, с соответствующими обязательствами по защите данных.

Только в этом случае можно рассчитывать на доверие пользователей и на широкое применение таких технологий. Наблюдая за тем, как технологии стремительно меняют привычные роли и функции, важно помнить о балансе между инновациями и защитой прав человека. Сам Альтман и OpenAI делают шаги в направлении привлечения внимания к пробелам в законодательстве и этике, но реальное изменение потребует времени, усилий и совместной работы технологических компаний, юристов, законодательных органов и общества. Таким образом, предупреждение Сэма Альтмана служит важным напоминанием: несмотря на удобство и доступность общения с ИИ по вопросам личного характера, сегодня отсутствует юридическая защита, гарантирующая конфиденциальность таких разговоров. Пользователям рекомендуется внимательно оценивать риски и сохранять осмотрительность, в особенности при обсуждении чувствительной информации.

Технологии стремительно развиваются, и, вероятно, вскоре появятся новые решения по защите данных, способные обеспечить необходимый уровень приватности в диалогах с искусственным интеллектом.