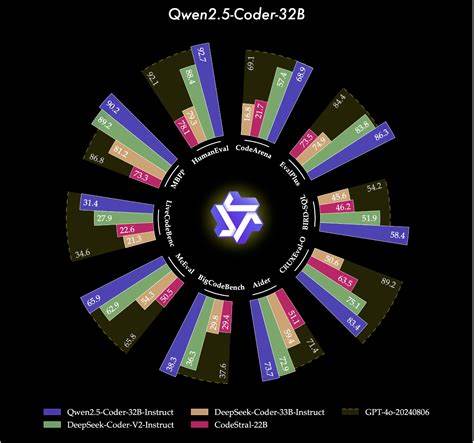

В современном мире высокопроизводительных вычислений и глубокого обучения эффективное использование графических процессоров (GPU) становится важнейшим аспектом разработки программного обеспечения. Чтобы максимально раскрыть потенциал GPU, необходимо создавать оптимизированные ядра, способные выполнять вычисления с высокой скоростью и малой задержкой. Однако написание таких ядер вручную требует глубокого понимания архитектуры GPU и специфики низкоуровневых языков программирования, что значительно замедляет разработку и увеличивает вероятность ошибок. В этом контексте появление моделей типа Qwen2.5-Coder-3B, специально дообученных для трансформации кода на PyTorch в ядра Triton, является революционным шагом на пути к автоматизации и упрощению процесса разработки высокопроизводительных вычислительных модулей.

Qwen2.5-Coder-3B — это крупномасштабная языковая модель с 3 миллиардами параметров, созданная на основе архитектуры трансформеров с использованием современных техник, таких как RoPE, SwiGLU и RMSNorm. Главная особенность этой модели состоит в ее адаптации к задаче генерации кода, а именно — преобразования PyTorch nn.Module в эффективный код на Triton, специализированный языке программирования для GPU. Модель была дополнительно обучена на уникальном датасете GPUMODE/KernelBook, содержащем свыше 18 тысяч пар эквивалентных фрагментов кода: исходных на PyTorch и соответствующих им на языке Triton.

Эти пары были созданы с помощью torch.compile, что гарантирует корректность и оптимальность преобразования, а также содержит полезную метаинформацию. Благодаря такому обучению Qwen2.5-Coder-3B эффективно изучила закономерности в том, как определённые операции в PyTorch могут быть преобразованы в низкоуровневые, слияние вычислений и оптимизации, характерные для Triton-кода. Это позволяет автоматически генерировать ядра, способные работать с высокой производительностью и эффективно использовать ресурсы GPU.

Обучение модели проходило на платформе PyTorch 2.5.0 с помощью современных библиотек Transformers, PEFT и TRL с использованием Low-Rank Adaptation (LoRA). LoRA — это метод дообучения, позволяющий подстраивать большие модели с минимальными вычислительными затратами и потреблением памяти, что обеспечивает быстрый и эффективный процесс обучения даже на ограниченном оборудовании. Для обучения было использовано одно графическое ускорение NVIDIA H100 80GB, с применением сжатия вычислений в формате bfloat16, что позволило достичь высоких скоростей без значительной потери точности.

Результаты обучения впечатляют: средняя точность предсказания токенов составила более 98 процентов, а финальная потеря была минимальной. Это доказывает, что модель надёжно захватывает и воспроизводит логику преобразования кода. Среди ключевых параметров обучения можно отметить использование градиентного аккумулятора для эффективной обработки партий данных, а также современный оптимизатор AdamW, оптимизированный для высокопроизводительных вычислений. Такая архитектура и подход обеспечивают стабильность и качество генерации кода, что делает модель готовой к практическому применению. Применение Qwen2.

5-Coder-3B особенно актуально в разработке кастомных ядров для нейросетей и других вычислительных задач, где требуется высокая степень контроля над процессом исполнения и оптимизацией параллельных вычислений. Специалисты могут предоставлять на вход модели PyTorch-код, описывающий их вычислительную логику, после чего получать автоматически сформированный Triton-код — эффективное ядро для ускоренной обработки. Такой подход экономит время, сокращает необходимость в глубоких знаниях низкоуровневого программирования GPU и минимизирует риски ошибок, связанных с ручной оптимизацией. Дополнительно, благодаря открытости и публикации модели на платформе Hugging Face, интеграция и использование Qwen2.5-Coder-3B доступно широкому кругу разработчиков и исследователей.

Простые инструкции по установке и примеры использования позволяют быстро начать генерацию качественных Triton-кернелов, что особенно важно для стартапов и команд, ориентированных на инновации в области искусственного интеллекта и высокопроизводительных вычислений. Тесная связь модели с датасетом KernelBook указывает на актуальность и практическую ценность созданных данных. Сам датасет собран с большим трудом: авторы извлекали PyTorch проекты, изолировали сложные модули и с помощью torch.compile создавали оптимизированные эквиваленты на языке Triton, что отражает реальный индустриальный уровень кода. Это придаёт результатам обучения максимальное соответствие требованиям современного программирования GPU.

Внедрение Qwen2.5-Coder-3B и подобных систем способно не только упростить рутинные задачи в области оптимизации кода, но и открыть новые горизонты для исследований в области автоматического рефакторинга, компиляции и генерации параллельных алгоритмов. Появляется возможность масштабировать высокопроизводительные вычисления, предоставляя разработчикам умные инструменты для быстрого прототипирования и отладки. Такой подход соответствует тенденциям развития индустрии, где искусственный интеллект всё глубже интегрируется в процесс создания программного обеспечения. Помимо технических преимуществ, модель несёт и образовательную ценность, позволяя изучающим и практикам видеть примеры качественного преобразования кода между уровнями абстракции.

![EA and Battlefield 6 Drop Godot Bombshell [video]](/images/E03A6D4D-58D2-4905-80DF-1274BDEBB3D9)