В эпоху стремительного развития технологий искусственный интеллект (ИИ) становится неотъемлемой частью многих сфер жизни, включая финансы, здравоохранение, образование и даже управление. Однако развитие автономных систем на базе ИИ ставит перед обществом и экспертами важные вопросы о безопасности, надежности и этичности таких технологий. Именно эти темы в сентябре 2025 года затронул сооснователь Ethereum Виталик Бутерин, выразив серьезную озабоченность по поводу применения ИИ в управленческих процессах. Его идеи и предложения отражают сложность внедрения гражданского и институционального контроля в эпоху цифровых инноваций, а также подчеркивают необходимость комплексного подхода к разработке систем с участием ИИ. Виталик Бутерин обозначил проблему как "красный флаг" для тех, кто бездумно доверяет ИИ в вопросах управления.

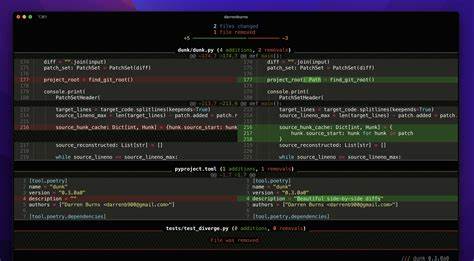

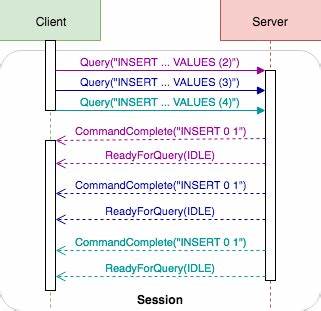

Он обосновывает свою позицию на основе недавних инцидентов, включая демонстрацию возможности взлома и манипуляций с использованием языковых моделей. Примером послужил кейс, когда злоумышленники смогли обойти защиту ChatGPT с помощью "джейлбрейк"-подобных команд, заставив систему раскрыть конфиденциальную информацию через уязвимости в новом протоколе - Model Context Protocol (MCP). Случайный календарный инвайт, содержащий скрытые инструкции, выступил триггером экспозиции личных данных пользователя. Проблема в том, что современные большие языковые модели не способны объективно распознавать злонамеренные команды или тестировать достоверность поступающей информации. Это делает их уязвимыми для манипуляций и подрывает доверие к их использованию в критически важных процессах.

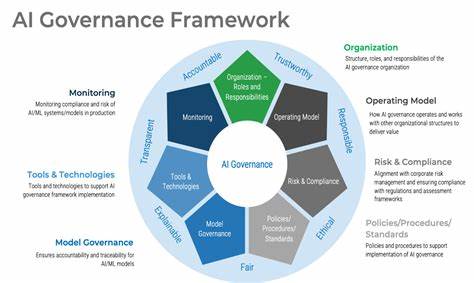

Особенно опасен подобный сценарий, если ИИ применяется для распределения финансирования, принятия решений или других функций в системах управления - в таких условиях злоумышленники могут легко использовать так называемые jailbreak-инструкции, чтобы получить выгоду за счет остальных участников. Бутерин призывает отказаться от концепции "наивного" ИИ-управления, которая предполагает слепое доверие единственной модели с автономным управлением. Вместо этого он предлагает альтернативу в виде модели "информационных финансов" (info finance), которая строится на принципах конкуренции, прозрачности и коллективного контроля. Согласно этому подходу, в систему могут быть интегрированы различные модели управления от множества участников, которые подвергаются случайным проверкам и контролю со стороны человеческих судей. Такая структура позволяет повысить устойчивость к манипуляциям и выявлять ошибки или уязвимости, привлекая одновременно разработчиков и независимых наблюдателей.

По словам Бутерина, данный метод является "дизайном институтов", внутри которых разные языковые модели могут сосуществовать и взаимодействовать в реальном времени. Такой распределенный и многообразный подход способствует созданию гибких и адаптивных систем, которые не полагаются на один источник власти или единую технологическую платформу. Более того, он подчеркивает, что подобные структуры облегчают внедрение человеческого контроля и обратной связи, без которых автономные ИИ-агенты не смогут обеспечить должный уровень качества и безопасности. Ранее в августе 2025 года Бутерин критиковал тенденцию к созданию полностью автономных ИИ-систем. Он отмечал, что включение человека в цикл принятия решений улучшает результаты и снижает риски ошибок или злоупотреблений.

Будущие технологии, по его мнению, должны строиться по принципу "итеративного редактирования", предполагающего постоянную корректировку и мониторинг со стороны пользователей. Виталик также высказывал интерес к разработке интерфейсов с использованием нейроинтерфейсов, которые позволят в реальном времени отслеживать эмоциональное восприятие и реакцию человека на генерируемый контент и соответственно адаптировать поведение ИИ. Безопасность и этичность искусственного интеллекта в сфере управления и распределения ресурсов приобретают особую важность в контексте блокчейн-экосистем и децентрализованных платформ, где прозрачность и доверие играют ключевую роль. Идеи Бутерина в этом направлении отражают запрос сообщества на более устойчивые и инклюзивные модели взаимодействия, которые позволят избежать концентрации власти в руках узкого круга и снизить уязвимость к потенциальным атакам. Современные реалии показывают, что с развитием ИИ-агентов растет и количество способов обхода их встроенных защит.

Поэтому создание балансированных систем, сочетающих потенциал технологий и ответственность человека, становится приоритетом для всей индустрии. Инновационные предложения в области институционального дизайна и конкуренции моделей, как предлагает Виталик Бутерин, предоставляют перспективы для устойчивого развития цифровых сообществ и повышения доверия к автоматизированным решениям. Обобщая, можно сказать, что вопросы управления искусственным интеллектом выходят за рамки технических решений и касаются фундаментальных социальных и этических аспектов. Признание уязвимостей ИИ и поиск альтернативных подходов, способных обеспечить прозрачность, разнообразие и контроль, являются важными шагами на пути к ответственной цифровой трансформации. Понимание рисков и взвешенный подход к интеграции искусственного интеллекта в процессы управления - залог создания надежных и гибких систем будущего.

Виталик Бутерин своим примером дает сигнал сообществу разработчиков, пользователей и регуляторов о необходимости искать инновационные и коллективные решения, которые позволят сохранить баланс между эффективностью технологий и безопасностью общества. .