Kubernetes давно стал стандартом для оркестрации контейнеров в мире IT, предоставляя мощный и гибкий инструментарий для управления распределёнными приложениями. Однако с ростом популярности AI/ML нагрузок, которые требуют специализированного аппаратного обеспечения, такого как GPU и другие ускорители, управления сбоями в подах с устройствами стало гораздо сложнее. Это связано с рядом специфических особенностей таких рабочих нагрузок и с тем, как Kubernetes сегодня обращается с устройствами внутри кластера. Развитие AI и машинного обучения кардинально изменило требования к инфраструктуре. В отличие от традиционных веб-сервисов, AI/ML приложения полагаются на специализированные устройства, которые часто дорогостоящие, ограничены в количестве и требуют особенного подхода к выделению и мониторингу ресурсов.

Отказ одного устройства, например GPU, может привести к сбою всего процесса обучения, что чревато большим простоем и дополнительными затратами. В традиционном Kubernetes система ресурсов очень статична: ресурсы либо доступны, либо нет, и предполагается, что они будут работать корректно на протяжении всего времени. Такая модель не учитывает частичные отказы оборудования или деградацию производительности, что становится серьезной проблемой в современных кластерах с AI/ML нагрузками. Кроме того, существуют различия в типах AI/ML нагрузок, которые накладывают дополнительные требования к управлению подами. Обучение моделей (training) часто происходит большими «группами» подов, потребляющих значительные ресурсы и работающих длительное время — от нескольких дней до месяцев.

При этом сбой одного из них может привести к Restart всех подов в кластере, что дорогостоящая и сложная операция. В то же время, нагрузка инференс (inference) обычно долгосрочная, может распределяться по разным узлам и подразумевает работу с меньшими частями оборудования, но при этом требует высокой стабильности и доступности. Текущие механизмы Kubernetes для обработки сбоя устройств достаточно ограничены. Устройство считается либо доступным, либо недоступным, на основе данных от device plugin. При отказе устройства Kubernetes не имеет встроенных средств для его диагностики или автоматической замены, чаще всего ограничиваясь перезапуском пода, что далеко не всегда эффективно или достаточно.

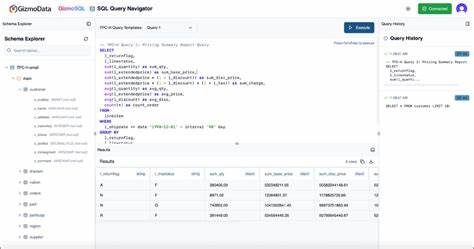

В результате, разработчики и операторы создают кастомные решения для обработки таких сбоев. Один из подходов — это использование health controller, который следит за состоянием устройства и запускает перезагрузку ноды, если обнаруживается рассогласование между доступными и заявленными ресурсами. Впрочем, этот метод не учитывает важность конкретных устройств для отдельных подов или всего кластера и может привести к неоправданным перезапускам. Другим методом является введение в под специальные коды ошибок при сбое устройства. Под по результатам такой ошибки завершает свое выполнение, и механизм Pod Failure Policy применяет соответствующую стратегию обработки.

Несмотря на достоинства, этот подход ограничен только типом workload, например, работает только с Jobs и определёнными restartPolicy, что снижает универсальность. Дополнительно, существует практика разработки кастомных pod watcher’ов — служб, которые отслеживают состояние подов и связанных с ними устройств. В случае обнаружения неисправного девайса, такой watcher удаляет под, после чего ReplicaSet автоматически создаёт новый на исправном оборудовании. Этот способ подходит для инференс нагрузок, но требует значительных привилегий и сложной интеграции. Все перечисленные методы — это больше обходные пути, строительство «на сверху» текущей модели Kubernetes, которая изначально не рассчитана на подобные кейсы.

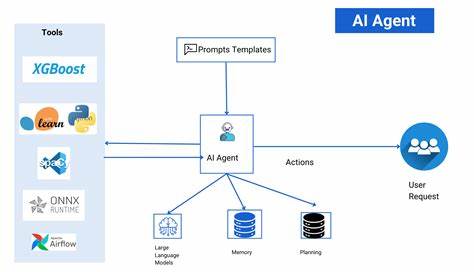

Далее в развитии лежит задача расширения возможностей самой платформы, чтобы она могла предоставлять более гибкие и надежные средства для диагностики и управления устройствами внутри кластера. Одна из ключевых инициатив — это развитие Device Resource API (DRA), которая в последних версиях Kubernetes уже начинает предоставлять более глубокую информацию о состоянии устройств. Добавление статуса здоровья ресурсов в Pod Status — важный шаг к тому, чтобы Kubernetes мог воспринимать не только наличие ресурса, но и его качество и состояние. Также рассматриваются возможности интеграции обработки отказов устройств непосредственно в Pod Failure Policy, что позволит задавать более точные стратегии для перезапуска в зависимости от типа ошибки. Обработка отказов контейнерного кода также требует особого внимания.

AI/ML нагрузки часто требуют синхронизированного перезапуска нескольких подов, что в настоящий момент сложно реализовать на уровне стандартных Kubernetes средств. Ручные и кастомные решения позволяют обойти это, но зачастую они хрупки и требуют значительных усилий по сопровождению. Развитие расширений для локального рестарта контейнеров, возможности перезапуска подов без перевыделения ресурсов и более интеллектуального планировщика будут способствовать снижению стоимости и повышению устойчивости больших тренировочных задач. Особое внимание следует уделить проблеме деградации устройств. На сегодняшний день системы мониторинга и Kubernetes не имеют встроенного понятия «сниженной производительности» устройств, что затрудняет своевременное выявление и коррекцию подобных ситуаций.

Часто такие проблемы диагностируются по косвенным признакам — снижению скорости тренировки или появлению ошибок в логах. В дальнейшем стоит ожидать появление стандартных метрик и индикаторов для оценки состояния устройств, а также инструментария для их лечения и замены. Важным аспектом в управлении устройствами является обеспечение совместимости драйверов и приложений. Несовместимость или неверно подобранные версии драйверов могут привести к тяжелым сбоям, влияющим на все рабочие процессы. Для минимизации рисков рекомендуется тщательно контролировать состояние и обновления драйверов, тестировать совместимость и проводить постепенное развертывание обновлений с использованием canary-подхода.

Kubernetes, как платформа с развитой экосистемой и большим сообществом, несмотря на своё преимущество, сталкивается с вызовами в сфере расширенного управления устройствами. Однако работа SIG Node и других групп внесёт значительный вклад в решение этих проблем. Улучшение надежности коммуникаций между device plugin и kubelet, интеграция расширенной информации о состоянии устройств, а также разработка новых политик обработки ошибок позволят значительно повысить устойчивость AI/ML рабочих нагрузок. В заключение можно отметить, что успешное управление отказами в подах с устройствами — это комплексная задача, требующая согласованных усилий инфраструктурных компонентов, эксплуатационных процедур и приложений. Постепенное эволюционное развитие Kubernetes с учётом специфики AI/ML позволит сохранить его лидерство и адаптировать к требованиям новых высокопроизводительных вычислений.

Прогресс в этой области неразрывно связан с развитием сообщества, обменом опытом и обратной связью от пользователей, внедрением новых стандартов и расширением набора инструментов. Чем лучше будет понимание характерных паттернов ошибок и потребностей AI/ML нагрузок, тем точнее и эффективнее станут решения по управлению устройствами. Это позволит организациям оптимизировать ресурсы, снизить потери и обеспечить стабильную работу критически важных приложений в условиях быстро меняющегося технологического ландшафта.