В последние годы искусственный интеллект, и в частности генеративные модели на основе больших языковых моделей, вызвали огромный интерес как у пользователей, так и у компаний. Обещания повышения производительности, автоматизация творческих процессов и помощь в решении сложных задач сделали такие системы популярными и востребованными. Однако за впечатляющей способностью генерировать связные тексты и отвечать на широкий спектр вопросов скрывается серьезная проблема: ненадежность и частые ошибки, называемые «галлюцинациями». Почему же даже самые современные ИИ-системы, поддерживаемые миллиардными инвестициями крупнейших технологических компаний, продолжают выдавать неправду, и что это значит для их будущего? Под понятием «галлюцинации» в контексте искусственного интеллекта понимаются ошибки, когда генеративная модель создает информацию, не соответствующую реальности, порой яркую и убедительную, но ложную. Так, бывают случаи, когда ИИ предоставляет вымысленные цитаты, неверные биографические данные или иллюстрирует запрос несуществующей информацией.

Это не просто случайные казусы — такие ошибки систематически проявляются в работе современных моделей, что порождает угрозу доверия к технологиям и ставит под сомнение использование ИИ в ответственных сферах. Причиной таких проблем является фундаментальная разница между тем, как устроены генеративные языковые модели, и традиционным подходом, основанным на алгоритмических вычислениях и символических методах. Классический искусственный интеллект работал на основе заданных правил, логики и четких вычислений. Например, алгоритм мог просчитать кратчайший путь, исходя из множества альтернатив, и предоставить точное решение. Современный же генеративный ИИ не работает с истиной напрямую — он построен на предсказании следующего слова или символа, исходя из анализа огромного массива текстов, доступных в интернете.

Такая модель не «знает» правды — она просто пытается воспроизвести наиболее вероятные последовательности слов, основанные на шаблонах, обнаруженных в данных. Отсюда возникает разница между правдой как точным знанием и вероятностью звучания информации, которая может быть расслабленной или фантазийной. Когда система говорит, например, что известный актер Гарри Ширер — британец, а не американец, она генерирует вероятностный ответ, который может казаться смелым, но не отражает реальной биографии человека. Еще одна причина неисправностей — низкое качество обучающих данных. Интернет, который служит основным источником информации для тренировки ИИ, содержит миллиарды фальшивых новостей, сатирических высказываний, субъективных мнений и просто заведомо ложной информации.

При этом генеративный ИИ не может отфильтровывать правдивое содержимое от недостоверного, а лишь воспринимает все как равноценный материал для обучения. Более того, он может сам производить и распространять дезинформацию, способствуя дальнейшему «загрязнению» обучающих выборок. Отсутствие способности понимать контекст на более глубоком уровне, включая юмор, сарказм и иронию, также влияет на способность ИИ формировать корректные ответы. Примеры из практики иллюстрируют, как ИИ может «советовать» есть камни по рекомендации сатирического источника или создавать полностью неверные карты с географическими ошибками. Это значит, что алгоритм не обладает механизмами проверки фактов и не может критически оценить содержание, которое воспроизводит.

С одной стороны, публичный интерес и популярность чатботов и генеративных систем растут, с другой — эксперты признают фундаментальные ограничения нынешних технологий. Технологии строятся вокруг статистики и вероятностей вместо истинно символического мышления и логики. Этот разрыв между «приближением» к реальности и осознанным поиском правды создает основу для хронической ненадежности. Психологи и исследователи, среди которых профессор Гэри Маркус, указывают на так называемый «разрыв доверчивости», когда пользователи склонны приписывать ИИ большую интеллектуальность и сознание, чем он фактически обладает. Подобная гиператрибуция ведет к неправильному восприятию ответа искусственного интеллекта как достоверного источника без критической оценки.

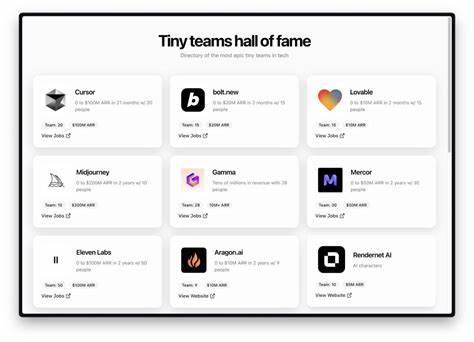

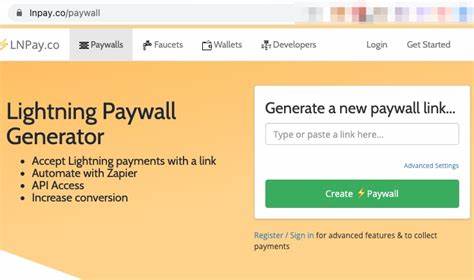

Это опасно, особенно в профессиональных сферах — медицине, юриспруденции, образовании — где ошибки могут привести к серьёзным последствиям. Для преодоления кризиса надежности необходим и другой инженерный подход к развитию ИИ — не просто увеличение размеров моделей и объема данных, а интеграция символьных методов, логических рассуждений и механизмов проверок фактов. Это позволит обеспечивать воспроизводимость истины, а не только правдоподобие. Кроме того, важно развитие специализированных баз данных, структурированных знаний и более высоких стандартов подготовки данных. В ближайшем будущем мы можем ожидать, что появятся гибридные системы, совмещающие силу генеративного языка с особенностями классического ИИ, способные критически оценивать и корректировать собственные ответы.

Это помогло бы снизить количество галлюцинаций и повысить доверие к технологиям. Однако, как отмечают эксперты, полностью избавиться от неточностей на основе существующих архитектур невозможно — нужна принципиально новая парадигма искусственного интеллекта. Пока технологии развиваются, пользователям нужно оставаться внимательными и критично относиться к информации, полученной от ИИ. Понимание ограничений и природы генеративных моделей поможет эффективно использовать их преимущества, не подвергаясь риску дезинформации. Таким образом, кризис надежности генеративного искусственного интеллекта — это не просто недостаток, а отражение фундаментальных отличий между имитацией языка и знанием истины.

От технологии, которая просто повторяет вероятные последовательности, требуется прорыв в сторону систем, способных оперировать фактами и логикой. Только так мы сможем построить действительно полезные и надежные ИИ, которых можно будет не просто любить и использовать, но и по-настоящему доверять.