Многокритериальная оптимизация оказалась одной из самых сложных и актуальных задач в современной науке и технике. В отличие от классических проблем оптимизации с одной целевой функцией, многокритериальные задачи требуют одновременного решения нескольких задач, зачастую конфликтующих друг с другом. Поиск сбалансированных решений, известных как достижения Парето, порождает множество новых вызовов и требует новых подходов. В последние годы на передний план выходят методы глубокого обучения и усиленного обучения, которые демонстрируют впечатляющие результаты в решении этих сложных проблем. Глубокое обучение (Deep Learning) — это направление машинного обучения, базирующееся на искусственных нейронных сетях с большим числом слоёв и параметров.

Его основное преимущество – способность автоматически извлекать признаки из необработанных данных и моделировать сложные зависимости. Усиленное обучение (Reinforcement Learning) основано на принципе обучения агентов взаимодействию с окружающей средой через получение наград, что хорошо подходит для поиска оптимальных стратегий поведения. В многокритериальной оптимизации эти методы могут применяться по-разному. Прежде всего, можно использовать глубокие нейронные сети для аппроксимации функции стоимости или сложных зависимостей между переменными задачи. Это особенно полезно, когда аналитическая модель неопределённа или слишком сложна.

Усиленное обучение же способно обучать агента находить эффективные решения, которые представляют собой компромиссы между несколькими целями. Одним из основных трудностей в применении этих методов является необходимость учёта нескольких конкурирующих целей одновременно. Самый простой подход для многокритериальной оптимизации через глубокое обучение – это сведение нескольких целей к одной при помощи взвешенного суммирования (линейная или нелинейная композиция). Однако такой метод имеет очевидный недостаток – требуется заранее знать предпочтения и веса, что снижает гибкость модели. Кроме того, при смене предпочтений нужно переобучать модель.

Более продвинутые методы предлагают учиться политике поведения, которая способна адаптироваться к разным предпочтениям в реальном времени. В рамках усиленного обучения речь идёт о развитии многоцелеого усиленного обучения (Multi-Objective Reinforcement Learning, MORL), где агент обучается не на одну, а несколько функций вознаграждения. При этом зачастую пытаются обучить универсальную стратегию, которая способна менять своё поведение в зависимости от вектора весов целей, подаваемого как дополнительный вход. Такая гибкость позволяет динамически переключаться между разными компромиссами, не переобучая весь алгоритм. Середина и ключевой момент успешного применения MORL заключается в решении проблемы конфликта между целями.

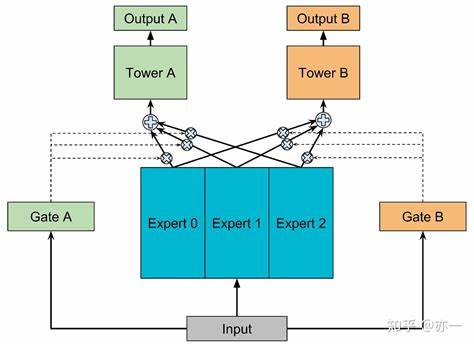

Одновременное обучение на несколько задач может привести к ситуации, когда обновления модели для одной цели ухудшают показатели по другой. Для борьбы с этим в современных исследованиях применяют методы регуляризации и разделения знаний. Так, одна из новаторских идей состоит в обучении целевой модели в латентном пространстве с введением специальных регуляризаторов, которые ограничивают конфликтующие градиенты. Например, использование механизмов, подобным Conflict Objective Regularization (COR), помогает уменьшить взаимное влияние оптимизаций целей и сохраняет качество обучения для каждой задачи. Важную роль в этой области играет разработка универсальных архитектур нейронных сетей, способных эффективно обрабатывать не только данные состояния, но и параметры предпочтений.

Эти модели обучаются условно, то есть принимают на вход вектор, отражающий важность каждой из целей, и выдают оптимальную политику поведения под конкретные требования. Такая методика помогает добиться высокого качества обобщения и быстро адаптироваться к изменяющимся условиям. Области применения этих технологий очень широки. В робототехнике часто встречаются задачи, где роботу необходимо одновременно экономить энергию, повышать скорость и обеспечивать безопасность. Глубокое и усиленное обучение позволяют формировать такие стратегии, которые не просто решают одну задачу, а учитывают всю совокупность требований, что особенно ценно при взаимодействии с реальным миром.

В промышленности, например, при планировании производства или логистике, нужно балансировать между издержками, временем выполнения и качеством продукта. Здесь также методы многокритериальной оптимизации с глубоким обучением находят широкое применение. В рекомендательных системах и маркетинге также ребром стоит необходимость учитывать несколько метрик одновременно – удержание пользователей, конверсия, доход и удовлетворённость. Усиленное обучение с многокритериальной постановкой задачи помогает строить динамические модели, которые в любой момент времени могут менять приоритеты и приводить к оптимальным бизнес-решениям. Для практического применения зачастую используются смешанные методы, которые сочетают эволюционные алгоритмы, обучение с подкреплением и глубокие нейросети.

Например, начальное приближение для решения задачи даёт эволюционный алгоритм, затем полученное решение уточняется с помощью глубокой модели с усиленным обучением. Такое гибридное решение позволяет пользоваться преимуществами каждого подхода: глобальной обзорности эволюционных методов и адаптивности глубокого обучения. Несмотря на высокие результаты, перед специалистами стоят и вызовы. Одним из ключевых является вычислительная сложность и большие требования к данным. Многокритериальные задачи и универсальные политики требуют значительных ресурсов для обучения, что ограничивает быстроту экспериментов.

Однако это постепенно компенсируется развитием аппаратного обеспечения и оптимизаций самих алгоритмов, таких как асинхронное обучение и дистилляция моделей для уменьшения веса. Перспективы развития в этом направлении связаны с развитием алгоритмов метаобучения, которые обучаются учиться. Такие модели смогут не просто решать задачи с текущими приоритетами, а автоматически адаптироваться к новым, ранее не встречавшимся целям и ограничениям, значительно расширяя применимость глубокого и усиленного обучения в многокритериальной оптимизации. Подводя итог, можно сказать, что интеграция глубокого обучения и усиленного обучения открывает новые горизонты в решении многокритериальных задач. Использование таких современных методов позволяет не только повысить качество решений, но и создавать гибкие, адаптивные системы, приспособленные к динамично меняющимся требованиям.

С развитием теоретических основ и инструментов программирования эти технологии станут неотъемлемой частью множества практических приложений, от автономных систем до сложных промышленных процессов.