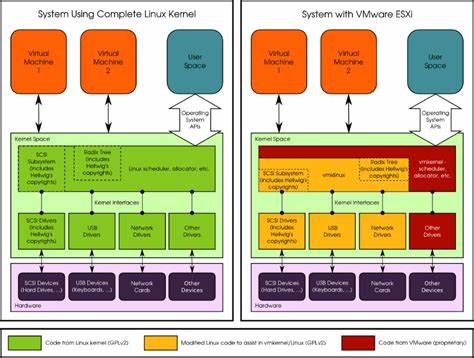

Линукс является фундаментальной основой для множества современных устройств, от смартфонов до встраиваемых систем. Эта операционная система и ее ядро распространяются под лицензией GPL - лицензией с сильной копилефт-защитой, что гарантирует пользователям доступ к исходному коду и возможность модификации. Однако в реальности многие производители устройств нарушают эту лицензию, распространяют модифицированные версии ядра и при этом не публикуют исходный код, что ставит пользователей в очень сложное положение. Один из способов вернуть контроль и получить доступ к коду - это процесс декомпиляции, при котором из бинарных файлов восстанавливается исходный код. В последние годы для решения этой задачи исследователи стали применять эволюционные алгоритмы, что открывает новые возможности, но одновременно сталкивается с серьезными вызовами.

Декомпиляция - это процесс преобразования машинного кода обратно в более высокоуровневый язык программирования, например, на C. Такая задача чрезвычайно сложна, так как компиляция не является обратимой операцией по своей природе, а деобфускация и различия в оптимизациях компилятора только усложняют ситуацию. Особенно интересен вариант, когда необходимо добиться не просто приблизительного семантического совпадения с бинарным кодом, а полного, точного совпадения на байтовом уровне. Это требование предъявляется для того, чтобы гарантировать, что восстановленный код при повторной компиляции генерирует абсолютно идентичный бинарник, что существенно повышает точность и достоверность декомпиляции. Столкновение с действительностью нарушений GPL на рынке достаточно остро стоит в случае устройств с встраиваемыми системами, таких как электронные книги и смартфоны на базе ядра Linux.

Производители, модифицируя ядро под свои нужды, по закону обязаны раскрывать исходные коды этих модификаций, но часто игнорируют это требование. Пользователи, в свою очередь, лишены возможности изучить, понять и, при необходимости, улучшить программное обеспечение своих устройств. В такой ситуации декомпиляция становится не просто технической задачей, а инструментом защиты прав и свободы пользователей. Попытки решить проблему традиционными методами декомпиляции часто оказываются недостаточно эффективными, особенно при работе с большими и сложными бинарными файлами, такими как ядро Linux. Здесь на помощь приходят эволюционные алгоритмы - класс методов оптимизации, вдохновленных процессом естественного отбора.

Главная идея заключается в том, чтобы начать с набора случайных или приближенных решений - в нашем случае, вариантов исходного кода - и постепенно улучшать эти решения, оценивая их качество по тому, насколько их компиляция соответствует исходному бинарному файлу. Эволюционные алгоритмы отличаются тем, что работают с целой популяцией возможных решений одновременно, применяя операции селекции, кроссовера и мутации, что позволяет эффективно исследовать пространство программного кода. В контексте декомпиляции это означает, что алгоритм может одновременно изучать множество вариантов исходного кода, постепенно рождая более точные и компактные программы, которые при компиляции порождают код, максимально близкий к исходному бинарнику. Практическое применение таких алгоритмов к задаче декомпиляции ядра Linux - это серьёзный вызов. Одним из ключевых требований является точное совпадение на уровне байтов, что сильно ограничивает пространство допустимых решений и требует высокой производительности алгоритма.

Кроме того, для корректной работы необходимы знания о компиляторе, версии и параметрах сборки, так как они напрямую влияют на структуру и поведение бинарного кода. Без этих данных сложно добиться полного соответствия. Важной частью процесса является представление исходного кода в виде абстрактного синтаксического дерева (AST), что позволяет алгоритму оперировать грамматически правильными фрагментами программы, избегая создания синтаксически некорректных решений. Это существенно снижает размер поискового пространства и увеличивает шансы на успешное восстановление корректного кода. При этом можно ограничить использование некоторых сложных конструкций языка С, упростив структуру программы без потери функциональности, что поможет алгоритму быстрее конвергировать к искомому решению.

Одной из самых перспективных стратегий для формирования начальной популяции решений является задействование существующих, возможно некорректных и неполных, версий исходного кода, полученных с помощью традиционных декомпиляторов или нейросетевых моделей. Это позволяет избежать необходимости начинать с полностью случайных вариантов и сосредоточиться на их улучшении, что значительно ускоряет процесс. Однако стоит отметить, что даже современные нейросетевые модели, обученные на огромных массивах исходного кода, редко способны напрямую решить задачу точной байтовой эквивалентной декомпиляции. Основная сложность состоит в необходимости учитывать все нюансы компиляции и специфичных оптимизаций, которые алгоритмы машинного обучения зачастую не моделируют в полной мере. Поэтому нейросети стоит рассматривать скорее как вспомогательный инструмент, а не единственное решение.

Еще одна важная сфера применения эволюционных алгоритмов в данном контексте - это возможность сделать восстановленный код более читаемым и пригодным для дальнейшей разработки. После того, как исходный код, эквивалентный бинарному, найден, можно применить дополнительные методы для улучшения структуры, именования переменных, функций и модулей, что облегчает понимание и последующую поддержку программы. Для этой задачи отлично подойдут техники, вдохновленные генетическим улучшением программ и модификациями, управляемыми искусственным интеллектом. Помимо технических сложностей, важны и этические и юридические аспекты деобфускации и декомпиляции. Использование полученных таким образом данных должно строго соответствовать законодательству и условиям лицензий.

В случаях GPL, процедура декомпиляции, направленная на обеспечение соблюдения лицензии и прав конечных пользователей, рассматривается многими специалистами как оправданная и законная мера. Стоит отметить, что эволюционные алгоритмы имеют долгую историю и широкое применение в области оптимизации, что дает уверенность в их надежности и возможности адаптации к сложным задачам декомпиляции. Их способность работать с большими и сложными пространства поиска делает их подходящими для системного кода, таким как ядро Linux, хотя практическая реализация потребует глубокого знания как предметной области, так и методов оптимизации. В перспективе, развитие интеграций эволюционных алгоритмов с другими современными технологиями, такими как инструменты статического и динамического анализа, машинное обучение и формальные методы доказательства эквивалентности, может привести к созданию гибридных систем декомпиляции, обладающих высокой точностью и производительностью. Это откроет новые горизонты для обеспечения прозрачности программного обеспечения и борьбы с нарушениями лицензий.

Разработка подобных инструментов особенно актуальна для устройств с ограниченными средствами коммуникации и поддержки со стороны производителей, таких как электронные книги на базе Linux. В странах и сообществах, ориентированных на свободное программное обеспечение и пользовательские права, такой подход станет мощным инструментом в борьбе за открытость и контроль над технологиями. В итоге, декомпиляция ядра Linux с применением эволюционных алгоритмов - задача амбициозная и трудоемкая, но обладающая значительным потенциалом для решения насущных проблем нарушений GPL. Это новая веха в области обратного проектирования программного обеспечения, которая требует объединения усилий исследователей из разных областей: от разработчиков компиляторов и системного программного обеспечения до экспертов по эволюционным методам и искусственному интеллекту. В случае успеха подобная технология способна не только помочь пользователям вернуть права на свое ПО, но и вдохновить развитие новых методов работы с бинарными файлами, повысить качество и безопасность программного обеспечения, а также укрепить позиции свободного программного обеспечения во всем мире.

Текущие исследования открывают лишь первые главы этой сложной истории, оставляя простор для дальнейших экспериментов и прорывов в области декомпиляции. Для тех, кто заинтересован в развитии данной области, важно помнить, что успешное применение эволюционных алгоритмов требует глубокого понимания структуры C-кода, особенностей компиляции и оптимизации, а также внимательного подхода к проектированию представлений и критериев оценки оптимизации. Совместная работа с сообществом открытого ПО, понимание юридических ограничений и открытость к новым технологическим решениям станут залогом прогресса в столь важной сфере. .