В последние годы кэширование становится неотъемлемой составляющей эффективной работы высоконагруженных систем, а язык Go продолжает активно развиваться как платформа для создания серверных приложений. В условиях постоянного роста требований к производительности и устойчивости сервисов выбор правильной библиотеки кэширования приобретает критическое значение. В этой статье мы подробно рассмотрим эволюцию кэш-библиотек в Go, с акцентом на их алгоритмы, архитектуру и практическое применение, а также разберём загадку нулевой статистики попаданий у Ristretto — одной из наиболее известных реализаций кэша в сообществе Go. Кэширование в Go традиционно имеет два направления развития, которые связаны с тем, как и где выделяется память для хранения данных — on-heap и off-heap подходы. Caches on-heap размещают данные непосредственно в управляемой Go среде, то есть в куче, что обеспечивает более тесную интеграцию с языковой сборкой мусора.

Off-heap кэши, напротив, выделяют и управляют памятью вне кучи, например, используя системные вызовы mmap, что помогает существенно снизить задержки, связанные с GC, и сократить накладные расходы на метаданные. Однако такой подход сопряжён с серьёзными ограничениями: управление сложнее, обычно применяется более простая политика эвикции, зачастую подобная FIFO, которая уступает по эффективности классическим алгоритмам LRU или LFU, а также возникает необходимость в дорогостоящем преобразовании ключей и значений, что снижает общую производительность. В результате off-heap кэширование оптимально только в строго ограниченных сценариях, где важна максимальная стабильность работы с практически неистекающим объемом данных и с минимальной задержкой, например, когда SLA требует удержания уровня попаданий выше 99.9%. С другой стороны, on-heap кэши предлагают более сбалансированное решение, минимизируя компромиссы между управлением памятью, функциональностью и производительностью.

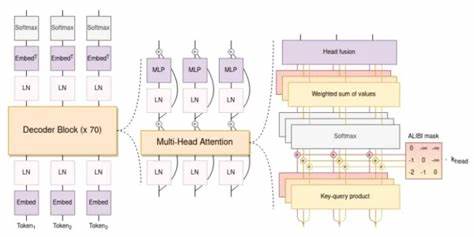

Именно развитие on-heap библиотек, благодаря активному использованию новых механизмов синхронизации и инновационных алгоритмов, стало ключевым направлением в экосистеме Go кэширования. Долгое время экосистема Go не имела продвинутых конкурентных кэшей, предлагая лишь примитивные реализации на основе мьютексов и стандартных структур данных с LRU или LFU эвикцией. Обходным путем была шардировка, позволяющая параллельно обрабатывать запросы, однако этот метод дает ограниченный выигрыш, особенно при распределении запросов по Zipf-подобным паттернам, когда одни части кэша оказываются перегруженными, а другие простаивают. Настоящий прорыв случился с появлением Ristretto в 2019 году, созданного командой Dgraph Labs. Ristretto заимствовал лучшие идеи из легендарной Java-библиотеки Caffeine, включая комплексные эвикционные стратегии TinyLFU и Doorkeeper, реализованные через Count-Min Sketch и Bloom-фильтры.

Это позволило достичь высокой пропускной способности и улучшенного коэффициента попаданий по сравнению с предыдущими решениями. Тем не менее, под поверхностью многих преимуществ Ristretto скрывались архитектурные недостатки и компромиссы, которые со временем стали очевидны. Инновация в виде введения MaxCost и учета индивидуальных затрат на запись казалась удобной — можно было задавать размер кэша не в количестве элементов, а в объеме памяти, что приближало поведение к реальным условиям эксплуатации. Однако с выходом версии 0.1.

0 появилась опция IgnoreInternalCost, которая начала учитывать накладные расходы на внутренние метаданные прямо в расчетах емкости. Это привело к масштабной несовместимости с реальными кейсами, где пользователи задавали размер через количество элементов, в итоге почти у всех тестов на Ristretto фиксировался коэффициент попаданий около нуля, что превратилось в настоящую загадку и головную боль для разработчиков. С точки зрения эвикционной стратегии TinyLFU, хотя она прекрасно работает на данных с высокой частотной сковоркой — например в поисковых системах или аналитических заданиях, её поведение на классических OLTP-нагрузках существенно уступает. Применение Bloom-фильтров вместе с Count-Min Sketch лишь усиливало смещение в одну сторону, что заметно ухудшало общую эффективность в разнообразных сценариях. К тому же, некоторые баги в реализации Count-Min Sketch до сих пор оставались не исправленными.

Для ускорения операций записи Ristretto применял своеобразный хак — в ситуациях высокой конкуренции запись в кэш могла просто «проваливаться», что помогало обходить узкие места производительности, но резко снижало коэффициент попаданий в моменты пиковых нагрузок. По мнению экспертов, такая компромисная мера является одним из факторов нестабильности результатов. Кроме того, Ristretto для экономии памяти хранит только хэши ключей без механизма обработки коллизий, из-за чего существует небольшой, но реальный риск конфликтов, что крайне нежелательно в продуктивных системах. Не было реализовано и защиты от явлений типа cache stampede или механизмов асинхронного обновления данных. В итоге, исходя из направленности разработки и ряда решений, очевидно, что Ristretto создавался прежде всего для внутренних нужд Dgraph и Badger, что приводит к узкой специализации и постепенному снижению интереса со стороны сообщества.

Аналоги и конкуренты пытались исправить эти недостатки. В 2023 году появился Theine, который внедрил некоторые более прогрессивные эвикционные методы, как адаптивный W-TinyLFU, реализовал защиту от cache stampede и расширенную политику истечения TTL при помощи иерархического таймерного колеса. Хотя Theine не приобрёл широкую известность, он используется в крупных инфраструктурных проектах вроде Vitess, подтверждая свое качество и устойчивость. Тем не менее, особенности реализации, такие как использование шардированной карты с ограничениями масштабируемости и lossy-буферов для чтения, иногда влияют на результаты при тяжелых нагрузках. Кроме того, большое количество функциональных возможностей влечет за собой накладные расходы по памяти и сложности с поддержкой.

Моя собственная разработка Otter началась с версии 1 в 2023 году как реакция на ухудшение производительности при обновлении зависимостей в проекте, изначально основанном на Ristretto. Otter v1 сфокусировался на высокой пропускной способности, благодаря применению xsync.Map и улучшенным алгоритмам адаптивной шардировки, а также попытке реализовать улучшенную политику эвикции S3-FIFO, хотя у неё тоже были свои заморочки с производительностью и защитой от атак сканирования. Otter v1 предложил одни из лучших показателей скоростей и низкую память накладных расходов, но в плане функциональности и API оставлял желать лучшего, особенно из-за отсутствия механизмов защиты от cache stampede и возможности асинхронного обновления. Рынок дополнительно получил разнообразие с появлением Sturdyc, первой библиотекой Go, которая внедрила полноценные функции загрузки и обновления кэша.

Несмотря на это, алгоритмы эвикции у Sturdyc оставались довольно простыми и неэффективными, что сказывалось на коэффициенте попаданий и производительности, а сильная привязка к ключам типа string ограничивала гибкость использования. В 2024 году появилась долгожданная версия Otter v2, которая позволила объединить лучшие практики и устранить недостатки предшественников. В ней реализованы комплексные механизмы загрузки и обновления, адаптивная политика W-TinyLFU, расширенный API с поддержкой пиннинга элементов и защитой от атак хэш-функций. Все эти нововведения сделали Otter v2 наиболее близким к идеалу по совокупности характеристик на сегодняшний день, переняв лучшие архитектурные подходы из Caffeine и адаптировав их под особенности языка Go и его среды выполнения. Однако, несмотря на все достоинства, Otter v2 пока недостаточно распространён в реальных продуктивных средах, что отчасти связано с небольшим количеством опыта использования в крупных проектах и продолжающейся интеграцией.

Процесс эволюции кэш-библиотек на языке Go наглядно показывает сложный баланс между производительностью, функциональностью и устойчивостью. Пример Ristretto с его загадкой нулевого коэффициента попаданий является уроком о важности осознанного подхода к реализации политики управления памятью и учёту всех накладных расходов, а также оценки технологических компромиссов. Лучшие современные решения успешно учатся на ошибках предшественников, создавая более универсальные и надежные инструменты для работы с кэшем. Для разработчиков на Go выбор оптимальной библиотеки кэширования сегодня требует глубокого понимания специфики нагрузки, требований к задержкам, масштабируемости и доступных в проекте ресурсов. Тщательное тестирование и мониторинг поведения кэша помогут избежать ловушек производительности и ошибок, которые могут негативно сказаться на пользовательском опыте и устойчивости приложения.

Среди всего многообразия, Otter v2 и Theine представляют наиболее продвинутые и сбалансированные варианты, в то время как Ristretto, несмотря на свою историческую значимость, требует аккуратного подхода и внимательного изучения особенностей. Таким образом, путь эволюции кэширования в Go — это динамичный процесс, отражающий стандарты современного программирования, где важна не только скорость, но и гибкость, масштабируемость, а также поддержка сложных рабочих нагрузок. Современные библиотеки постепенно достигают уровня зрелости, при котором могут обслуживать самые требовательные сервисы, обеспечивая высокую надежность и эффективность работы.