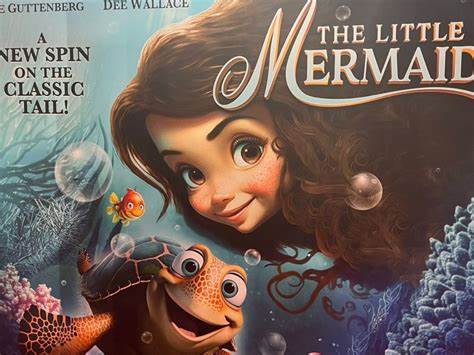

В эпоху стремительного развития технологий, искусственный интеллект (ИИ) всё чаще оказывается в центре внимания. Одной из самых последних и тревожных тем стало использование ИИ для имитации голосов людей, что вызывает серьёзные опасения по поводу безопасности личных данных и авторских прав. В этом контексте эксперты предупреждают о новом виде мошенничества, которое связано с известным мультфильмом «Русалочка» и его персонажем, ставшим предметом манипуляций. Недавние исследования показали, что мошенники начинают активно использовать технологии ИИ для создания подделок голосов, что приводит к значительным последствиям. На фоне популярности новых релизов, таких как «Русалочка», возрождающего интерес к классической истории, мошенники находят способы использовать этот интерес в своих целях.

Одна из таких схем включает в себя создание цифровых клонов голосов известных персонажей или даже реальных людей, что может привести к финансовым потерям и утратам репутации. Эксперты предупреждают, что такая подделка может быть использована для мошеннических действий. Например, злоумышленники могут создать аудиозапись, которая будет казаться сделанной настоящим человеком, и использовать её для получения денег, манипулирования мнениями или даже распространения дезинформации. Будь то голос родного человека, друга или кумира, его использование в мошеннических схемах становится всё более распространённым. Также стоит задуматься о юридических аспектах использования таких технологий.

Вопросы авторских прав и права на образ становятся актуальными как никогда. На сегодняшний день законодательство развивается не так быстро, как технологии, что оставляет много лазеек для мошенников и неправомерного использования интеллектуальной собственности. Тем не менее, защитить себя от возможных рисков можно, следуя нескольким рекомендациям от экспертов. Первое, на что стоит обратить внимание, — это создание привычного контента с вашей собственной уникальной интонацией и особенностями. Регулярное использование собственного голоса в публичных или бизнес-целях поможет сформировать "отпечаток" звучания, который будет более трудным для подделки.

Важно также быть осведомлённым о современных технологиях и методах, используемых мошенниками. Уделите время изучению, как работают приложения и сервисы, которые используют ИИ для синтеза голоса. Если вы понимаете, как они функционируют, вы сможете лучше защитить себя от их ненадлежащего использования. Кроме того, существует ряд технологий и инструментов, которые могут помочь обнаружить подделки голоса. Некоторые из них могут анализировать аудиофайлы и выявлять несоответствия, которые свойственны искусственно созданным записям.

Такие инструменты становятся всё более доступными, что может значительно повысить уровень защиты пользователей. Эксперты также рекомендуют следить за теми аудиозаписями, которые вы получаете. Если вам прислали голосовое сообщение от знакомого, которое звучит подозрительно или вообще не похоже на его привычный стиль, не стесняйтесь задать вопросы или уточнить информацию. Необходимо сохранять бдительность и критическое мышление. Помимо этого, важно информировать людей о таких рисках и обучать их различать подделки от подлинных голосов.

Образовательные программы, семинары и различные мастер-классы могут помочь повысить осведомлённость о проблеме. В конечном итоге, чем больше людей будет осведомлено о технологии, тем сложнее станет мошенникам использовать её в своих целях. Нельзя забывать и о правительственных инициативах. На уровне законодательства крайне важно разработать новые нормы и правила, которые бы регламентировали использование технологий синтеза голоса, а также предусматривали бы ответственность за их неправильное использование. Многие страны уже начинают рассматривать данный вопрос, и, возможно, в ближайшем будущем мы увидим новые законы, направленные на защиту персональных данных и авторских прав.